Lorsque vous lancez un audit avec Audit de site, nous envoyons un robot d’exploration pour analyser les pages que vous avez spécifiées à la configuration de l’outil.

Cependant, il est possible de rencontrer des problèmes liés à l’exploration, tels que :

- Le robot explore le site trop rapidement, ce qui peut temporairement faire planter le site ou le ralentir pour les utilisateurs.

- Le robot explore le site trop rapidement, ce qui empêche certaines pages de se charger correctement. Semrush signale alors de faux positifs, c’est-à-dire des problèmes dans votre audit qui ne se seraient pas affichés si l’exploration avait été plus lente et que le site n’avait pas planté.

- L’exploration du site prend trop de temps, ce qui retarde la réception de vos résultats.

Accélérer l’audit

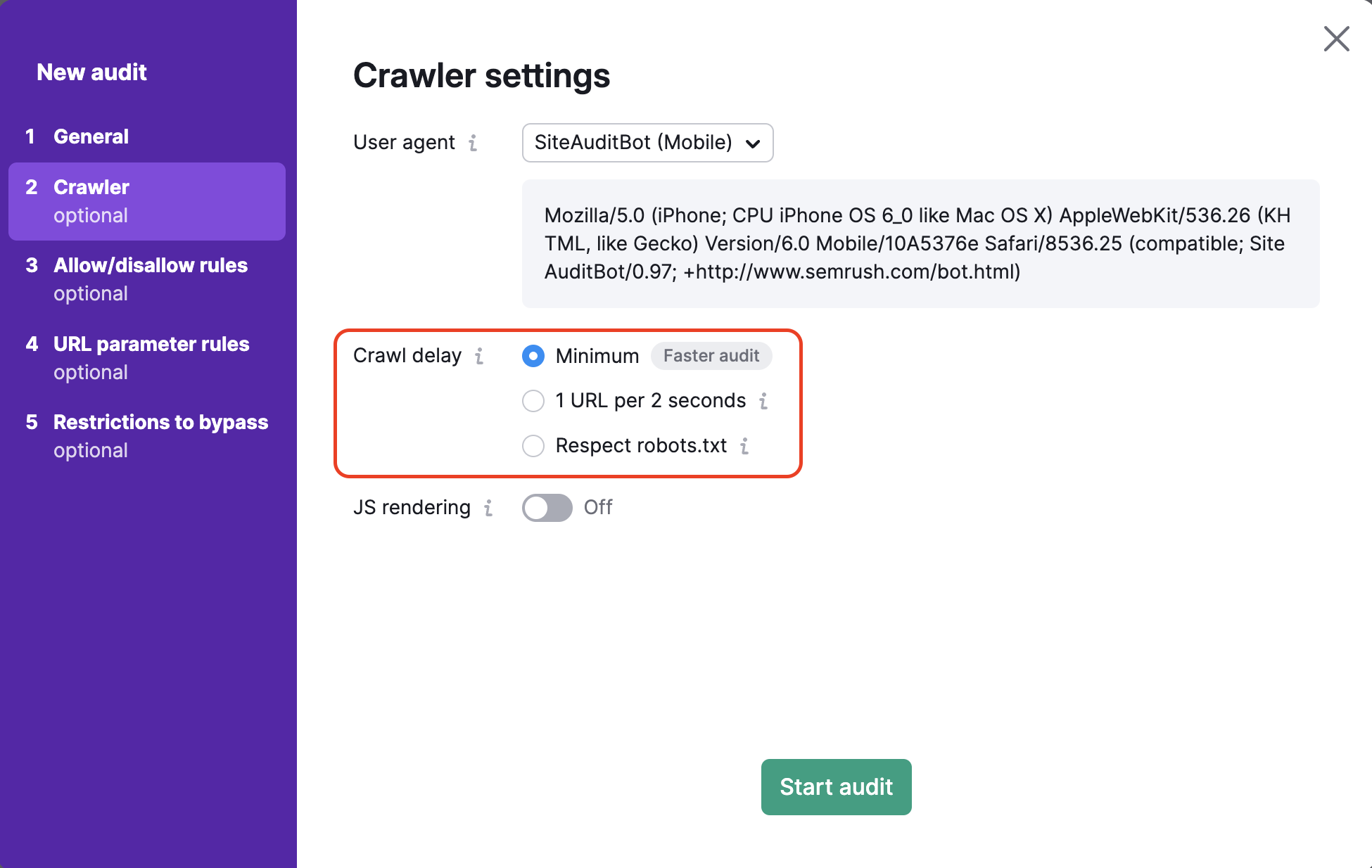

Si votre audit est trop lent, vous pouvez accélérer l’exploration dans l’étape des paramètres du robot, lors de la configuration.

Pour accélérer l’audit, sélectionnez « Minimum » afin d’explorer le site le plus rapidement possible.

Cette action permet à notre robot d’ignorer les instructions de délai d’exploration définies dans le fichier robots.txt du site et d’effectuer l’exploration à la vitesse maximale.

Si la vitesse d’exploration reste insuffisante, une autre solution consiste à améliorer la vitesse de chargement des pages. En effet, des pages lentes ralentissent l’exploration.

Gardez toutefois à l’esprit qu’un robot qui explore un site trop rapidement peut provoquer un ralentissement de l’expérience utilisateur.

Dans certains cas, ralentir l’exploration est donc plus judicieux que de l’accélérer.

Ralentir l’audit

Si votre audit explore le site trop vite, cela peut temporairement faire planter le site, ralentir l’expérience utilisateur et générer des faux positifs dans les résultats. Ralentir la vitesse d’exploration permet d’obtenir des résultats plus représentatifs de l’expérience réelle d’un visiteur.

Pour cela, plusieurs options sont disponibles dans la configuration.

- Demandez à Semrush d’explorer 1 URL toutes les 2 secondes : cela évite de surcharger le serveur avec trop de requêtes en peu de temps.

- Définissez un délai personnalisé dans le fichier robots.txt du site. Si vous activez l’option « Respecter le robots.txt » lors de la configuration, notre robot appliquera la vitesse définie.

Par exemple, si vous définissez un délai de 5 secondes, notre robot attendra 5 secondes entre chaque page. Ainsi, l’exploration se fera à un rythme qui ne risque pas de perturber le fonctionnement du site (voir ci-dessous).User-agent: SemrushBot Crawl-delay: 5 User-agent: SiteAuditBot Crawl-delay: 5

Remarque : le délai maximal que notre robot peut respecter est de 30 secondes. Toute valeur supérieure sera ramenée à 30.

Vous rencontrez toujours des problèmes ? Consultez notre guide de dépannage ou contactez notre service d’assistance.