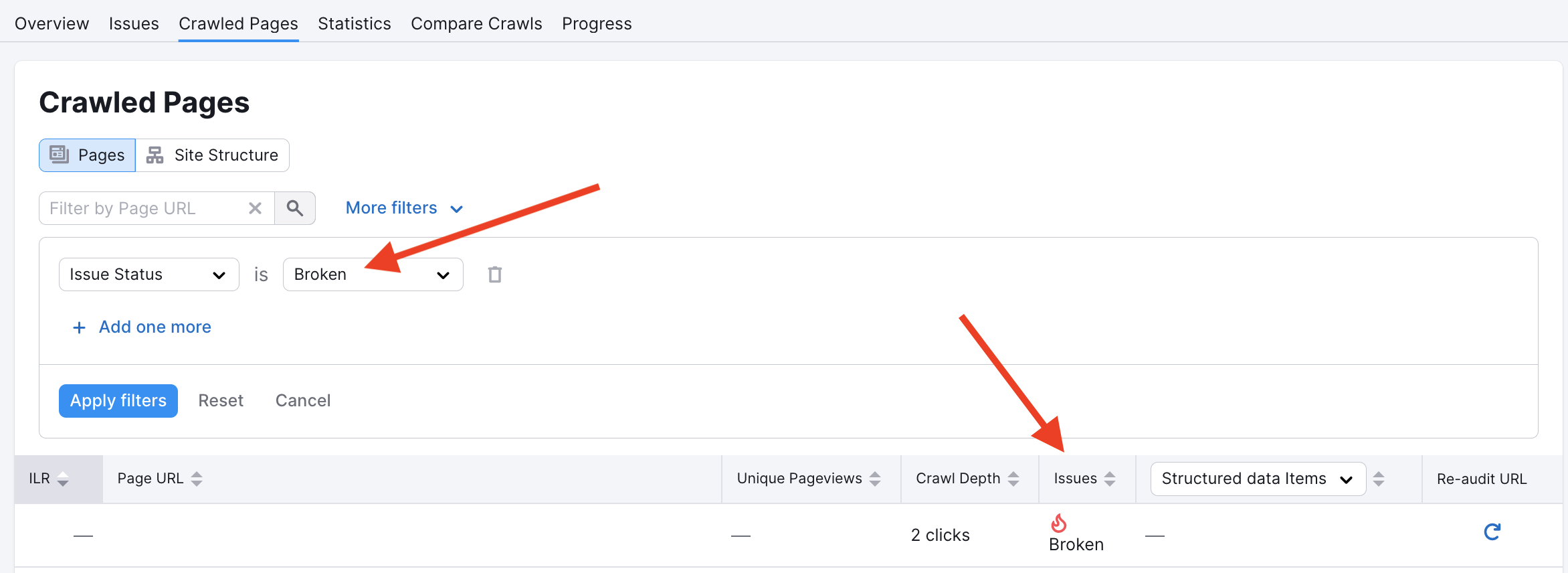

Pourquoi certaines pages fonctionnelles de mon site apparaissent-elles comme rompues ?

Parfois, Audit de site signale certaines pages internes comme rompues alors qu’elles restent entièrement opérationnelles. Même si ce cas est rare, il peut dérouter certains utilisateurs.

Dans la plupart des cas, cela provient d’un faux positif. Voici les quatre causes les plus fréquentes de faux positifs :

- notre robot d’exploration Audit de site peut être bloqué sur certaines pages par le fichier robots.txt ou des balises noindex ;

- les hébergeurs peuvent bloquer les robots Semrush, les prenant pour une attaque par déni de service (DDoS), en raison d’un grand nombre de requêtes sur une courte période ;

- au moment de la nouvelle exploration, le domaine n’a pas pu être résolu par le système DNS ;

- le cache du serveur Web stocke d’anciennes données et les fournit aux robots d’exploration.

Si vous pensez que cela provient d’un problème lié au robot d’exploration, vous pouvez apprendre à résoudre les problèmes de votre fichier robots.txt grâce à cet article.

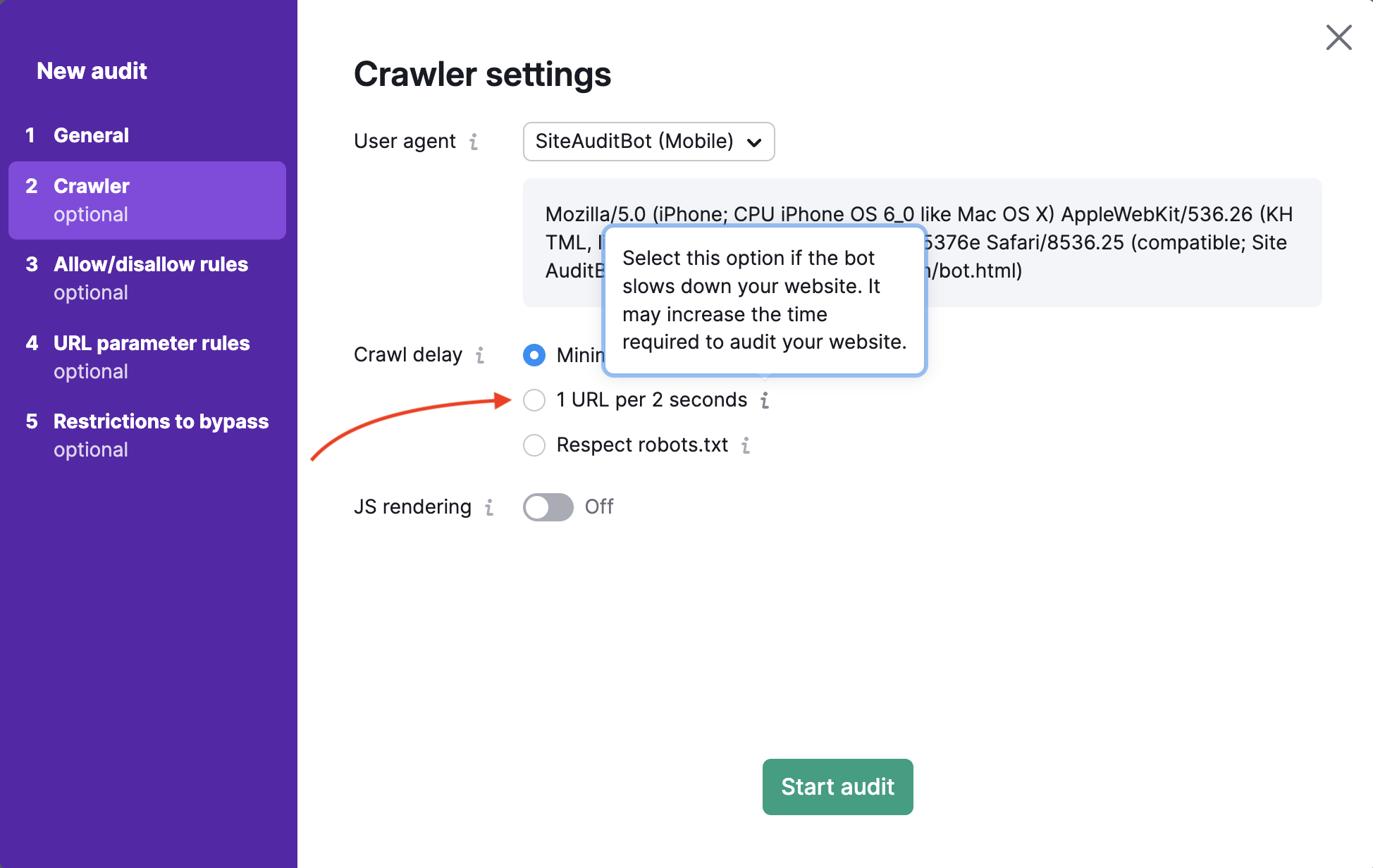

Vous pouvez également réduire la vitesse d’exploration afin d’éviter un grand nombre de requêtes simultanées sur vos pages. C’est pourquoi une page peut effectivement fonctionner correctement, alors que notre robot ne parvient pas à y accéder et signale un faux positif.

Pour résoudre le problème lié au cache serveur, essayez de le vider, puis relancez Audit de site : vous obtiendrez ainsi des résultats actualisés prenant en compte toutes vos corrections.