Si la plupart d'entre nous connaît déjà bien le concept du netlinking, les mécaniques complexes à l'oeuvre derrière les métriques, les pénalités et le positionnement d'un site sont parfois moins bien connues.

Vous avez peut-être assisté au webinar consacré au développement d'une stratégie de netlinking casté par Nicolas Mercatili, ambassadeur SEMrush ? Cet article va en reprendre les grandes lignes et décrypter la relation entre l'optimisation on-site et off-site et la stratégie de backlink.

Un petit rappel des bases du SEO, toujours bon à prendre

Comme vous le savez, le SEO se concentre sur le moteur de recherche Google, qui représente en juin 2020 93% des requêtes des internautes en France. C'est dire le nombre d'enjeux qui découlent de la visibilité d'un site sur internet. Quand on ajoute à ça le fait que 91% des clics des internautes se font sur la première page... on comprend aisément pourquoi la première place sur la première page des Search Engine Result Page est l'objet de tant de batailles.

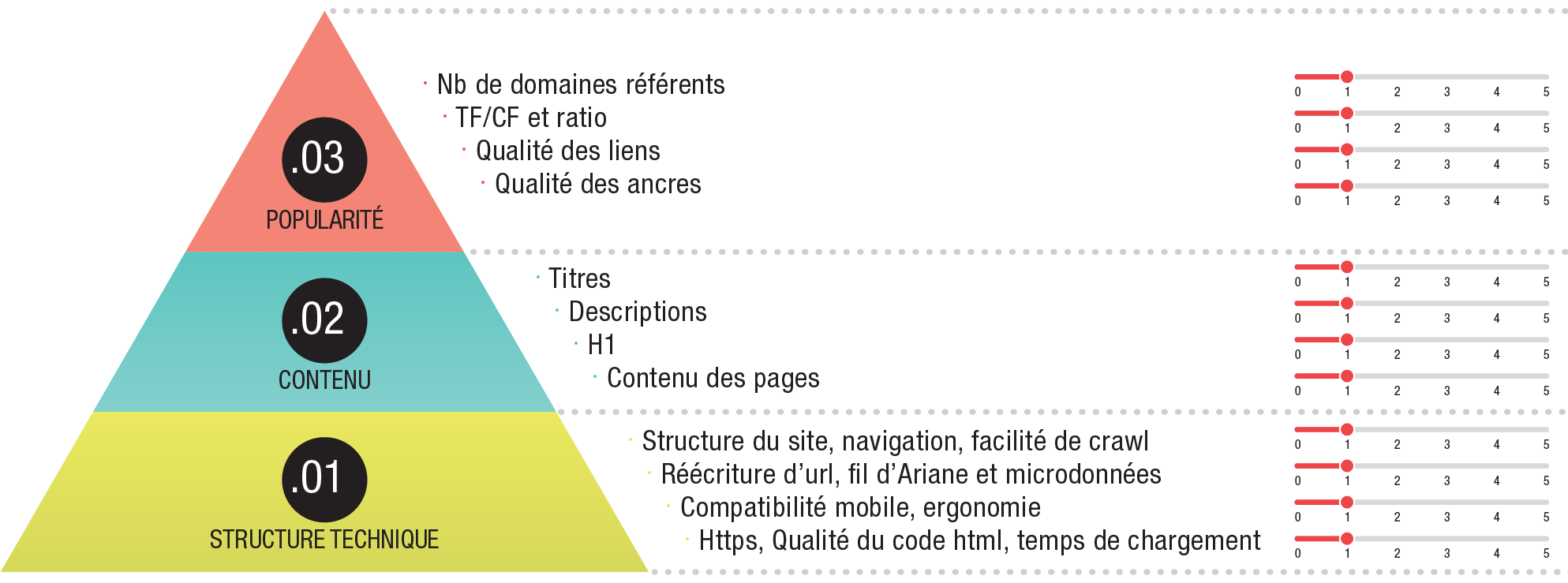

Le Search Engine Optimization est souvent explicité sous la forme d'une pyramide divisée en trois parties : un socle on-site constitué par la structure du site web, sur lequel repose le cœur (le contenu), et enfin, la top part qui représente la popularité (domaine off site, qui concerne les backlinks).

Cette image très parlante rappelle bien l'importance des critères on-site pour des bases SEO solides, ainsi que la notion d'interdépendance de ces critères qui reposent les uns sur les autres, mais il est intéressant d'analyser ces mécaniques plus avant afin de bien en saisir tous les enjeux.

Je veux que mon site soit sur la première page de Google

On connaît tous cette chanson : c'est LA phrase que tous les professionnels du netlinking entendent systématiquement. Oui, tous les clients veulent absolument voir leur money site figurer à la meilleure place des SERP. Normal : leurs revenus et ceux de leurs familles en dépendent directement.

Sauf que ce n'est pas si simple que ça ! Le client qui se tourne vers le netlinking exprime simplement un besoin, et charge au strateur d'y répondre tout en restant sous le radar de Google. Un équilibre délicat qui n'est pas toujours maîtrisé... ou maîtrisable.

En effet, le classement des résultats de recherche de Google se base sur un algorithme dont on ne connaît pas l'exacte teneur. C'est un jeu du chat et de la souris entre les netlinkeurs et les développeurs de Google : quel poids accorder à quel critère ? Comment filtrer les résultats pour sélectionner uniquement les sites pertinents pour l'internaute ?

Difficile de deviner ce qui est en jeu en regardant uniquement le positionnement des sites web sur une page de résultats de requête. C'est là que les métriques, particulièrement les métriques-clé (KPI pour les intimes) interviennent. Ces chiffres, issus d'outils d'analyses comme SEMrush, vont venir donner aux professionnels du netlinking des éléments fiables pour examiner l'effet de leurs stratégies. Sauf que là encore, pour faire du bon travail, il faut bien comprendre comment fonctionnent les différents rouages de la chose.

Qu'est-ce qu'une bonne stratégie de netlinking ?

C'est là qu'on voit arriver les clients du netlinking (et parfois certains pros) du type « amateur éclairé », ceux qui vont se focaliser sur un seul élément (exemple : le TrustFlow) en dépit de tous les autres pour juger de la qualité d'un site.

Certes, faire bouger le curseur d'une métrique peut avoir des effets positifs (ou négatifs), mais à trop pousser les extrêmes, on court le risque de prendre une pénalité. L'algorithme de Google n'est pas si simple à manipuler, et en réalité, de nombreuses métriques et interdépendances sont à l'œuvre en coulisses.

Pour éviter de se retrouver blacklisté, il faut jouer sur tous les fronts, on-site et off-site. Travailler une stratégie de liens sans optimisation du site web, ou l'inverse, n'apportera pas de résultats aussi performants que la combinaison des deux. De même, les stratégies qui jouent sur une faille du système ont leurs limites : les développeurs connaissent les défauts de leur algorithme et à chaque nouvelle mise à jour, ceux qui bénéficient de leurs effets courent le risque de chuter au fin fond des SERP.

La prudence avant tout

Sans travailler son SEO, un site tout neuf (mais bien conçu) peut mettre de nombreux mois à « monter » dans le top 10 des SERP sur une expression concurrentielle. Avec le bon procédé, ces résultats peuvent être obtenus en quelques mois, et surtout, surtout : être stables.

Pour reprendre ma phrase fétiche, « le netlinking, c'est un travail d'endurance ». Si la plupart des netlinkers ont bien compris que les fermes à liens et autres sites spammy sont des techniques à oublier depuis longtemps, derrière une promesse trop belle peut se cacher un Private Blog Network mal maîtrisé, une croissance trop rapide, sans subtilité, et d'autres stratégies instables qui tôt ou tard finiront par s'écrouler ou se faire détecter.

Un vrai travail de fond est nécessaire pour établir une stratégie plus solide, des résultats plus durables et surtout, moins risqués. La recette du netlinking « propre », c'est le naturel : vous savez ce que Google veut voir, alors donnez-le-lui à manger !

La bonne stratégie va donc se jouer sur plusieurs fronts :

-

l'autorité du site web : pour faire évoluer ce point, on va transférer la popularité de sites bien placés au site du client via des backlinks. On verra lesquels et comment un peu plus loin.

-

la position du site du client : on va chercher à la faire évoluer sur des SERP bien précises, en sélectionnant soigneusement

-

les mots-clés : il s'agira ici de faire « monter » tous les mots-clés du site, mais en privilégiant les mots clés les plus importants

Ce que veut voir Google, c'est de la cohérence. Un tout jeune domaine qui reçoit soudainement une pluie de liens provenant de gros médias, des liens insérés dans un contenu qui n'a pas de connexion sémantique avec la page de destination, des liens en nombre et par vagues régulières qui pointent en masse sur une page interne de ventes : autant de pratiques qui vont déclencher les alarmes tôt ou tard !

Concevoir une stratégie naturelle de liens

Souvent, le client va vouloir pousser une page précise (de vente en général). Or, toutes les stratégies de netlinking ne sont pas adaptées à tous les cas : c'est l'audit du site complet qui va déterminer les points à faire évoluer, afin d'établir une stratégie sur mesure.

La page d'accueil et le menu de navigation

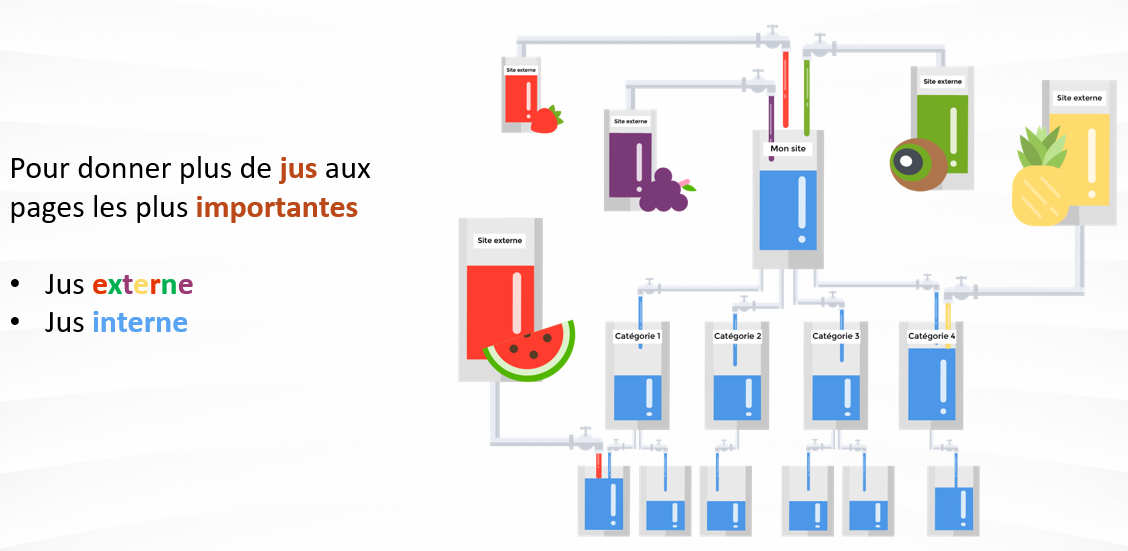

Commençons par un point crucial, pourtant souvent négligé : la qualité de la page d'accueil. En effet, elle joue le rôle de « moulinette », dans le sens où c'est elle qui va redistribuer la popularité reçue des backlinks vers les pages internes.

Pourquoi ? Parce que lorsqu'on cite un site web naturellement dans un article, par exemple en tant que source, on le désigne souvent par sa homepage. Logiquement, pour Google, la page d'accueil est donc extrêmement importante. Mais si la quantité/qualité des backlinks est le facteur de classement le plus important pour Google, la qualité du contenu des pages cibles arrive juste derrière en deuxième position.

L'optimisation de la page d'accueil commence par sa fluidité : trop souvent, les homepages sont lourdes, longues à charger, avec des images non optimisées, des bannières énormes, des méga-menus de navigation et un contenu très bref, simplement réassurant. Une page trop lente à charger va faire augmenter le taux de rebond et envoyer un signal négatif à Google : il faut commencer par faire le ménage et alléger la page au maximum, tout en la rendant attrayante.

Dans un deuxième temps, il convient d'épurer les menus au maximum tout en préservant l'expérience utilisateur : les robots de Google ont du mal à crawler les contenus trop profonds. Les menus mal catégorisés ou les méga-menus à sous-sous-sous-catégories seront contre-productifs. Pour optimiser la navigation on-site, il conviendra donc d'en masquer une partie au moyen de l'obfuscation ou du cloaking. De la même manière, les pages qui contiennent beaucoup de contenu dupliqué sémantiquement peu intéressant comme les CGU ou la page de contact peuvent aussi être masquées, en indiquant aux robots de Google de ne pas les prendre en compte.

Ce qui nous mène au point suivant : la sémantique, justement, c'est à dire le champ lexical relatif à l'activité du site, son thème. Ces informations doivent bien figurer sur la homepage : le mieux est encore d'y faire figurer une description des services et produits d'au moins 250 mots (mais 500, c'est mieux) contenant les mots-clés et le champ lexical qui convient.

Des outils d'analyse sémantique comme YourTextGuru ou SEO Quantum vont aider à suggérer un nuage de mots-clés appropriés à insérer dans les contenus, ainsi que des expressions associées, et indiquer la fréquence optimale à laquelle répéter ces éléments sans exagérer. Le naturel est primordial : on bannit les répétitions abusives, les insertions absurdes, les fautes (le fameux « accueil » !), la langue mal maîtrisée, les tournures trop alambiquées, les tournures négatives et la voix passive.

Cette optimisation de la page d'accueil garantira une meilleure répartition du jus SEO dans les pages internes.

Les pages internes

Les pages internes et pas seulement la page-cible doivent également bénéficier de l'optimisation on-site, notamment au moyen du maillage interne. Les en-têtes et les footers trop lourds qui se répètent sur toutes les pages ne sont pas forcément intéressants, il vaut mieux les dissimuler aux yeux des robots. Faites le ménage, en prêtant attention aux pages zombies, aux pages vides ou dupliquées qui envoient un signal de mauvaise qualité.

Si le lien est roi, le contenu aussi : une recommandation qu'il va falloir appliquer sur toutes les pages du site au moyen de liens internes qui les relient entre elles et de contenus sémantiquement optimisés. En effet, l'algorithme de Google est tout à fait capable de faire la connexion entre un lien, sa page de destination et le sens du texte dans lequel il est inséré (et la qualité du texte aussi). Le but ici est de créer un cocon sémantique riche, un nuage de termes relatifs à l'activité du site.

Les textes longs, bien maillés en interne, seront donc à privilégier (1000 mots ou plus). Chaque contenu devra être hiérarchisé, avec des titres sémantiquement pertinents et balisés correctement pour envoyer un bon signal lors du crawl.

Le profil de liens

« Pour Google, les amis de mes amis sont mes amis, et plus on parle de vous, plus vous êtes célèbre. », ce qui illustre bien le « flux d'autorité », la relation de cause à effet entre un lien posé sur un site et le transfert de popularité qui s'ensuit. Pour devenir une référence dans un domaine, un nouveau site doit être recommandé par des sites déjà bien placés... mais dans le même thème.

Le profil de liens du site client doit donc être cohérent et surtout, provenir de sources qualifiées. On va ici examiner les metrics du site qui va publier le lien, mais également la pertinence du contenu dans lequel celui-ci sera intégré. En effet, qu'est-ce qu'un lien qui pointe vers une page de vente de voitures d'occasion ferait dans un article consacré à l'entretien d'une piscine ? Si l'internaute se pose cette question, Google aussi !

L'idée du netlinking propre sera d'éviter de laisser des traces (footprints) derrière une action, car les robots de Google sont tout à fait capables de remonter des pistes, même complexes. Les PBN évoqués en début d'article en sont un bon exemple : à la moindre suspicion de manipulation, si Google peut d'une manière ou d'une autre prouver la relation entre les sites et déterminer qu'ils appartiennent tous au même propriétaire, la sanction peut tomber sur l'ensemble du réseau et entraîner la chute de nombreux sites clients derrière lui. Le meilleur moyen de rester sous les radars reste d'imiter le processus naturel au plus près, en fournissant des liens provenant de profils cohérents, de qualité et surtout variés, après d’éditeurs de sites différents.

Il s'agit ici de brouiller les pistes au maximum, en publiant sur des sites de qualité, thématisés, au domaine jeune ou ancien, disposant d’une autorité plus ou moins forte, en quantité plus ou moins élevée, etc. Cette façon de faire sans pattern précis permet de rester sous le radar.

Comment sortir du bac à sable de Google ?

Pour des raisons de performance, l'algorithme de Google ne contrôle pas à 100% tous les points de tous les sites web qu'il crawle. C'est particulièrement vrai au-delà d'une certaine position dans le top des SERP, zone dans laquelle un site dispose encore d'une certaine tolérance quant à ses actions. Mais dès qu'il entre dans la cour des grands, le contrôle se fait plus strict et le risque de sanction augmente de manière exponentielle.

C'est souvent là que les stratégies agressives ou maladroites trouvent leurs limites, ne parvenant pas à stabiliser la position d'un site sur la durée. S'il est normal qu'un site client fasse le yo-yo sur ses courbes, il ne confirmera définitivement son autorité qu'avec un profil cohérent aux yeux de Google. Et si les bases du site sont solides, la stratégie de backlinks naturelle déploiera à ce moment-là toute sa puissance.

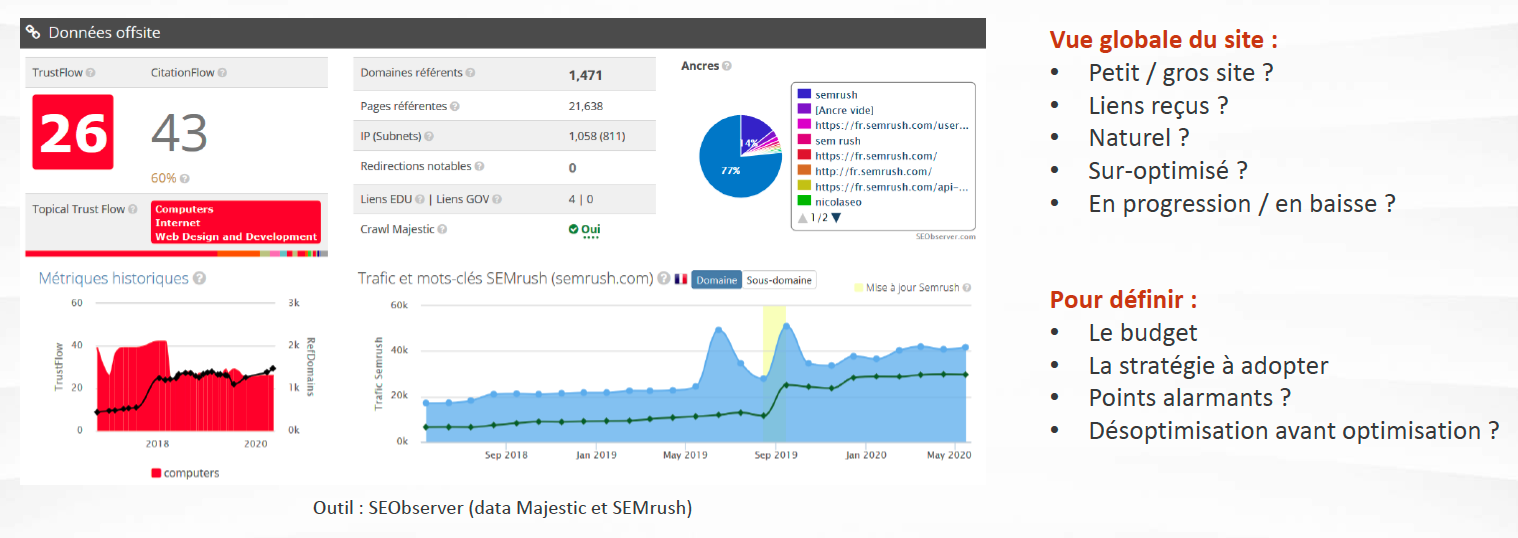

Bien analyser le site web

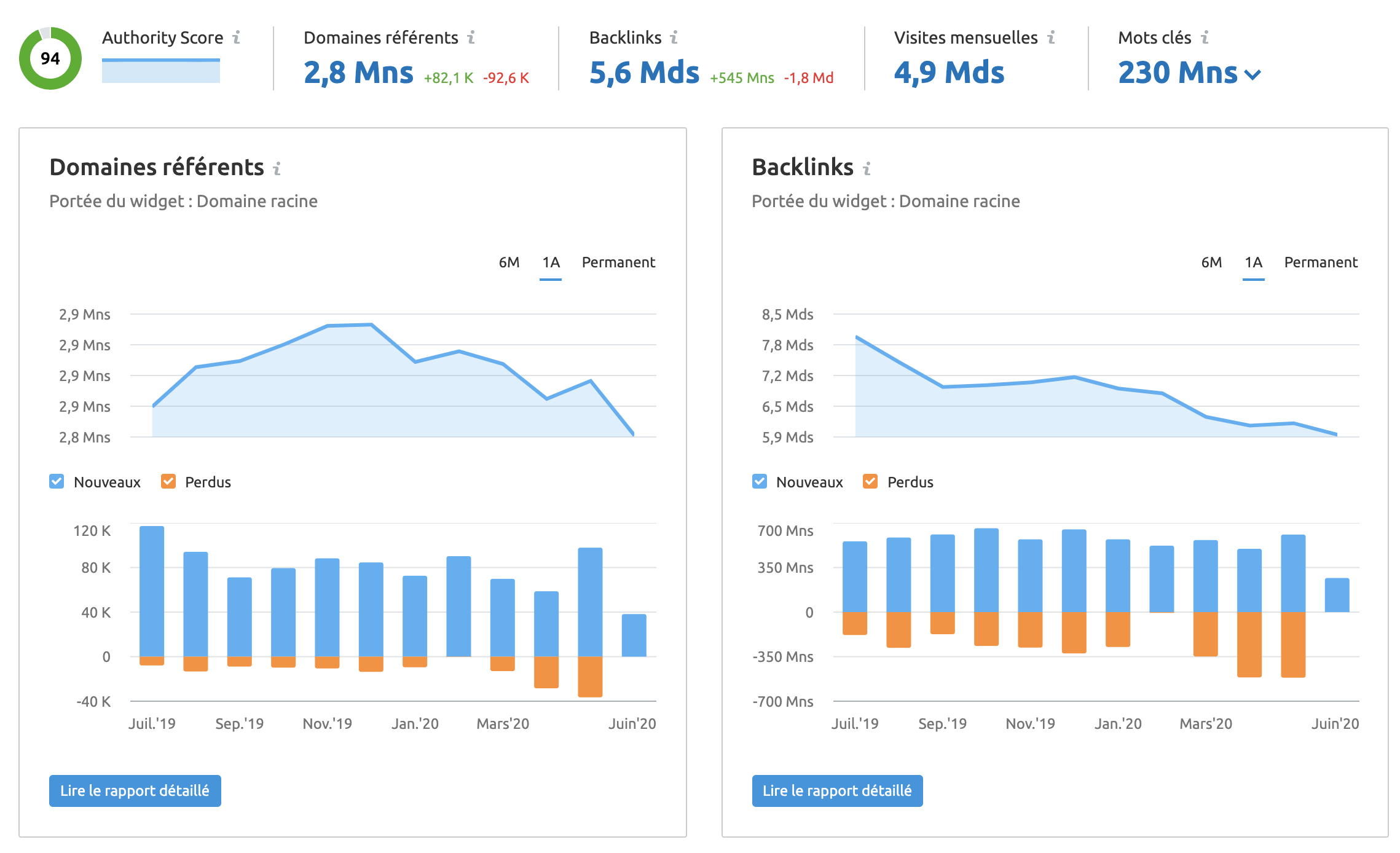

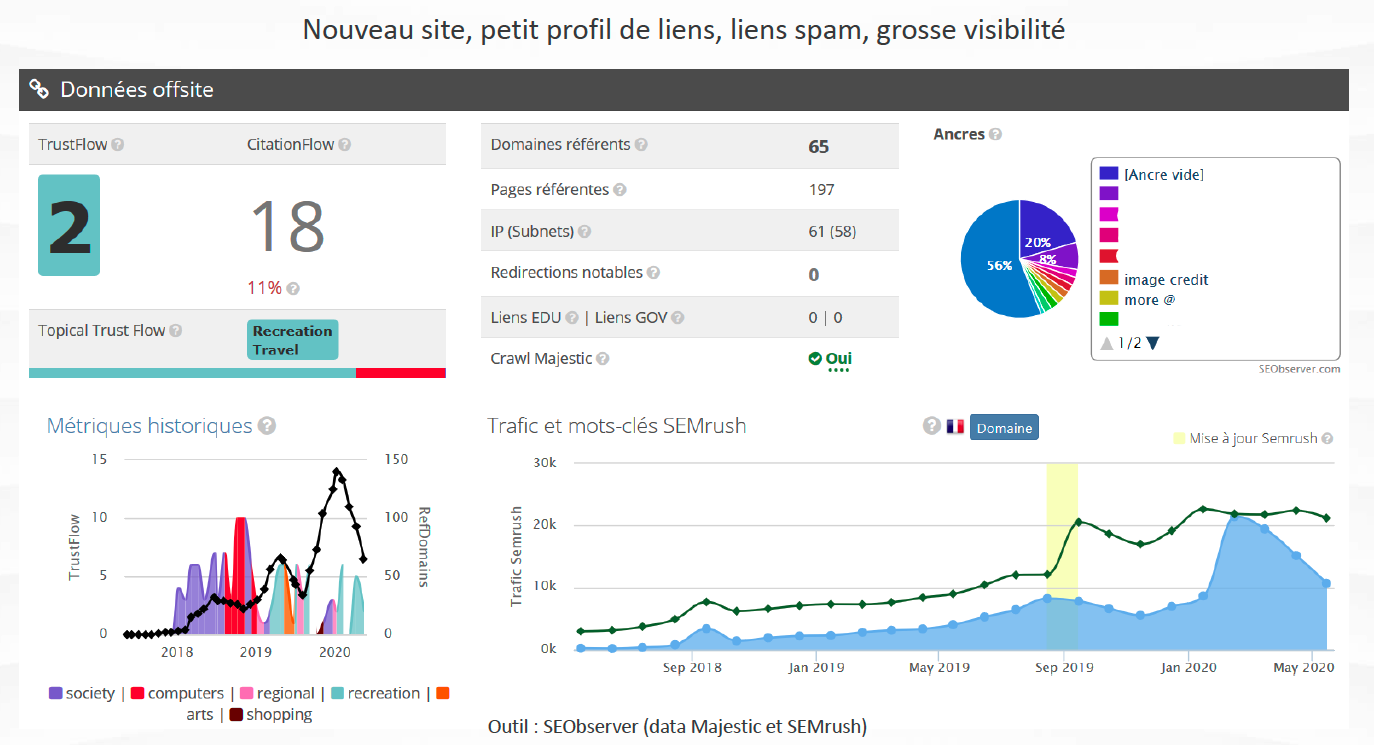

On analysera le trafic organique, les liens retours, ainsi que les metrics TrustFlow (TF) et CitationFlow (CF) d'un site. Mais attention, ne voir que le TF n'est pas forcément une bonne chose, car et indicateur peut facilement se manipuler. SEMrush permettra ici d'analyser le score de qualité globale ainsi que l'influence d'un domaine (authority score), le type de backlinks reçus, les domaines référents et leur ancienneté, les types d'ancres, etc., de façon à déterminer les points à travailler.

Des pics dans les courbes ne sont pas forcément une garantie de succès, car ils peuvent provenir de vagues de spam. Le problème ici ne sera pas le pourcentage de trafic qui va se maintenir suite au spam, mais bien la répétition du schéma qui va rendre évidente la tentative de manipulation.

Par exemple, un site qui a reçu trop de spam, ou un autre qui a besoin d'être désoptimisé avant d'être réoptimisé plus proprement et plus durablement, demanderont des stratégies différentes.

Soigner les contenus

Les principes de l'optimisation de contenu on-site s'appliquent également aux sites partenaires ainsi qu'aux contenus qui vont recevoir le lien d'un client. Le signal sera de bien meilleure qualité s'il provient d'un site de qualité, proposant des contenus de qualité.

Pour rester le plus naturels possible, les contenus devront être informatifs, utiles au lecteur, comporter un champ sémantique connexe à celui de la page cible, être bien rédigés et hiérarchisés, mais ils devront également être variés. De nombreux clients ont encore du mal à faire nettement la distinction entre netlinking et autopromotion, or un article de netlinking ne demande pas d'être systématiquement valorisant envers le client pour bien faire son travail. Même des articles de type « négatif » ont leur utilité au niveau de la transmission de jus SEO.

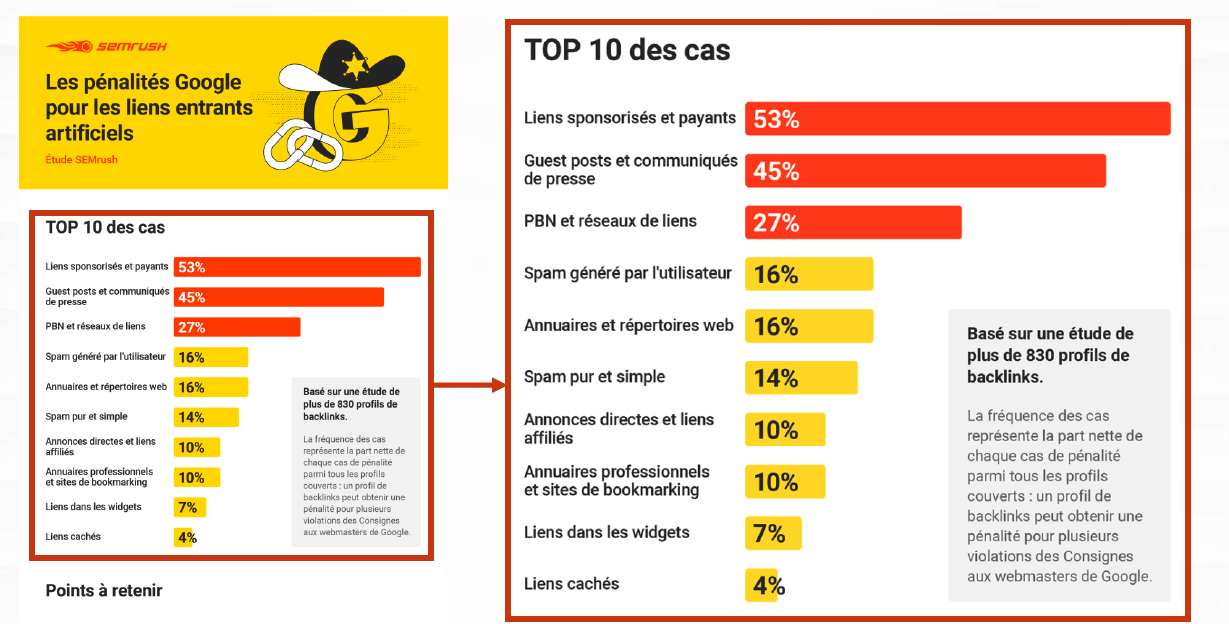

Si quelques articles de type promotionnel ou sponsorisé sont également bons pour la diversité, il ne faut cependant pas concentrer sa stratégie dessus : les diluer au sein d'un profil beaucoup plus varié sera plus efficace et naturel. Par contre, attention aux guest posts, qui déclencheront directement l'alarme chez Google !

Varier le type d'ancres

Même problématique que pour les contenus : il s'agira de noyer le poisson en diversifiant au maximum le profil de liens. SEMrush par exemple montre la fréquence des différents attributs de liens (balise REL : dofollow, nofollow, mais aussi sponsored et UGC), les domaines référents, etc., ce qui permet d'identifier les vagues de spam.

Par exemple, la tactique d'user et abuser des ancres suroptimisées peut sembler bien fonctionner, en tout cas au début. Mais lorsque le site commence à bien fonctionner, c'est une autre histoire ! Pas du tout naturelles, ces ancres sont dans la ligne de mire des robots de Google. La stratégie doit comporter un profil d'ancres les plus variées possible et surtout limiter très fortement les ancres suroptimisées ou les diluer dans la variété du profil.

Prudence dans le choix des sites partenaires

Est-il cohérent pour un tout jeune site de recevoir brutalement une vague de liens publiés par de très gros médias ? Pire encore, de répéter cette vague de manière régulière ? La légitimité à recevoir des liens provenant de sites très connus est un concept qui peut parfois poser problème dans le domaine du netlinking et qui est pourtant capital pour une stratégie cohérente. Un jeune domaine doit d'abord travailler sa croissance organique et SEO, afin de faire évoluer son profil de manière progressive et logique. C'est cela qui le rendra apte aux yeux de Google à recevoir des liens de sites à très forte autorité.

Dans le même ordre d'idées, confier la publication de tous ses liens à des réseaux appartenant à un unique propriétaire est une stratégie risquée. Si le réseau tombe, il risque d’impacter négativement les metrics du site ainsi poussé et de le faire chuter brutalement. Il est crucial de ne pas mettre tous ses œufs dans le même panier et de diversifier au maximum les partenaires.

La qualité du site qui va publier le lien reste un critère sur lequel on ne peut pas transiger : les liens toxiques sont tout aussi mauvais pour les metrics.

Comment fonctionnent les pénalités Google ?

Le contrôle manuel des sites web référencés ne se déclenche que lorsqu'une activité douteuse est relevée par les crawlers. La stratégie de netlinking reste « sous le radar » : tout l'art de la manipulation subtile est de ne pas déclencher ces signaux d'alerte, par exemple en vérifiant la qualité des liens reçus. Des liens de qualité douteuse ont toutes les chances d'attirer l'attention de manière négative sur le site client, comme le montre cette récente étude SEMrush. Les montées trop rapides sont souvent suivies de chutes douloureuses.

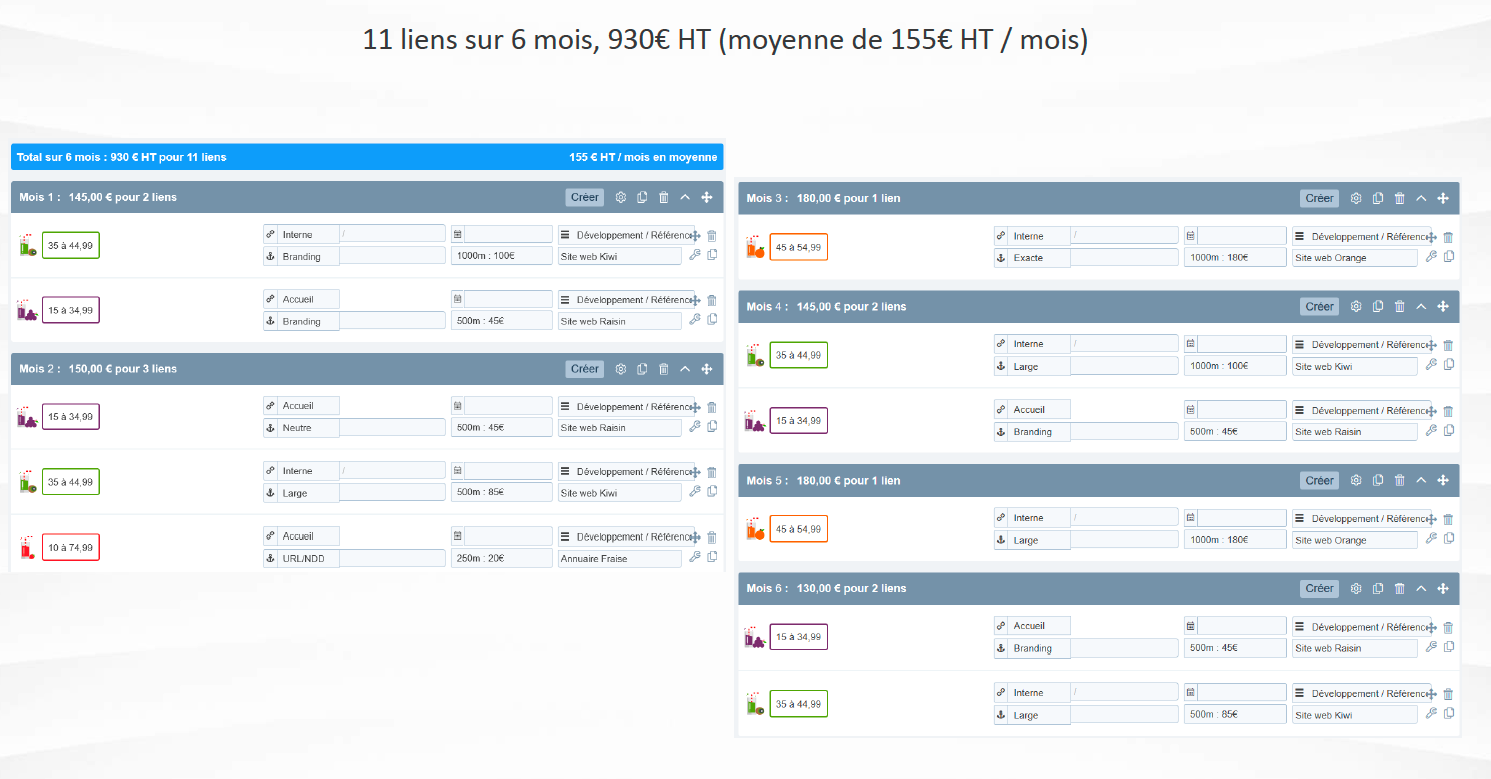

La clé d'une stratégie de netlinking de qualité, comme le propose la plateforme SEMJuice par exemple, c'est la variété des types de backlinks : varier les sources, la qualité, la puissance, etc., pour associer un profil de lien cohérent avec le site client.

En résumé, si vous voulez tendre à Google le bâton pour vous faire battre, il vous suffit d'employer un schéma identifiable dans vos publications, tant au niveau du type de lien reçu que de la forme de l'ancre, du type de contenu, de l'autorité du site partenaire…

Peut-être plus lentement qu'une stratégie « rapide », mais plus sûrement, le netlinking propre est un travail d'endurance !