Il y a quelques mois, nous avons accuilli Patrick Valibus, fondateur de la société 410 Gone, pour un webinaire consacré à l’amélioration du budget de crawl.

Si vous n'avez pas pu y assister, voici les points clés de cette conférence pratique et enrichissante.

Cloaking White Hat

Patrick démarre avec la punchline : "Cloaking is not a crime". Sa réflexion va se poursuivre sur deux axes : comment mieux utiliser le crawl budget et comment l’augmenter.

Mais d’abord, il nous rappelle quelques définitions :

-

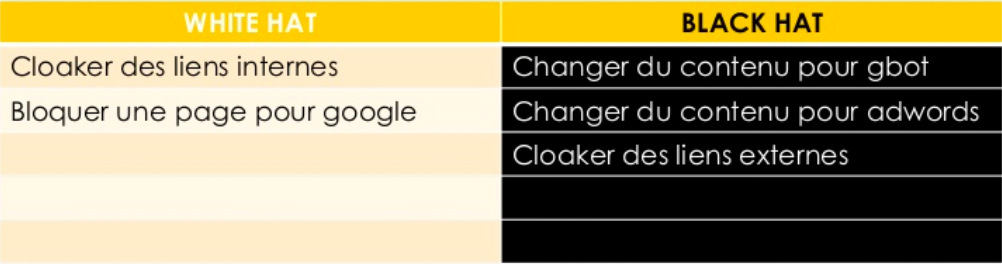

La différence entre White Hatet Black Hat : ce sont des pratiques SEO, les white ne présentent pas de danger particulier tandis que les black risquent d’engendrer une pénalité Google.

-

Le cloaking : une technique qui consiste à montrer un contenu différent à deux entités différentes. Par exemple, une version à Google et une autre à l’utilisateur. Il peut servir aussi à empêcher les bots de venir crawler votre site en boucle (des bots de spam, par exemple) et donc d’économiser de la ressource serveur.

-

Page Rank : un indice de notoriété d’une page par rapport à un ensemble (Page Rank interne à un site, Page Rank global). Bien sûr, il n’est plus communiqué par Google, néanmoins il reste un indice très utilisé.

-

Crawl budget : le temps que Google passe sur votre site par jour. Plus cette durée est grande, mieux c’est, car il a plus de chance de tomber sur des contenus à présenter aux internautes.

Avant de se concentrer sur le cloaking White Hat, Patrick énumère quelques pratiques hautement pénalisables de Black Hat :

-

modifier du contenu pour gbot,

-

modifier du contenu pour AdWords,

-

cloaker des liens externes.

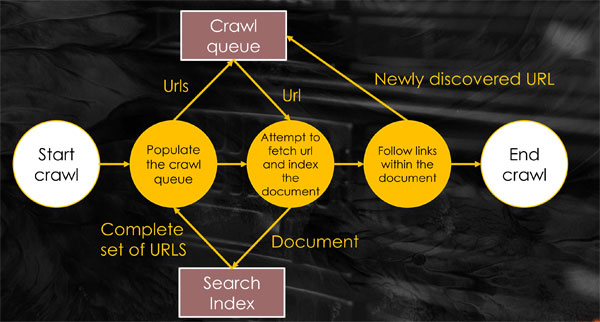

Pour comprendre le cloaking, il est important de savoir comment fonctionne Google bot. Que vient-il faire sur votre site ?

En réalité, il est comme nous, il a une to-do-list, et une fois sur votre site, il parcourt tout un tas d’URL. Pour chacune d’entre elles, il prend la version texte brut, il repère un certain nombre de patterns dans le code source et rajoute des URL à visiter pour la prochaine fois dans sa crawl queue. Il s’agit alors de faire en sorte que le bot ne soit pas orienté vers des éléments inutiles.

Contrairement à Black Hat, le cloaking White Hat ne comporte aucun risque de pénalité de Google.

Un des intérêts du White Hat est de réconcilier les UX designers et les spécialistes SEO. Le cloaking de liens permet de régler les conflits entre ces deux professions.

En gros, la question de savoir si l’on fait un lien parce que c’est bon pour le SEO ou le UX ne se pose plus, car avec le cloaking de liens, on fait les liens que l’on veut pour Google et les liens qu’on veut pour les utilisateurs.

Comment mieux utiliser votre crawl budget ?

Patrick conseille de commencer par l’analyse de logs, puis de supprimer les URL non pertinents pour le SEO.

Évidemment, il vaut mieux que Google aille voir vos pages HTML plutôt que des fichiers JavaScript ou CSS.

Patrick recommande de bien cloacker (ou rediriger) les fichiers JS ou CSS qui sont générés automatiquement. C’est le cas avec Magento ou WordPress par exemple, qui compressent du JS ou du CSS pour faire du fichier mis en cache ou du fichier versionné. Vous aurez alors tous les jours une nouvelle version du fichier JS et Google va continuer à aller dessus, ce qui peut prendre la moitié du crawl budget. Ces éléments sont donc à bloquer.

Comment augmenter votre crawl budget ?

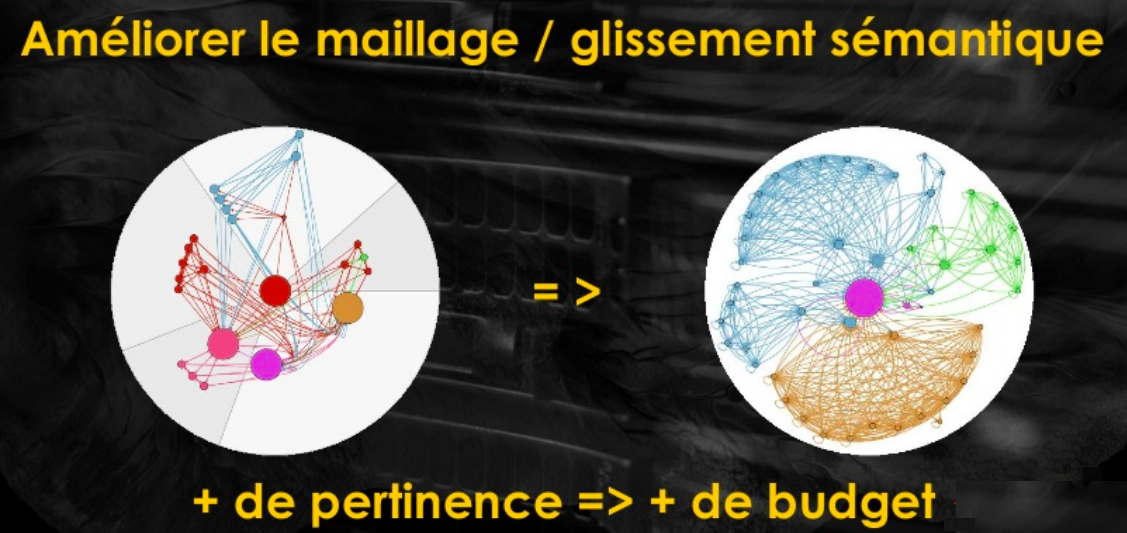

Pour répondre à cette question, Patrick commence par nous parler de glissement sémantique.

Sur les graphiques ci-dessous, chaque rond est une page HTML du site. Plus le rond est gros, plus il emmagasine de Page Rank interne. Chaque couleur correspond à un cluster sémantique (grande famille de champ lexical).

On peut voir que le cercle de droite est beaucoup plus ordonné :

-

Les grappes de contenu sont regroupées ;

-

Les ronds sont de taille plus uniforme (le Page Rank est mieux réparti) ;

-

La home page a grossi ;

-

On n’a plus de ronds inutiles (page contact et CGV, par exemple).

L’idée sur laquelle insiste Patrick, c’est que chaque page qui parle d’un sujet fasse des liens vers des pages proches d’un point de vue thématique.

Cela permet d’augmenter votre crawl budget, car si Google voit que vous avez des liens pertinents, qui pointent vers d’autres pages qui enrichissent l’information, il va juger votre site cohérent et viendra plus le crawler que des sites moins bien organisés.

Patrick est d’accord avec Olivier Andrieu quand il affirme que le contenu est roi, le lien est sa reine, et

le contenu sémantique est empereur !

Vous pouvez utiliser des outils, comme SEMrush Keyword Magic, pour trouver les bons champs lexicaux. Mais n’oubliez pas ensuite de rester dans cette logique sémantique lorsque vous vous occupez des liens.

L’aspect technique

Patrick se concentre ensuite sur l'aspect technique du cloaking White Hat et explique comment réaliser le cloaking backend avec PHP et frontend avec Javascript.

Le cloaking backend avec PHP

Patrick conseille l'outil gratuit In cloaking Veritas. Ce framework a été validé par Julien Gadanho lors du Google Black Day. Vous pouvez donc être tout à fait tranquille pour les pénalités.

Le volet technique comporte trois étapes :

-

Détection de l’user agent ;

-

Détection de l’adresse ip ;

-

Reverse dns de l’adresse ip.

L’idée est de ne pas diffuser une information différente à l’utilisateur et à Google.

Patrick nous explique ensuite ce qu’on peut cloaker avec ce framework, et il prend l’exemple de l’en tête HTTP avec envoi de 410.

Pour le cloaking de liens, il est important d'identifier la version cloakée et celle non cloakée : c’est à cette seule condition qu’on peut être tranquille pour tout ce qui touche aux pénalités.

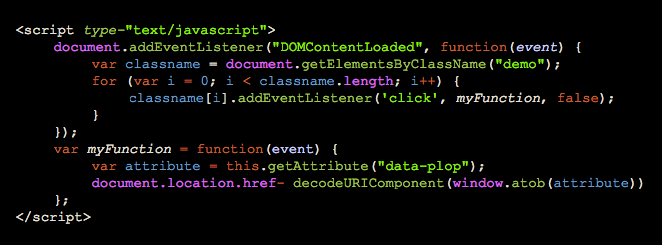

Le cloaking frontend avec Javascript

Si l’on préfère le JavaScript, on peut faire de l’obfuscation : le même code est donné à Google et à l’utilisateur, mais une action en JavaScript est mise sur le lien.

Patrick nous donne le code à utiliser (à placer en tête JS) :

<script type-"text/javascript">

document.addEventListener("DOMContentLoaded", function(event) {

var classname = document.getElementsByClassName("demo");

for (var i = 0; i < classname.length; i++) {

classname[i].addEventListener('click', myFunction, false);

}

});

var myFunction = function(event) {

var attribute = this.getAttribute("data-plop");

document.location.href- decodeURIComponent(window.atob(attribute))

};

</script>

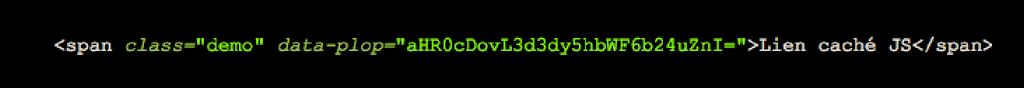

Et pour chacun des liens :

<span class="demo" data-plop="aHR0cDovL3d3dy5hbWF6b24uZnI=">Lien caché JS</span>

Ce script est utilisé, par exemple, par tous les gens qui font de la filiation sur Amazon.

Patrick affirme que si vous avez l’esprit un peu technique, vous pouvez le mettre en place vous-même (à l’aide de quelques outils).

Sinon, vous pouvez confier cette tâche à un spécialiste qui vous accompagnera à toutes les étapes :

-

Crawl sémantique ;

-

Analyse de logs ;

-

Mise en place du cloaking (selon le CMS).

Patrick insiste tout particulièrement sur l' analyse de logs et nous invite à nous y intéresser de près.

Nous remercions Patrick pour ce webinaire passionnant !