Dites-moi, quelle est la première chose qui vous vient à l’esprit lorsqu’il s’agit de positionner un site web ?

Le contenu ? Ou peut-être les backlinks ?

Je dois admettre que ce sont là deux facteurs essentiels pour positionner un site sur les résultats des moteurs de recherche. Mais ce ne sont pas les seuls.

En effet, deux autres facteurs jouent un rôle important dans une stratégie SEO : la crawlabilité et l’indexabilité. Et pourtant, la majorité des propriétaires de sites web n’en ont jamais entendu parler.

Même des problèmes mineurs liés à la crawlabilité et l’indexabilité peuvent entraîner un recul de positionnement de votre site, et ce, indépendamment de la qualité de votre contenu et du nombre de backlinks.

Que sont la crawlabilité et l’indexabilité ?

Pour comprendre ces termes, voyons tout d’abord comment les moteurs de recherche détectent et indexent des pages. Pour découvrir de nouvelles pages ou des pages mises à jour, ils utilisent ce que l’on appelle des robots d’indexation, ou robots d’exploration, c’est-à-dire des robots qui suivent des liens sur la toile avec pour unique objectif :

Trouver et indexer du nouveau contenu sur le web.

Voici comment l'explique Google :

« Ces robots d’exploration examinent les pages Web et suivent les liens qui y figurent, de la même façon que lorsque vous naviguez sur Internet. Ils vont de lien en lien et renvoient des informations relatives à ces pages Web aux serveurs de Google. »

Matt Cutts, ancien employé de Google, a mis en ligne une vidéo intéressante expliquant en détail ce processus. Vous pouvez la regarder ci-dessous :

Pour faire simple, ces deux termes se réfèrent à la capacité d’un moteur de recherche d’accéder à des pages web et de les indexer.

La crawlabilité est à la capacité d’un moteur de recherche d’accéder au contenu d’une page et de le crawler.

Si un site ne présente aucun problème de crawlabilité, les robots d’indexation peuvent facilement accéder à tout son contenu en suivant les liens entre les pages.

Cependant, les liens brisés ou morts peuvent mener à des problèmes de crawlabilité : le moteur de recherche est incapable d’accéder à un contenu spécifique sur un site.

L’indexabilité, quant à elle, se réfère à la capacité d’un moteur de recherche d’analyser et d’ajouter une page à son index.

Même si Google peut parcourir un site, il pourrait ne pas être capable d’indexer toutes ses pages, souvent en raison de problèmes d’indexabilité.

Qu’est-ce qui affecte la crawlabilité et l’indexabilité ?

1. La structure du site

La structure de l’information d’un site web joue un rôle crucial en matière de crawlabilité.

Par exemple, si votre site comporte des pages sans liens, les robots d’indexation pourraient avoir des difficultés à y accéder.

Bien entendu, ils pourraient tout de même trouver ces pages via des liens externes, pour peu que quelqu’un les ait référencés dans son contenu. Mais de manière générale, une structure faible peut causer des problèmes de crawlabilité.

2. La structure des liens internes

Un robot d’indexation navigue sur le web en suivant des liens présents sur chaque site. C’est pourquoi le robot ne peut trouver que des pages vers lesquels vous pointez à partir d’autres contenus.

Par conséquent, une bonne structure de liens internes permet au robot d’atteindre rapidement même les pages plus profondes dans la structure de votre site.

3. Les boucles de redirection

Une longue chaîne de redirects ou des boucles de redirection bloquent les robots d’indexation, ce qui entraîne des problèmes de crawlabilité.

4. Les erreurs de serveur

De la même manière, des redirections de serveur en panne et d’autres problèmes liés au serveur peuvent empêcher les robots d’indexation d’accéder à l’ensemble de votre contenu.

5. Les scripts non pris en charge et d’autres facteurs

Des problèmes de crawlabilité peuvent également survenir en raison de la technologie que vous utilisez sur votre site. C’est le cas, par exemple, si vous protégez du contenu derrière un formulaire, étant donné que les robots d’indexation ne peuvent pas suivre les formulaires.

Différents scripts, tels que JavaScript ou Ajax peuvent aussi empêcher les robots d’accéder à du contenu.

6. L’accès bloqué aux robots d’indexation

Enfin, vous pourriez délibérément empêcher les robots d’indexation d’indexer des pages sur votre site.

Et il y a de bonnes raisons de le faire.

Par exemple, vous pourriez avoir créé une page dont vous voulez restreindre l’accès public. Pour ce faire, vous devez également empêcher les robots d’indexation d’y accéder.

Cependant, il également est facile de bloquer accidentellement l’accès à d’autres pages. Une simple erreur de code, par exemple, pourrait bloquer une partie tout entière du site.

Comment rendre votre site web plus facile à crawler et à indexer ?

Nous venons de voir quelques-uns des facteurs qui peuvent affecter la crawlabilité et l’indexabilité de votre site. La première étape, donc, consiste à vous assurer qu’aucun d’eux n’entre en ligne de compte.

Mais il existe d’autres choses que vous pouvez faire afin de permettre aux robots d’indexation d’accéder à vos pages et de les indexer plus facilement.

1. Soumettez sitemap à Google

Sitemap est un petit fichier qui se trouve dans le dossier racine de votre domaine et qui contient des liens directs vers chacune des pages de votre site et les soumet au moteur de recherche en utilisant la Search Console.

Le sitemap informera Google de votre contenu et l’alertera de toutes les mises à jour que vous avez faites.

2. Renforcez votre maillage interne

Bien organiser votre linking interne aura certainement un impact positif sur la crawlabilité. Afin d’augmenter les chances que le robot d’indexation de Google trouve tout le contenu de votre site, améliorez votre maillage interne de sorte que tout votre contenu soit relié.

3. Faites des mises à jour régulières et ajoutez du nouveau contenu

Le contenu est la partie la plus importante de votre site. Il vous permet d’attirer des visiteurs, de leur présenter votre entreprise et de les transformer en clients fidèles.

Mais le contenu vous aide également à améliorer la crawlabilité de votre site. En effet, les robots d’indexation visitent plus fréquemment les sites qui mettent constamment à jour leur contenu. Et cela veut dire qu’ils parcourront et indexeront plus rapidement votre page.

4. Évitez le contenu dupliqué

Le contenu dupliqué, c’est-à-dire des pages qui présentent le même contenu ou un contenu sensiblement similaire, peut entraîner un recul de positionnement de votre site.

De plus, le contenu dupliqué peut diminuer la fréquence à laquelle les robots d’indexation visitent votre site.

Veillez donc à analyser votre contenu et à remédier à d’éventuels problèmes de contenu dupliqué sur votre site.

5. Accélérez le temps de chargement de votre page

Les robots d’indexation disposent généralement d’un laps de temps limité pour parcourir et indexer votre site.

Donc, plus vos pages chargent vite, plus le robot pourra en visiter avant que son temps imparti ne se soit écoulé.

Outils de gestion de crawlabilité et d’indexabilité

Si tous les points que nous avons abordés vous semblent difficiles à mettre en place, ne vous inquiétez pas : il existe des outils qui vous aident à déceler et à résoudre vos problèmes de crawlabilité et d’indexabilité.

Log File Analyzer

Log File Analyzer est un outil qui vous indique comment les robots desktop et mobile de Google parcourent votre site, s’il y a certaines erreurs à corriger et s’il est possible d’économiser le budget de crawl c’est-à-dire le temps qu’alloue Google à l’exploration de votre site. Il vous suffit de charger le fichier access.log de votre site web et de laisser l’outil faire son travail.

Un journal des accès est une liste de toutes les requêtes que des robots ont envoyées à votre site. L’analyse de ce journal vous permet de suivre et de comprendre le comportement des robots d’indexation.

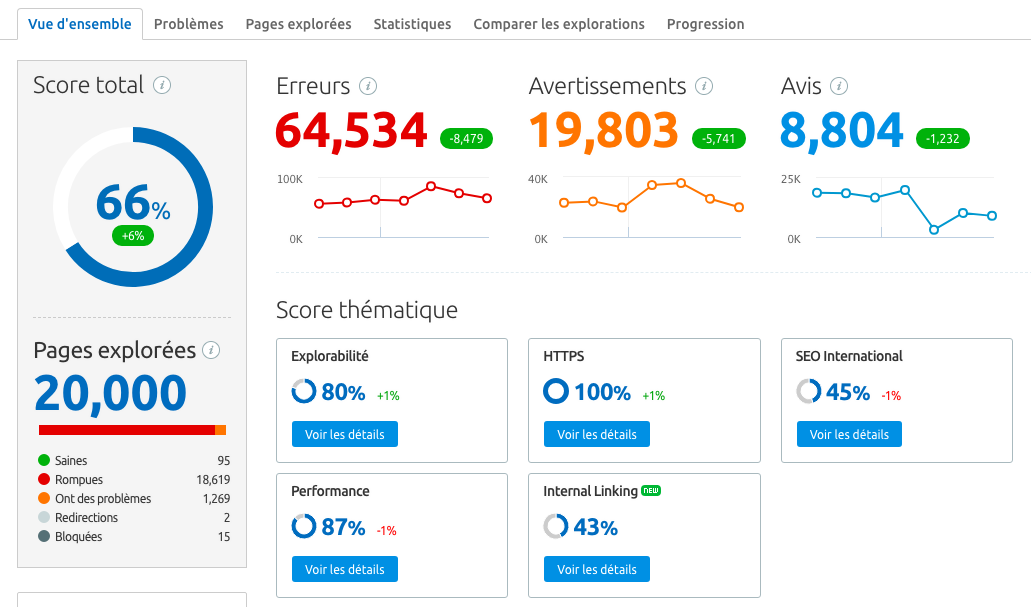

Audit de site

Audit de site fait partie de la suite SEMrush qui vérifie la santé de votre site web. Scannez votre site pour détecter différents types de problèmes, dont ceux qui affectent la crawlabilité et l’indexabilité.

Outils de Google

Google Search Console vous aide à contrôler votre site et garder un oeil sur sa performance dans les résultats de recherche. C’est là que vous pouvez soumettre votre sitemap et découvrir la couverture des robots d’indexation sur votre site.

Google PageSpeed Insights vous permet de vérifier le Pagespeed, la vitesse de chargement d’une page web.

Conclusion

La plupart des webmasters savent que pour améliorer le positionnement d’un site, ils ont au moins besoin de contenu fort et pertinent et de backlinks qui augmentent l’autorité du site.

Ce qu’ils ignorent, c’est que leurs efforts sont inutiles si les robots d’indexation des moteurs de recherche ne peuvent ni parcourir ni indexer leurs sites.

C’est pourquoi, en plus de veiller à ajouter et à optimiser des pages pour des mots-clés pertinents et à gagner des liens, il vous faut également constamment vérifier que les robots d’indexation accèdent bien à votre site et noter ce qu’ils trouvent au moteur de recherche.