Qu'est-ce que le budget Crawl ?

Le budget de crawl est la quantité de temps et de ressources que les robots des moteurs de recherche allouent au crawl de ton site Web et à l'indexation de ses pages.

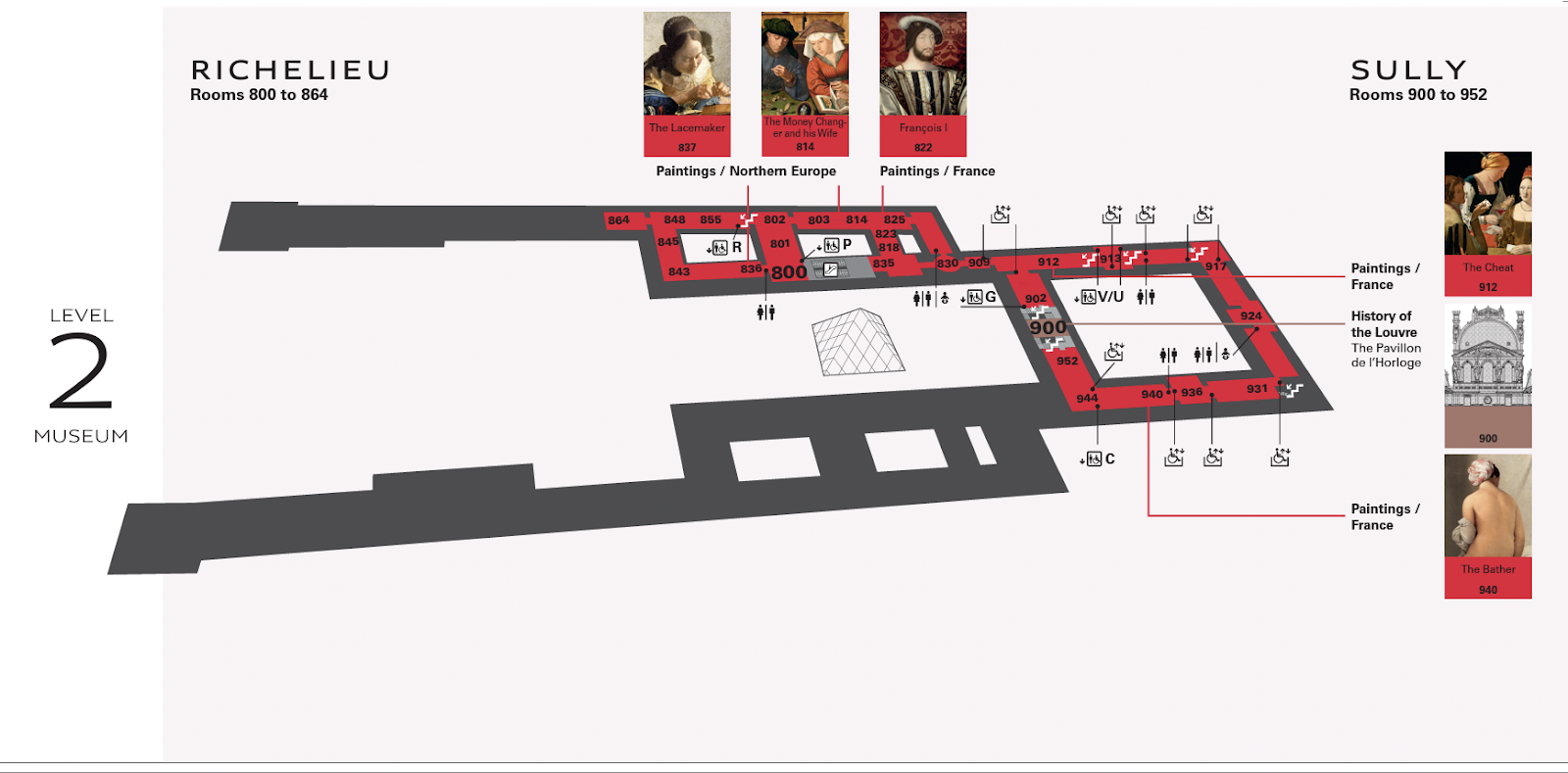

Pense à ceci : tu visites le Louvre, qui présente des centaines d'expositions sur plusieurs étages.

Sans carte, tu pourrais passer à côté de l'art que tu voulais vraiment voir.

Pour réaliser la carte que tu as entre les mains, quelqu'un devrait parcourir chaque pièce, en marquant les tableaux qui y sont répertoriés.

Dans cette métaphore, le cartographe du Louvre est comme un Googlebot qui explore un site web.

Une équipe de cartographes courant constamment autour du Louvre ralentirait l'expérience des spectateurs.

De la même façon que les robots qui explorent constamment ton site Web le ralentiraient.

Les cartographes ont donc besoin d'un temps déterminé pour mettre à jour la carte, tout comme le Googlebot a besoin de savoir à quelle fréquence il doit explorer ton site Internet.

Les budgets de crawl ont-ils une incidence sur le référencement ?

Le budget de crawl n'est pas un facteur de classement pour le référencement technique.

Mais si Googlebot rencontre des erreurs de crawl qui l'empêchent de lire et d'indexer ton contenu, les chances que tes pages apparaissent sur les pages de résultats des moteurs de recherche(SERP) sont minces.

Tu ne veux pas non plus que les robots de Google parcourent ton site en permanence.

Le dépassement du budget alloué à l'exploration d'un site Web peut entraîner des ralentissements ou des erreurs dans le système.

Cela peut conduire à ce que les pages soient indexées tardivement ou pas du tout, ce qui se traduit par des classements de recherche inférieurs.

Google utilise des centaines de signaux pour décider où il doit placer ta page. Le crawling détermine si ta page apparaît, et non où, et n'a rien à voir avec la qualité du contenu.

Comment Google détermine-t-il le budget de crawl ?

Chaque site Web dispose d'un budget de crawl unique contrôlé par deux éléments principaux : la demande de crawl et la limite de crawl.

Il est important de comprendre comment ils fonctionnent et ce qui se passe en coulisses.

Demande de crawl

La demande d'exploration fait référence à la volonté de Google d'explorer ton site Web.

Deux facteurs influencent cette demande : la popularité et l'obsolescence.

Popularité

Google donne la priorité aux pages qui ont plus de backlinks ou à celles qui attirent un trafic plus important. Ainsi, si des personnes visitent ton site Web ou y créent des liens, l'algorithme de Google reçoit des signaux indiquant que ton site Web mérite d'être exploré plus fréquemment.

Les liens retour aident surtout Google à déterminer quelles pages valent la peine d'être explorées. Si Google remarque que les gens parlent de ton site Web, il veut le parcourir davantage pour voir ce qu'il en est.

Note que le nombre de liens n'a pas d'importance - les liens doivent être pertinents et provenir de sources qui font autorité.

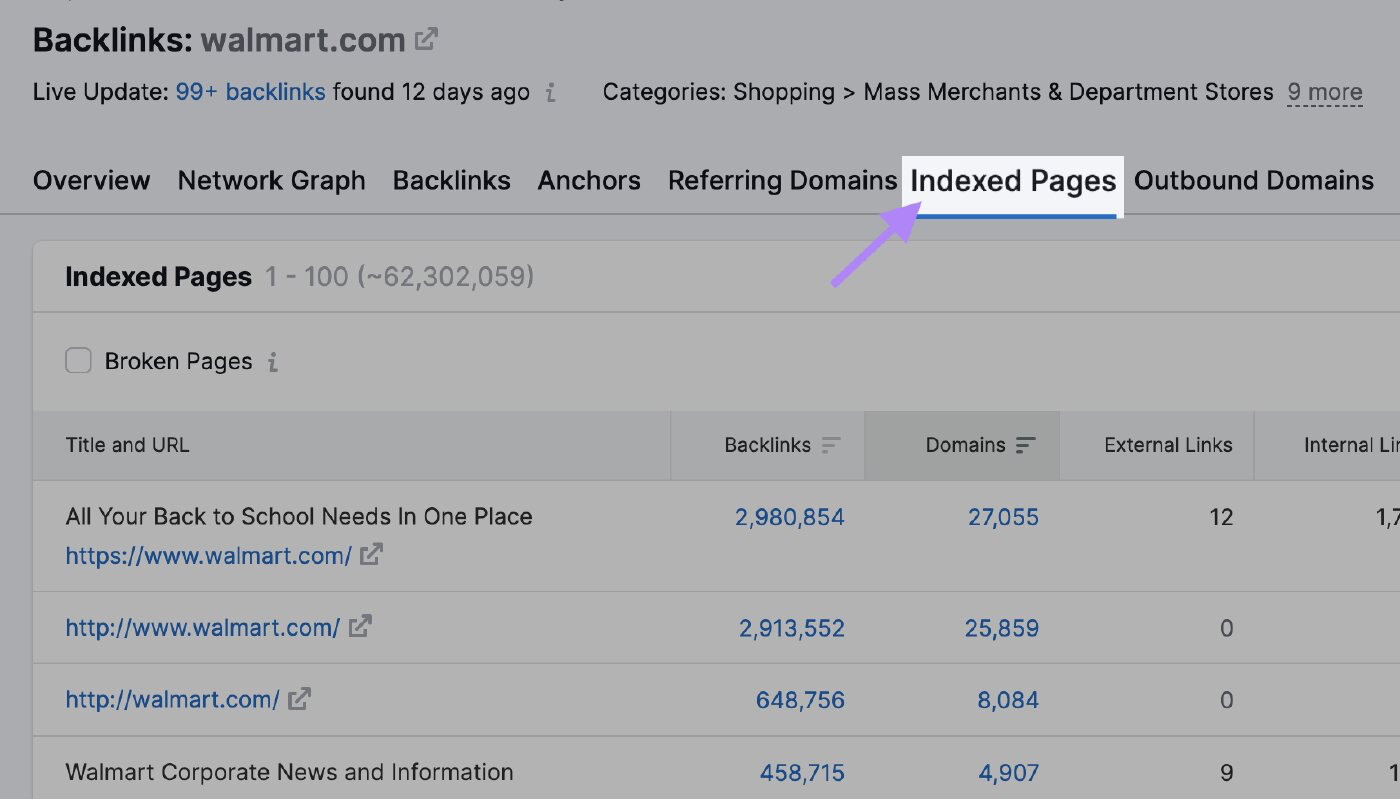

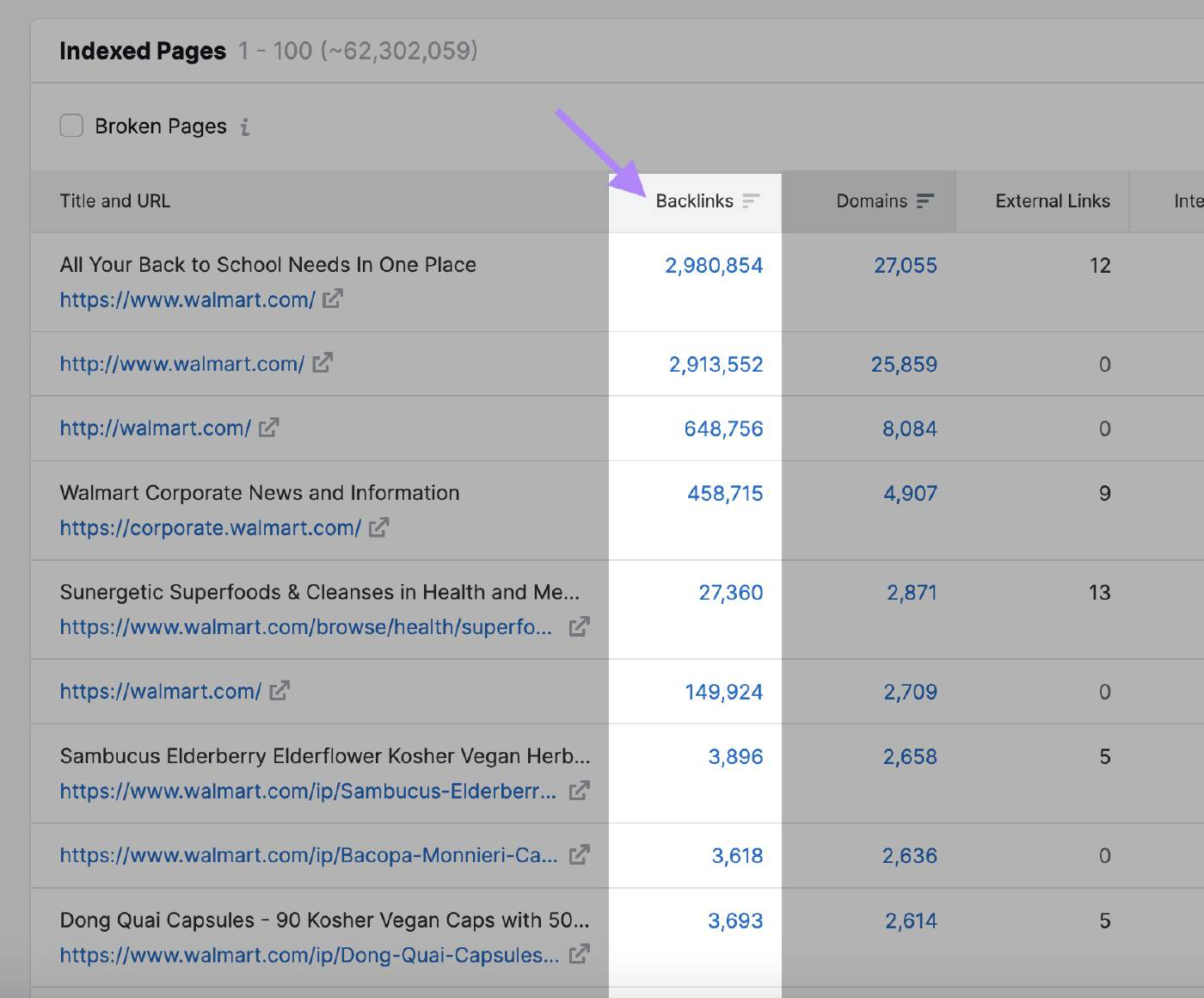

Tu peux utiliser l'outil Backlink Analytics de Semrush pour voir quelles pages attirent le plus de backlinks et peuvent attirer l'attention de Google. Entre le domaine et clique sur l'onglet "Pages indexées".

Ici, tu peux voir les pages qui ont le plus de liens retour :

Stabilité

Googlebot ne parcourra pas une page qui n'a pas été mise à jour depuis un certain temps.

Google n'a pas révélé la fréquence à laquelle le moteur de recherche parcourra à nouveau le site web. Cependant, si l'algorithme remarque une mise à jour générale du site, les bots augmentent temporairement le budget de crawl.

Par exemple, Googlebot explore fréquemment les sites d'actualités car ils publient de nouveaux contenus plusieurs fois par jour.

Dans ce cas, le site web a une forte demande de crawl.

Compare cela à un site Web sur l'histoire d'œuvres d'art célèbres qui n'est pas mis à jour aussi fréquemment.

Voici d'autres actions qui peuvent signaler à Google qu'il y a des changements à explorer :

- Changement de nom de domaine : Lorsque tu changes le nom de domaine de ton site Internet, l'algorithme de Google doit mettre à jour son index pour refléter la nouvelle URL. Il parcourra le site Web pour comprendre le changement et transmettra les signaux de classement au nouveau domaine.

- Modification de la structure de l'URL : Si tu modifies la structure URL de ton site en changeant la hiérarchie du répertoire ou en supprimant ou en ajoutant des sous-domaines, les robots de Google doivent recrawler les pages pour indexer correctement les nouvelles URL

- Mises à jour du contenu : Les mises à jour importantes du contenu de ton site Web, comme la réécriture d'une grande partie de tes pages, l'ajout de nouvelles pages ou la suppression de contenu obsolète, peuvent attirer l'attention de l'algorithme et l'inciter à recrawler ton site Web

- Soumission du sitemap XML : Mettre à jour ton sitemap XML et le soumettre à nouveau à Google Search Console permet d'informer Google qu'il y a des changements à explorer. C'est particulièrement utile lorsque tu veux t'assurer que Google indexe rapidement les pages nouvelles ou mises à jour.

Limite du taux d'exploration

La limite du taux de crawl détermine la vitesse à laquelle le robot peut accéder et télécharger les pages web de ton site pour préparer le contenu à être affiché dans les résultats de recherche.

C'est la façon dont Google s'assure que son exploration ne surcharge pas tes serveurs.

La limite d'exploration empêche le robot d'engorger ton site Web avec trop de requêtes, ce qui peut entraîner des problèmes de performance.

Si ton site répond rapidement, Google obtient le feu vert pour augmenter la limite et il peut alors utiliser plus de ressources pour l'explorer.

De même, si Google rencontre des erreurs de serveur ou si ton site ralentit, la limite tombera et Googlebot explorera moins le site web.

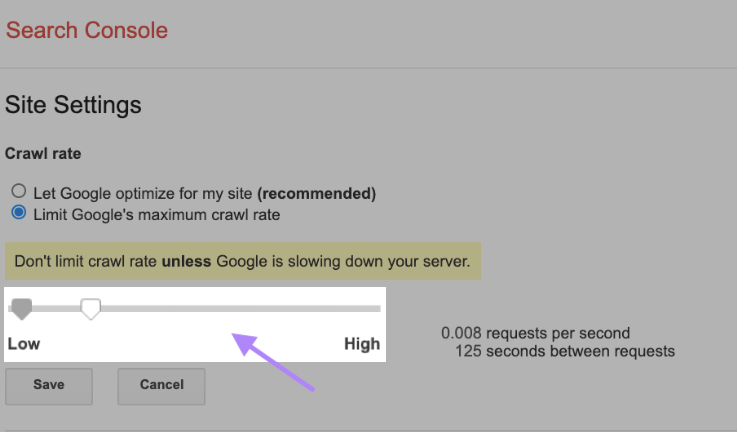

Tu peux aussi modifier manuellement la limite du crawl, bien qu'il soit important de le faire avec prudence. Google suggère de ne pas limiter le taux d'exploration à moins que ton serveur ne ralentisse.

Pour modifier ton taux de crawl, va dans les paramètres du site sur Search Console et ajuste la barre. L'ajustement prend généralement jusqu'à deux jours pour s'appliquer.

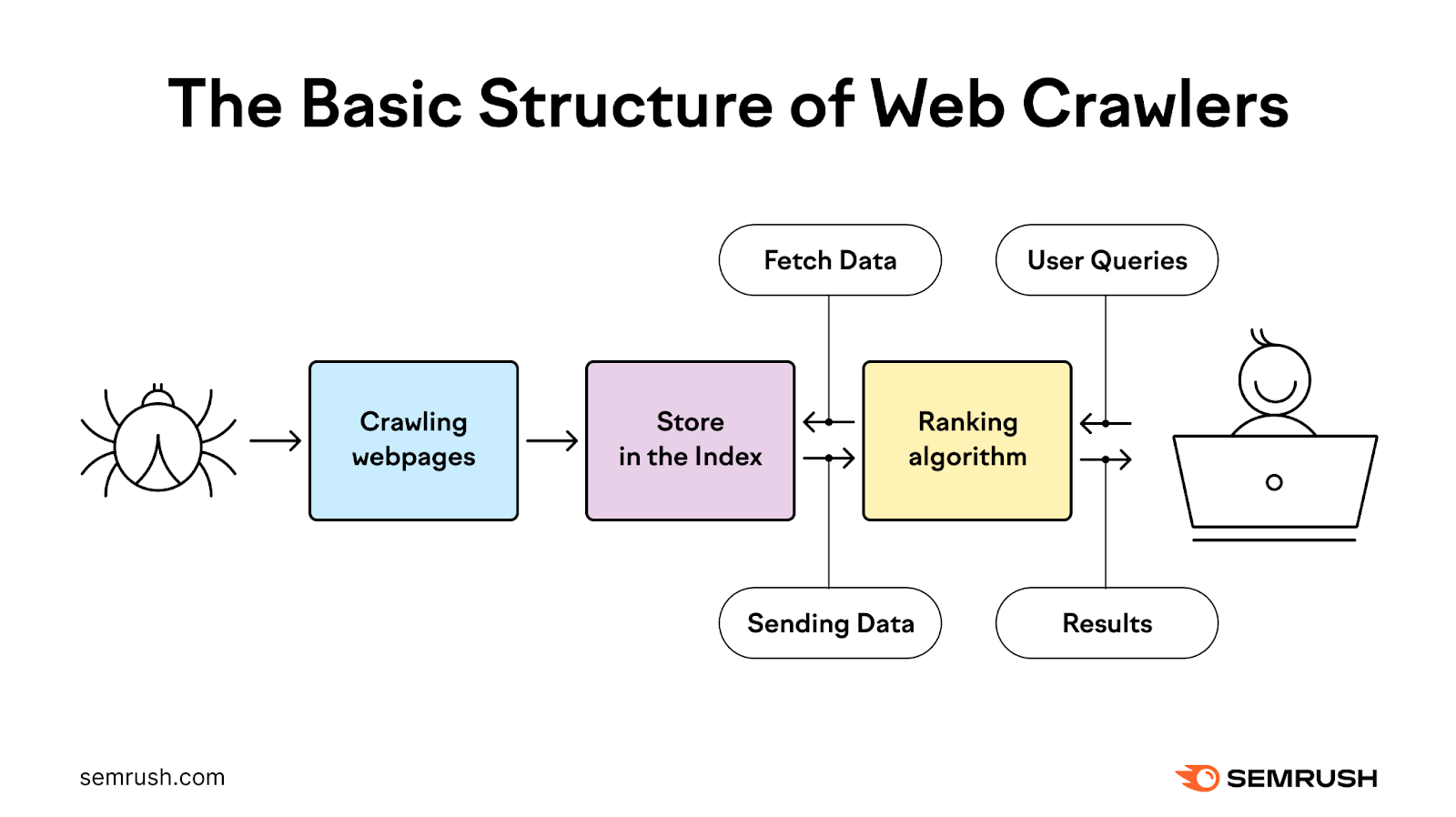

Comment fonctionne le processus d'exploration ?

Le processus d'exploration utilise des robots pour découvrir, explorer, analyser et indexer les pages Web afin de fournir aux utilisateurs les résultats de recherche les plus pertinents et de la plus haute qualité.

Il commence par une liste d'adresses Web provenant d'explorations antérieures et de sitemaps XML fournis par les propriétaires de sites. Ensuite, Google utilise des robots d'indexation pour visiter ces adresses, lire les informations et suivre les liens sur ces pages.

Les robots d'exploration revisitent les pages que Google a déjà dans la liste pour vérifier si elles ont changé et explorent également les nouvelles pages.

Au cours de ce processus, le robot donne la priorité au moment et à l'objet de l'exploration en fonction de la demande d'exploration, tout en s'assurant que le site Web peut gérer les demandes du serveur qu'il effectue.

Il traite ensuite les pages qu'il explore avec succès et les transmet à Google pour qu'elles soient indexées dans les résultats de recherche.

La plupart du temps, Google explore efficacement les petits sites web.

Lorsqu'il s'agit de grands sites Web comportant des millions d'URL, Google doit établir des priorités pour savoir quand et quoi explorer et combien de ressources il doit y consacrer.

Comment vérifier l'activité de ton crawl

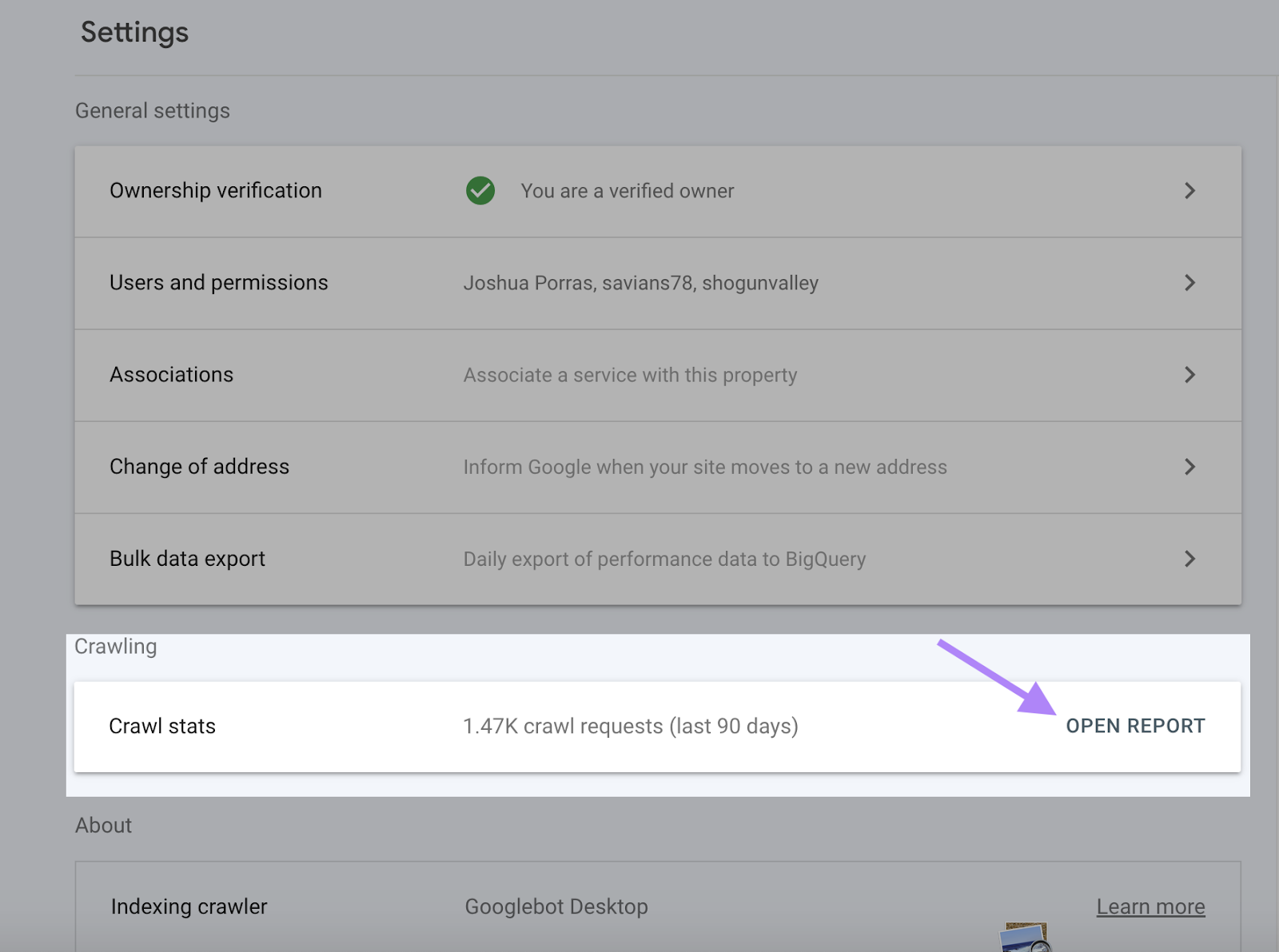

Google Search Console fournit des informations complètes sur ton activité de crawl, y compris les erreurs de crawl et le taux de crawl, dans le rapport Crawl Stats.

Ton rapport Crawl Stats te permet de vérifier si Google peut accéder à ton contenu et l'indexer. Il peut également identifier et corriger les problèmes avant que la visibilité de ton site web ne chute.

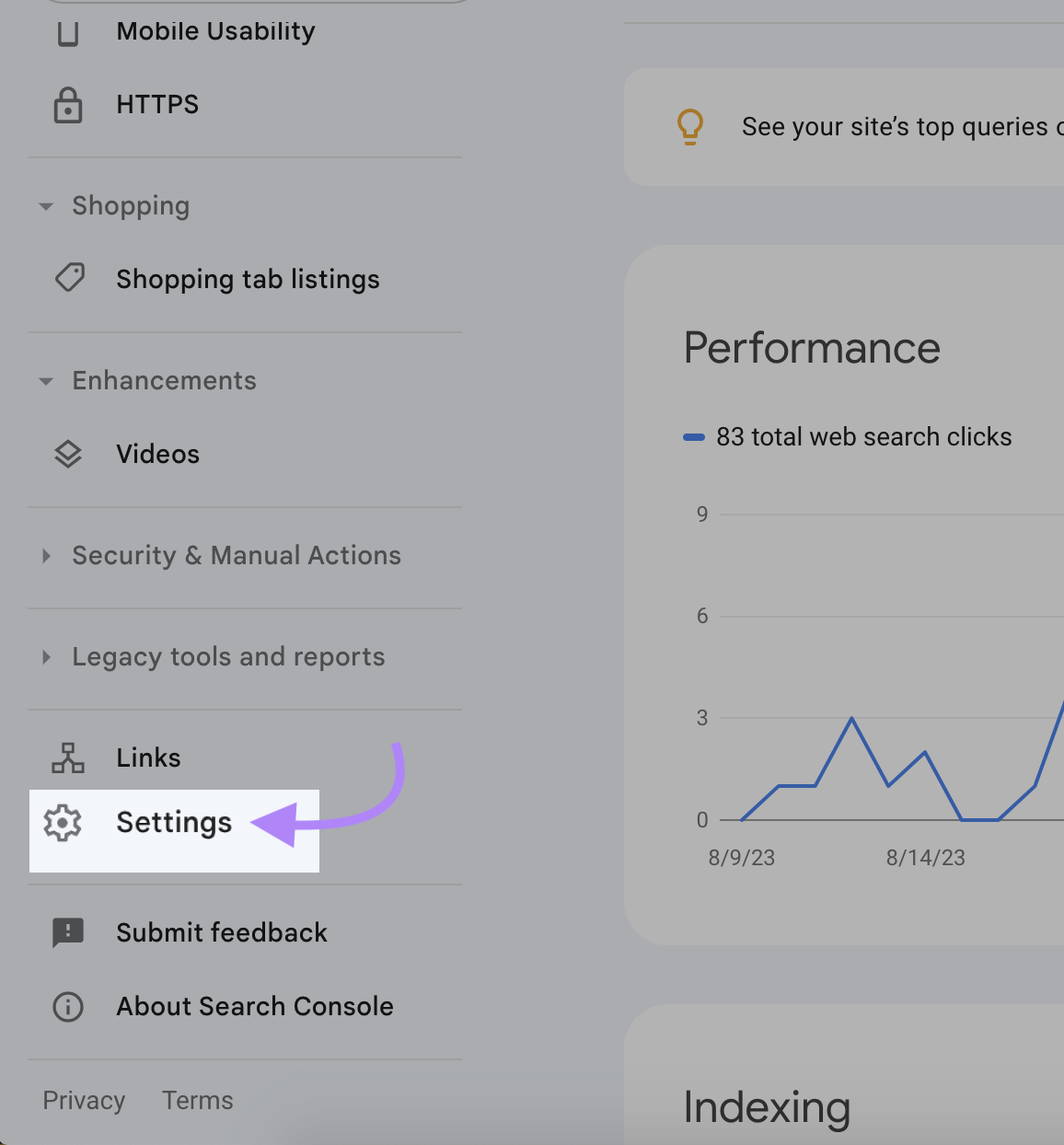

Pour accéder à ton rapport de statistiques de crawl, connecte-toi à Search Console et clique sur "Paramètres".

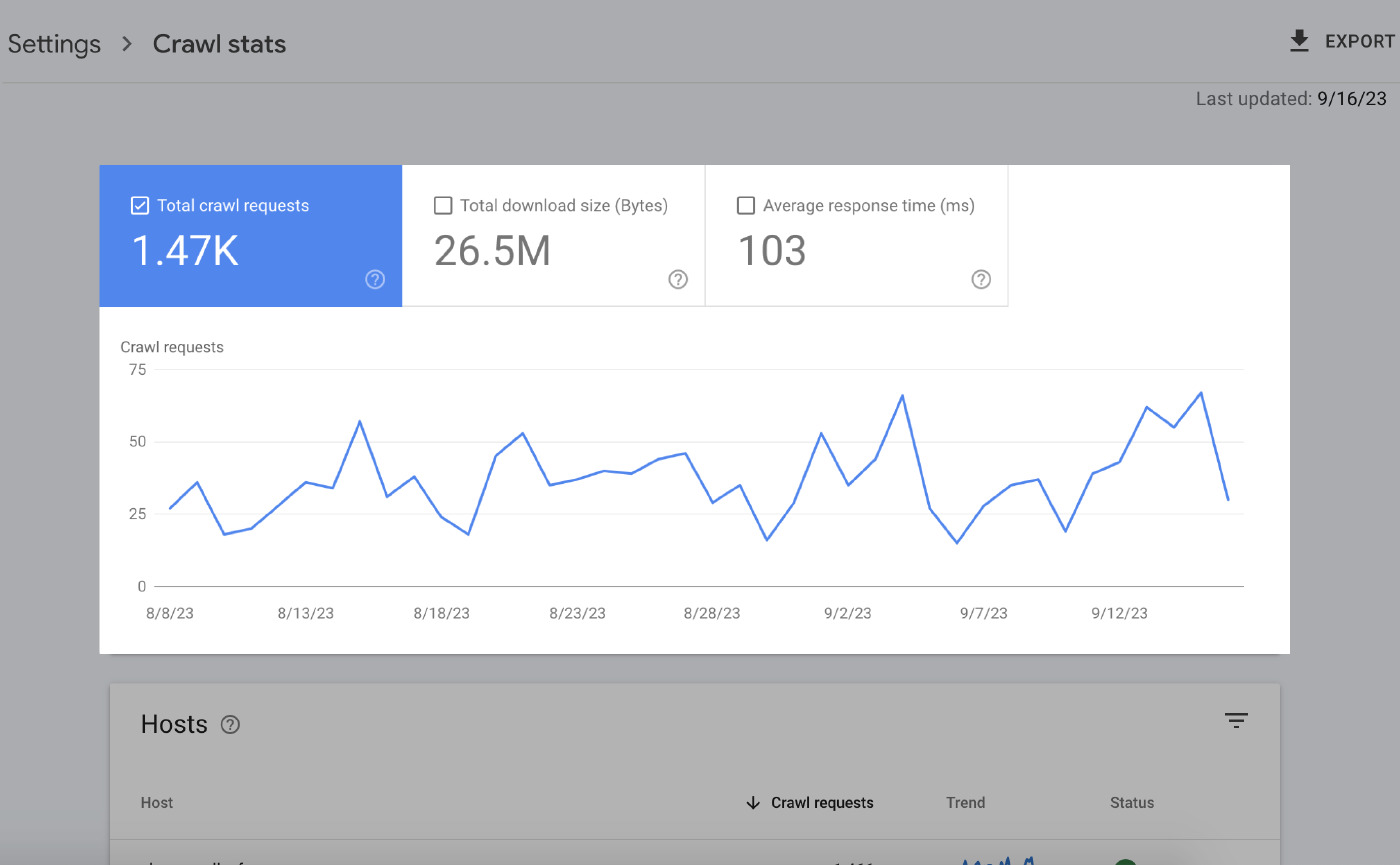

La page de résumé te donne beaucoup d'informations. Les principaux éléments sont :

Tableaux des heures supplémentaires

Les graphiques chronologiques mettent en évidence les données de ton crawl au cours des 90 derniers jours.

Voici ce que cela signifie :

- Total des demandes d'exploration : Nombre de demandes d'exploration effectuées par Google au cours des 90 derniers jours.

- Taille totale des téléchargements : La quantité totale de données que les robots d'exploration de Google ont téléchargées en accédant à ton site web sur une période donnée.

- Temps de réponse moyen : Le temps qu'il faut au serveur de ton site pour répondre à une demande du navigateur d'un utilisateur.

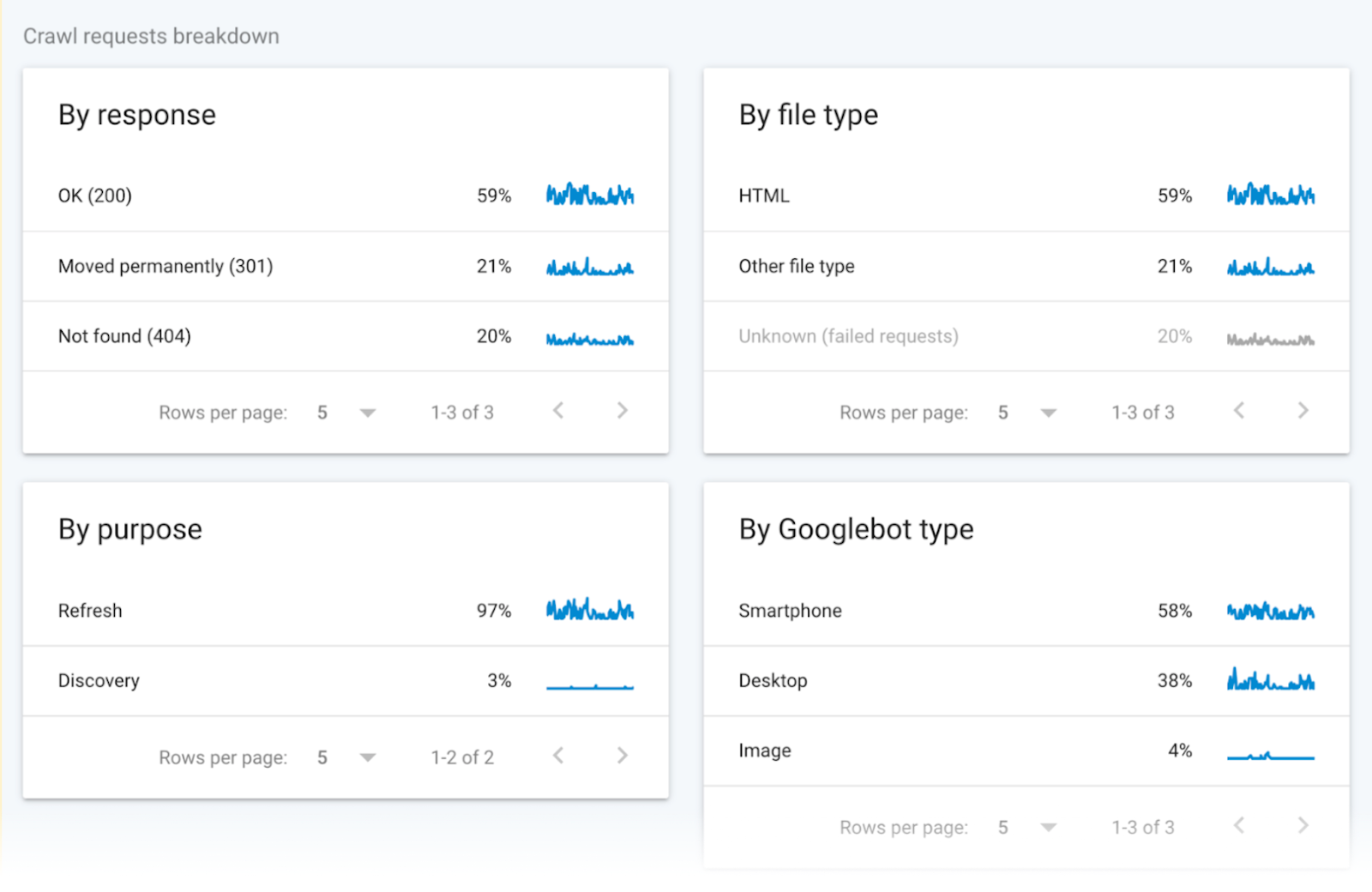

Données groupées

Les données de crawl groupées fournissent des informations sur les demandes de crawl.

Les données répartissent ces demandes en fonction du type de fichier URL, de la réponse, du type de Googlebot et de l'objet de la demande (découverte pour une nouvelle page ou rafraîchissement pour une page existante).

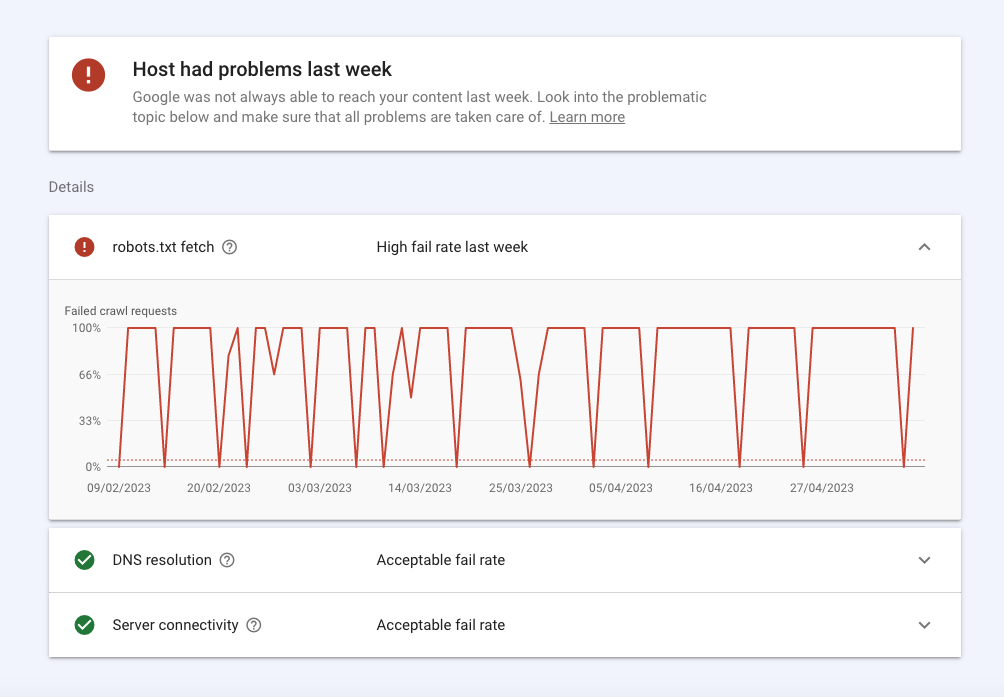

Statut de l'hôte

Le statut de l'hôte indique la disponibilité générale de ton site et si Google peut y accéder sans problème.

En voici un aperçu:

- Les erreurs dans la section robots.txt signifient que Google n'a pas pu explorer ton site pour une raison technique. Robots.txt fetch t'indique le taux d'échec que les robots ont connu lorsqu'ils ont parcouru ton fichier robots.txt. Bien que ton site n'ait pas besoin d'un fichier robots.txt, il doit renvoyer la réponse 200 ou 404 lorsqu'elle est demandée. Si Googlebot a un problème de connexion, comme un statut HTTP 503, il cessera d'explorer ton site.

- La résolution DNS t'indique quand ton serveur DNS n'a pas reconnu ton nom d'hôte ou n'a pas répondu pendant l'exploration. Si tu rencontres un problème ici, contacte ton registraire pour vérifier que ton site est correctement configuré et que ton serveur dispose d'une connexion Internet active.

- La connectivité du serveur t'indique quand ton serveur n'a pas répondu ou n'a pas fourni la réponse complète. Si tu observes des pics ou des problèmes de connectivité constants ici, tu devrais peut-être demander à ton fournisseur d'augmenter la capacité ou de résoudre les problèmes de disponibilité.

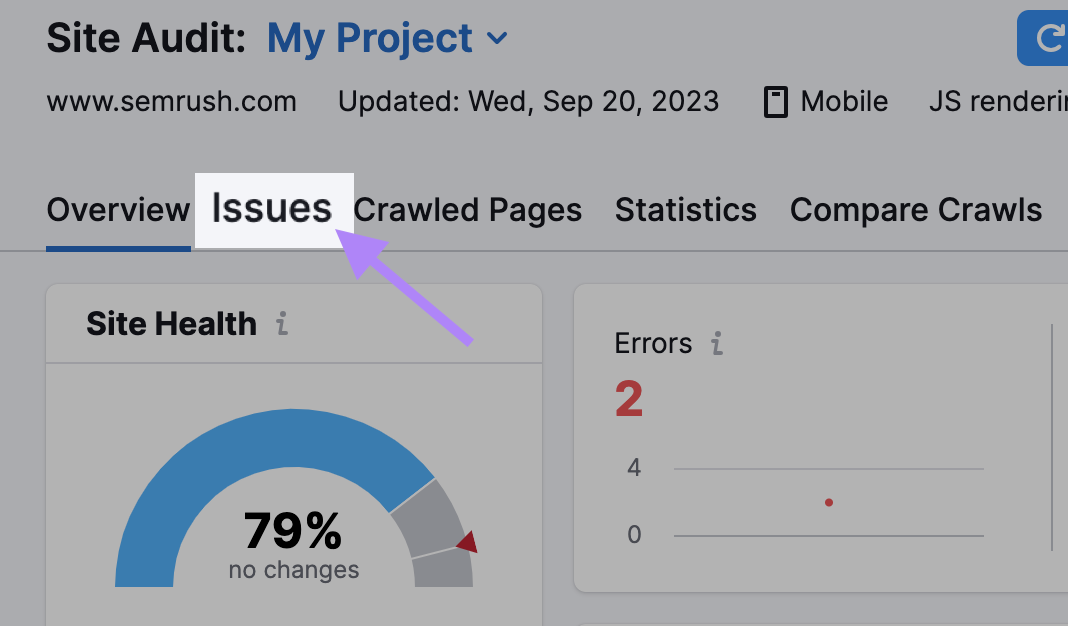

Comment vérifier la crawlabilité de ton site Web avec Site Audit ?

Utilise l'outil Audit de site pour que les SemrushBots parcourent ton site web et vérifient son état de santé.

L'outil signale plus de 140 problèmes, y compris le contenu en double et les liens brisés, que tu peux identifier et corriger.

Voici ce que tu dois faire :

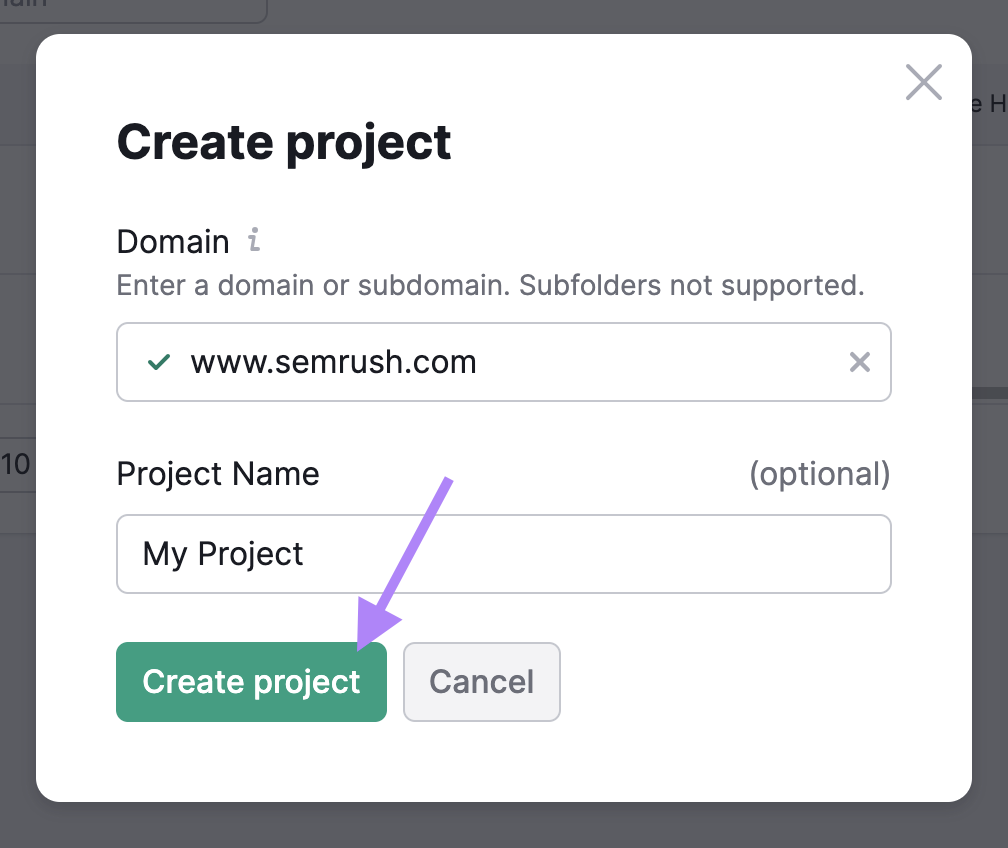

Finaliser les réglages de base

Va dans l'outil Audit de site et crée un nouveau projet s'il s'agit de ton premier audit.

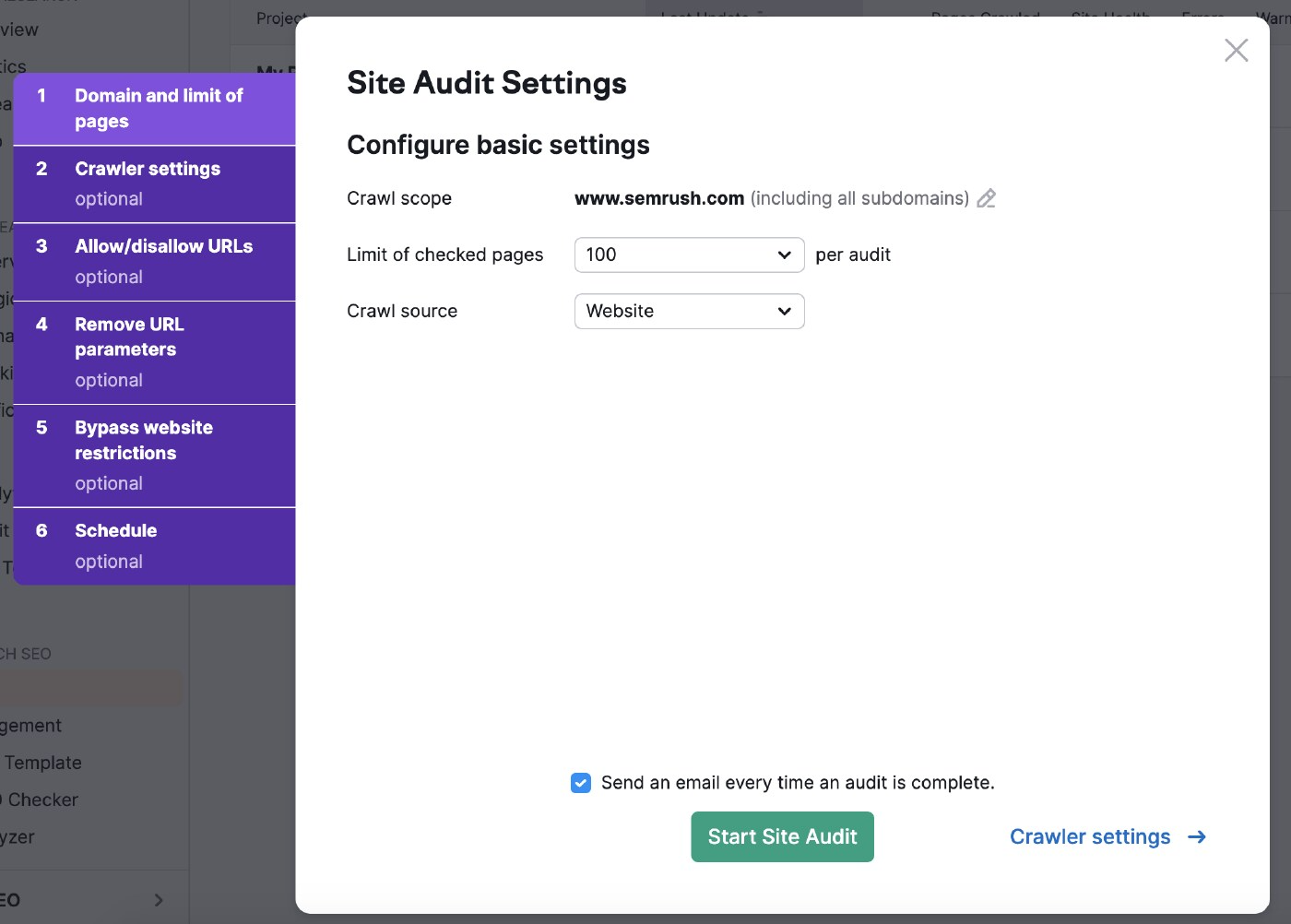

Sélectionne ensuite les paramètres d'audit de ton site.

L'étendue du crawl te permet d'affiner ta recherche.

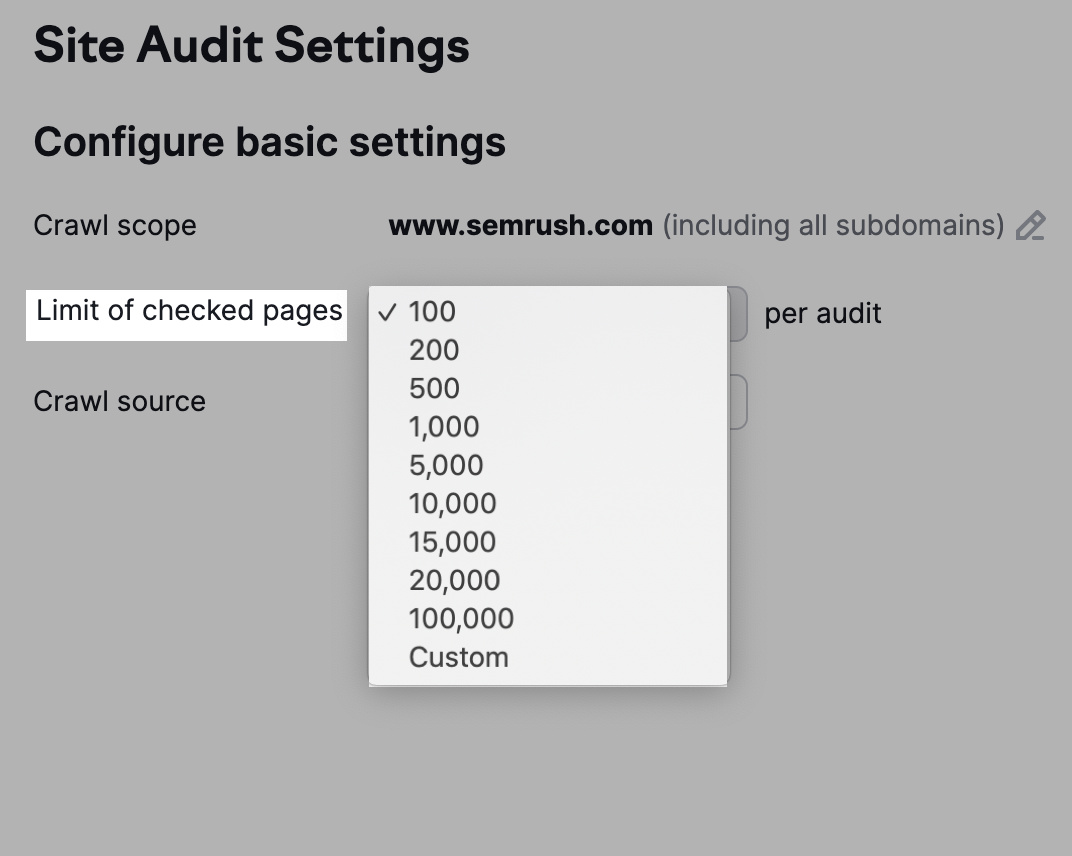

Tu peux également ajuster le nombre d'URL à vérifier par audit en fonction de ton niveau d'abonnement et de la fréquence à laquelle tu inspecteras le site Web.

Plus tu crawles de pages, plus tu obtiens une meilleure visibilité.

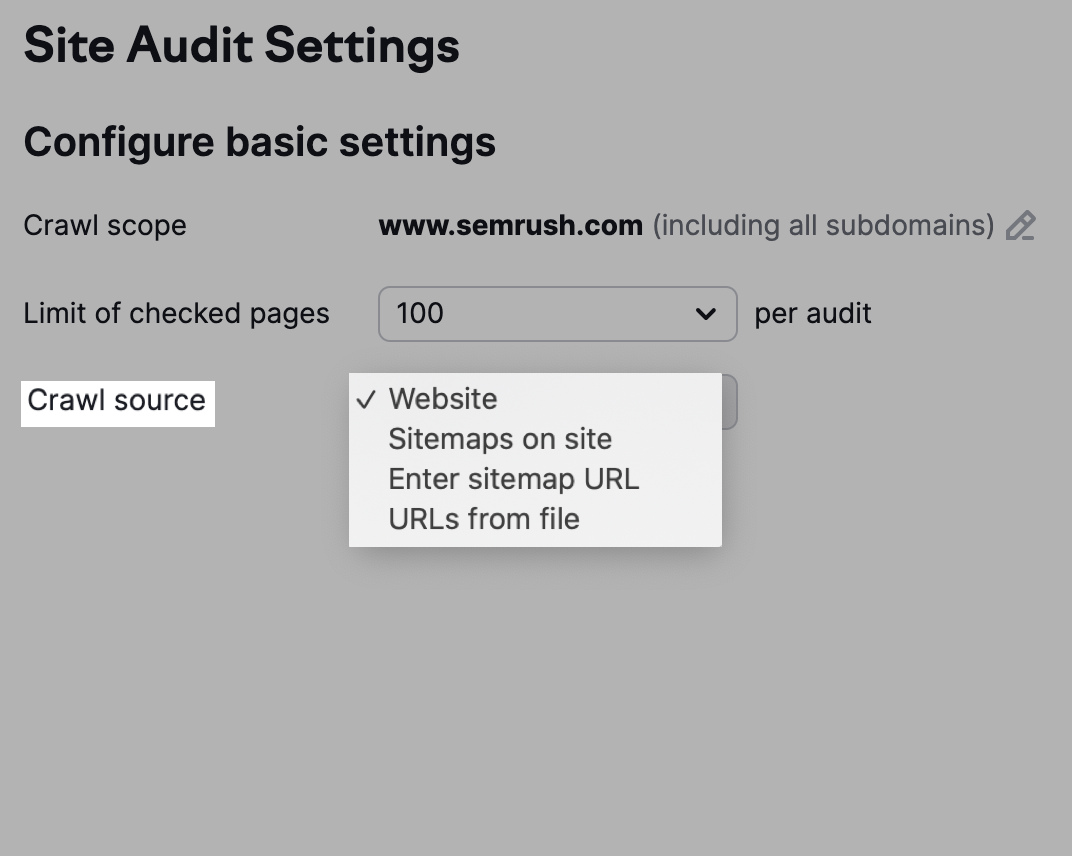

Tu as également la possibilité de choisir ta source de crawl.

Note que l'option "Site Web" permet aux robots d'explorer ton site comme le fait Google, tandis qu'une exploration utilisant "Sitemaps sur le site" utilise les URLs du sitemap du fichier robots.txt.

Tu peux aussi cliquer sur "URLs from file" pour sélectionner les pages que tu veux que les robots explorent.

Régler les paramètres de la chenille

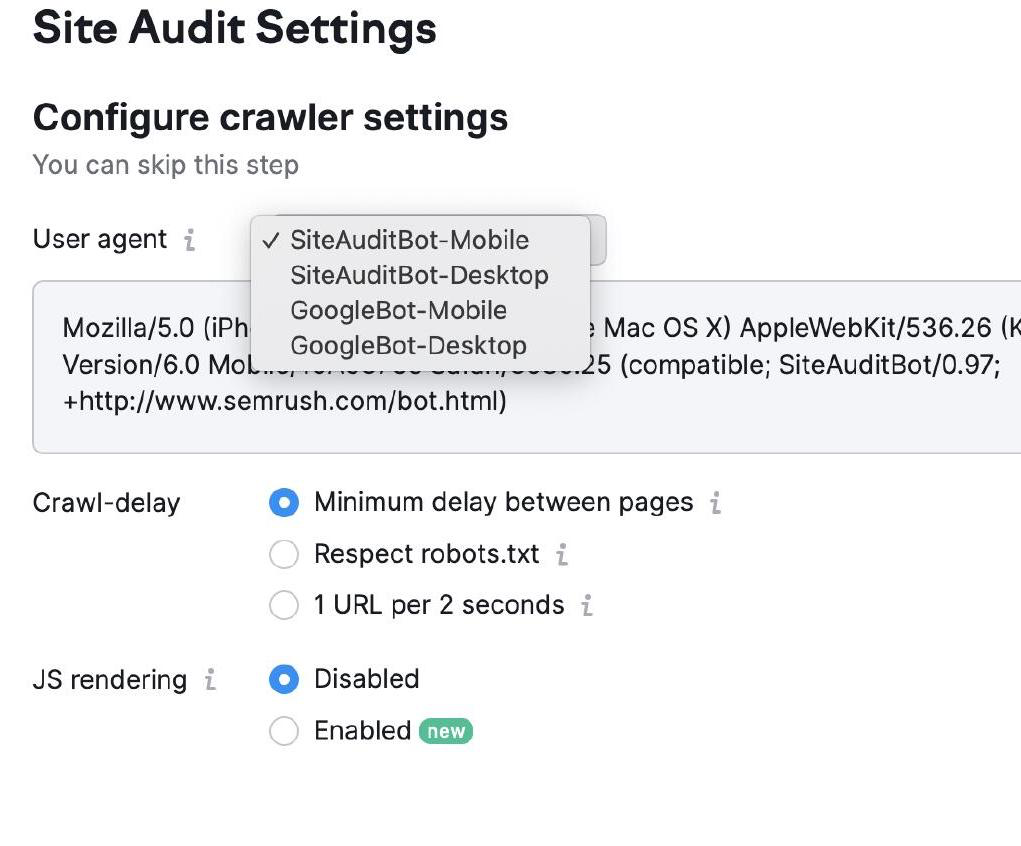

Les paramètres du crawler te permettent de choisir le type de robot qui va explorer ton site Web.

Tu peux choisir entre Googlebot et SemrushBot et entre les versions mobile et de bureau.

Sélectionne ensuite les paramètres de ton délai d'attente. Les robots rampent à une vitesse normale avec un "délai minimum" et donnent la priorité à l'expérience de l'utilisateur dans les paramètres "1 URL par 2 secondes".

Enfin, sélectionne "Respecter robots.txt" si tu as le fichier correspondant et que tu as besoin d'un délai de crawl spécifique.

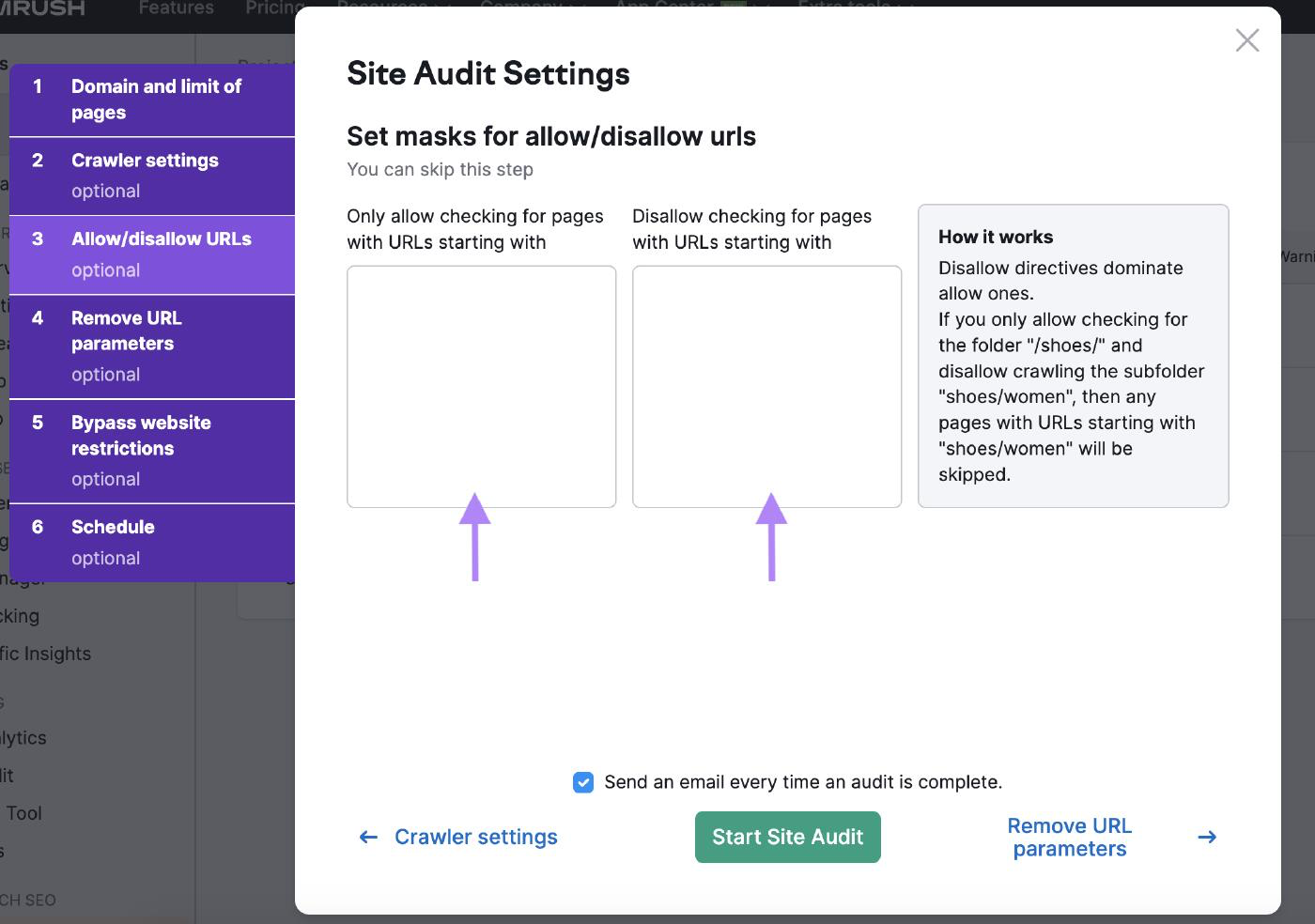

Autoriser/refuser les URL

Personnalise l'audit de ton site avec des paramètres d'autorisation/interdiction d'URL en entrant les URL dans les cases correspondantes.

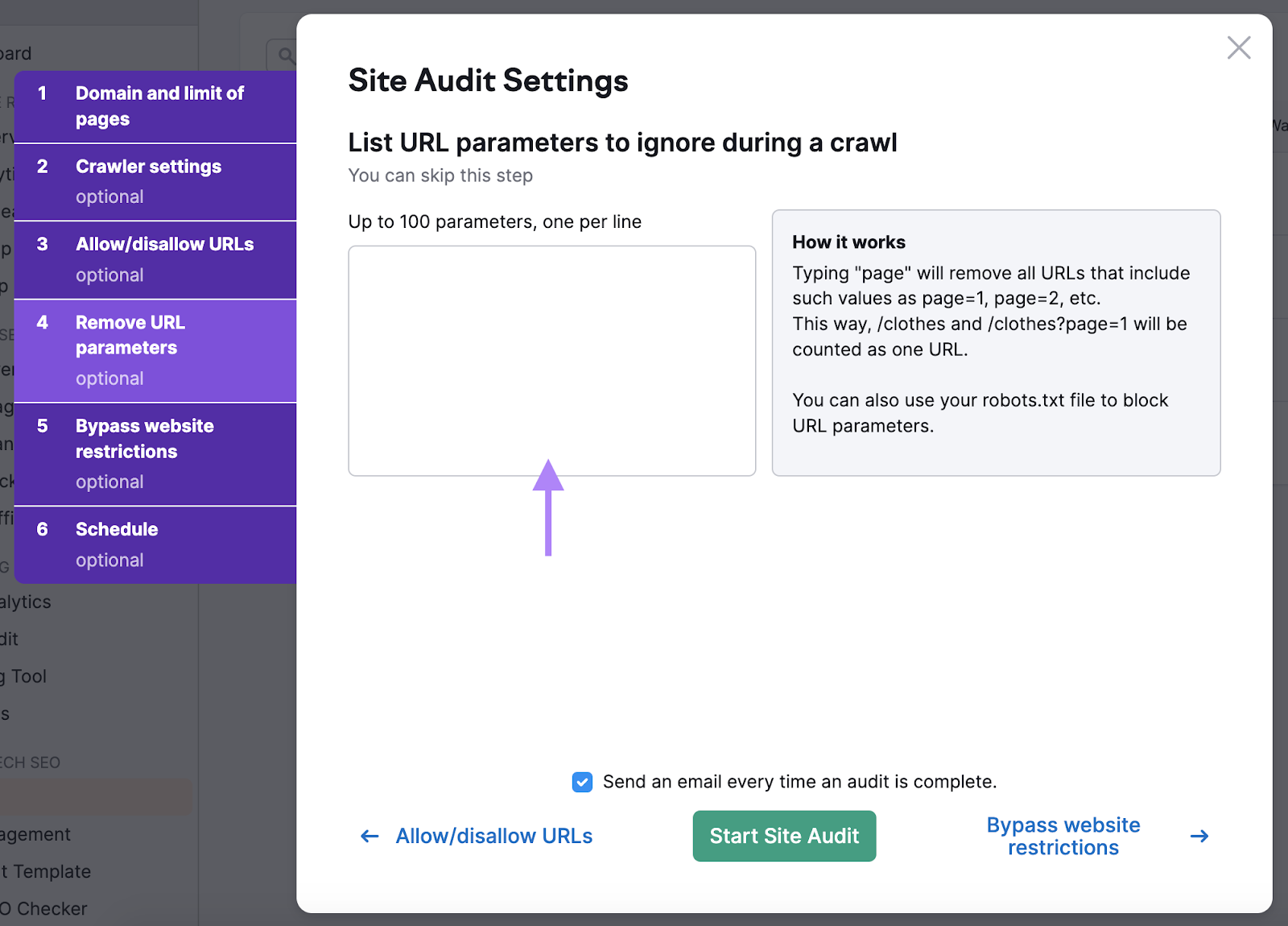

Supprimer les paramètres de l'URL

Suppression des paramètres URL permet aux robots de ne pas gaspiller le budget d'exploration en explorant deux fois la même page.

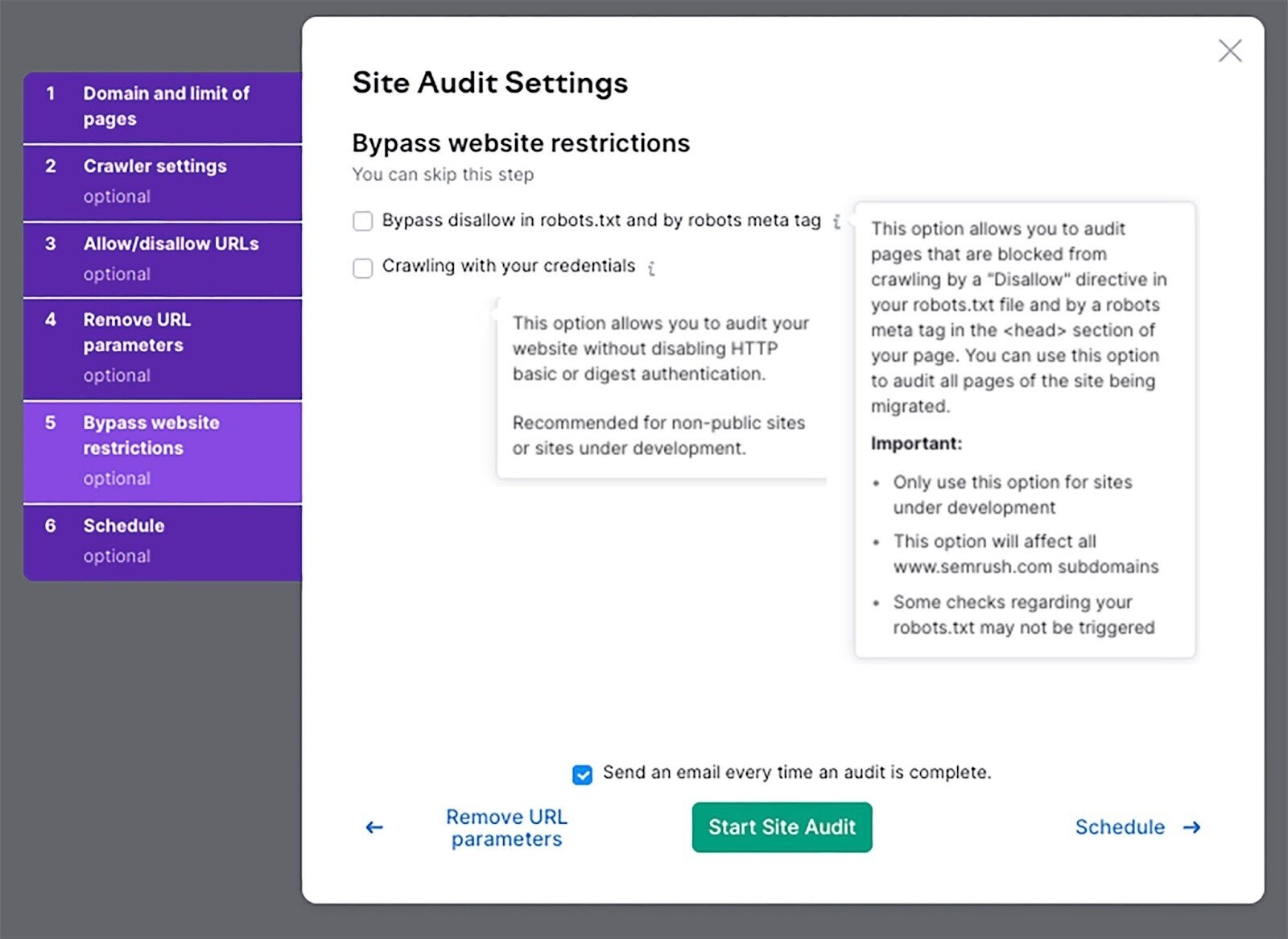

Contourner les restrictions des sites Web

Si ton site Web est encore en cours de développement, utilise ce paramètre pour effectuer un audit.

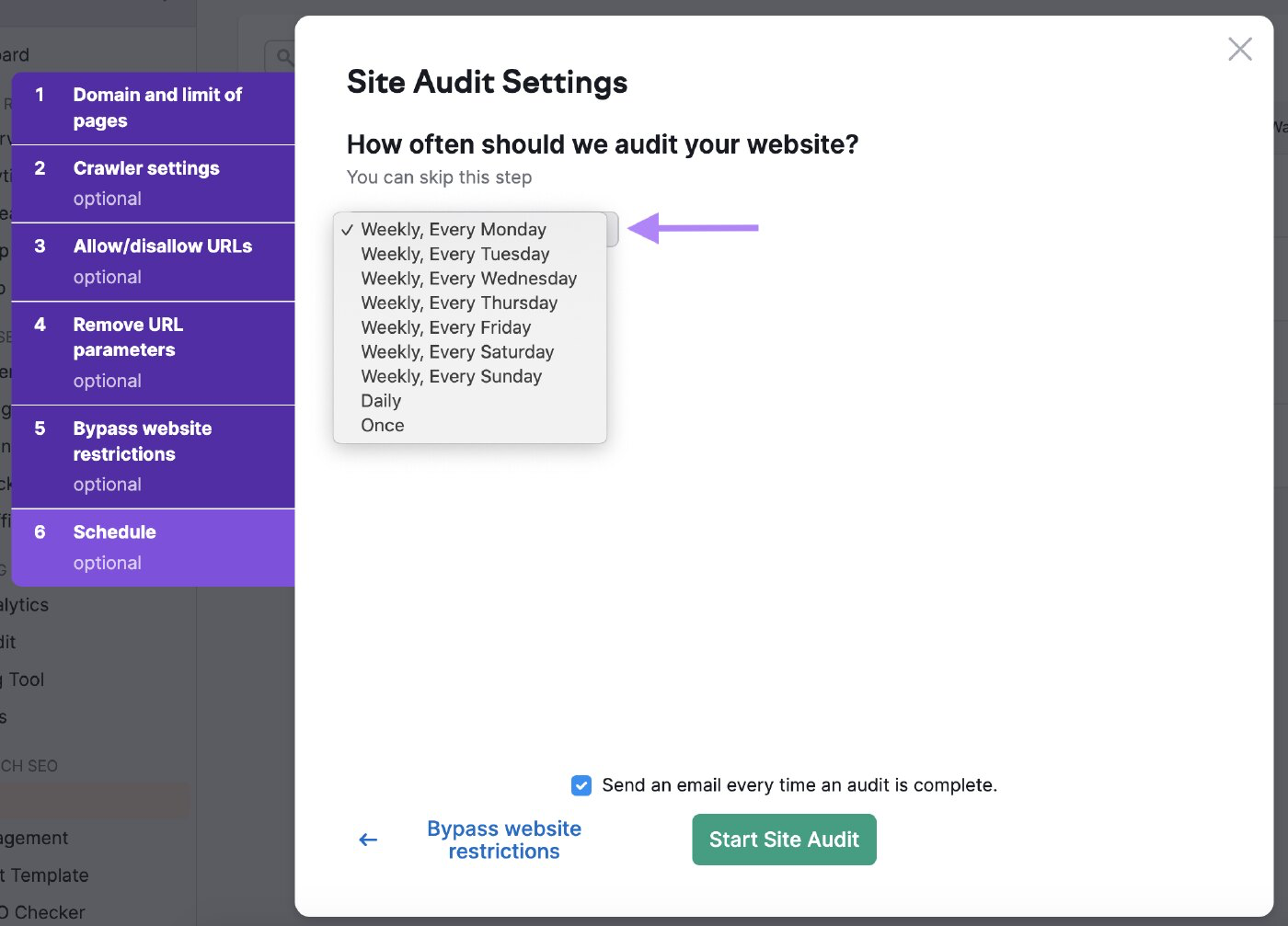

Planifie tes audits

Tu peux programmer la fréquence à laquelle tu veux que le robot vérifie ton site Web.

Programme-le fréquemment pour t'assurer que l'outil vérifie régulièrement la santé de ton site Web.

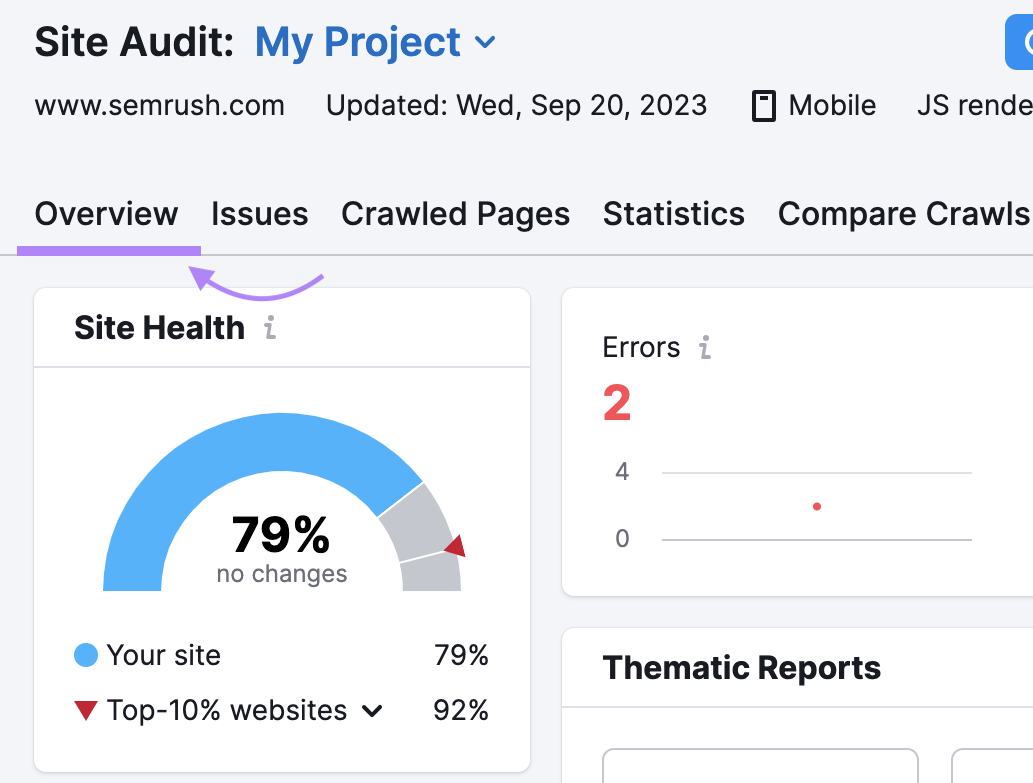

Analyse les résultats

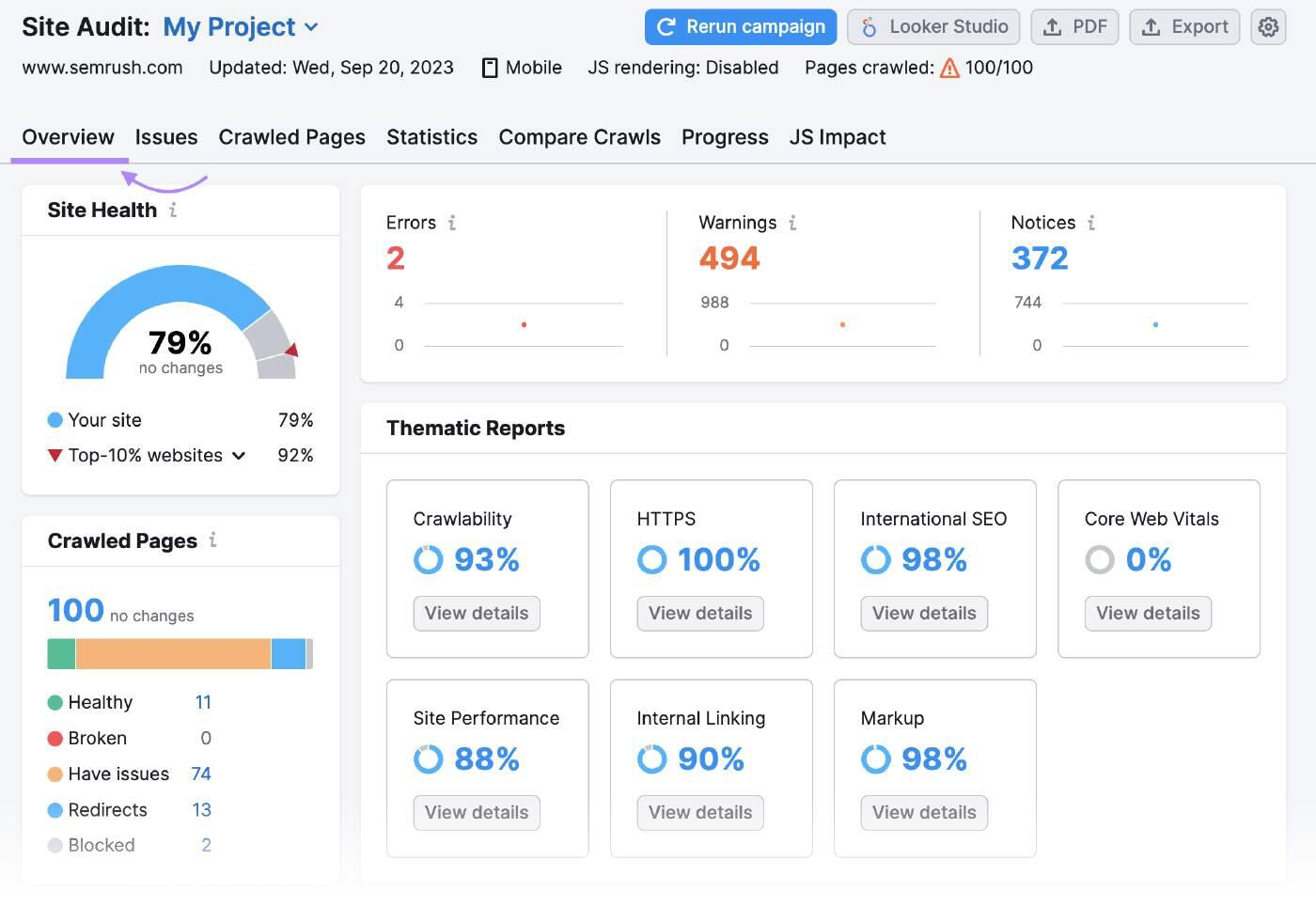

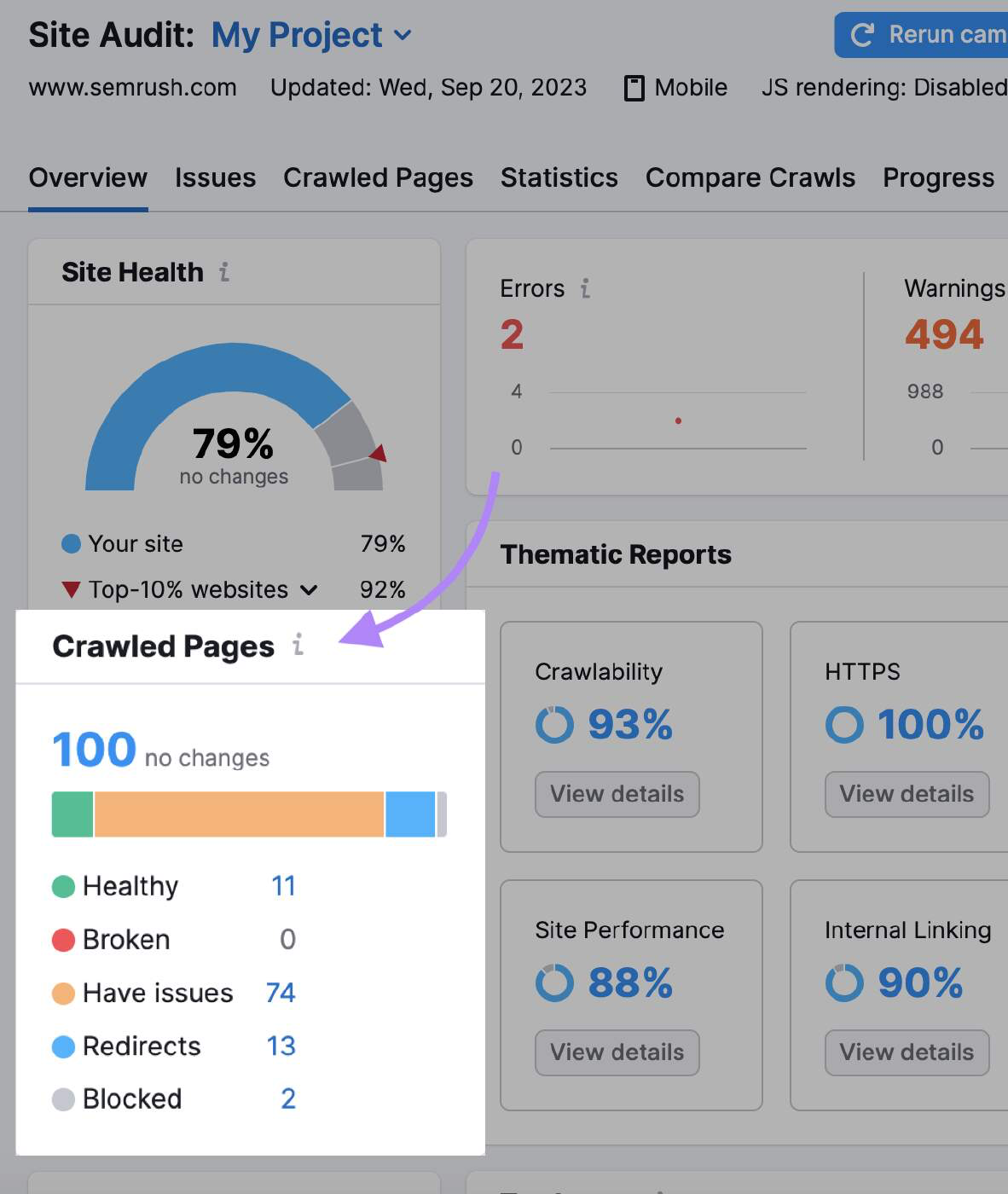

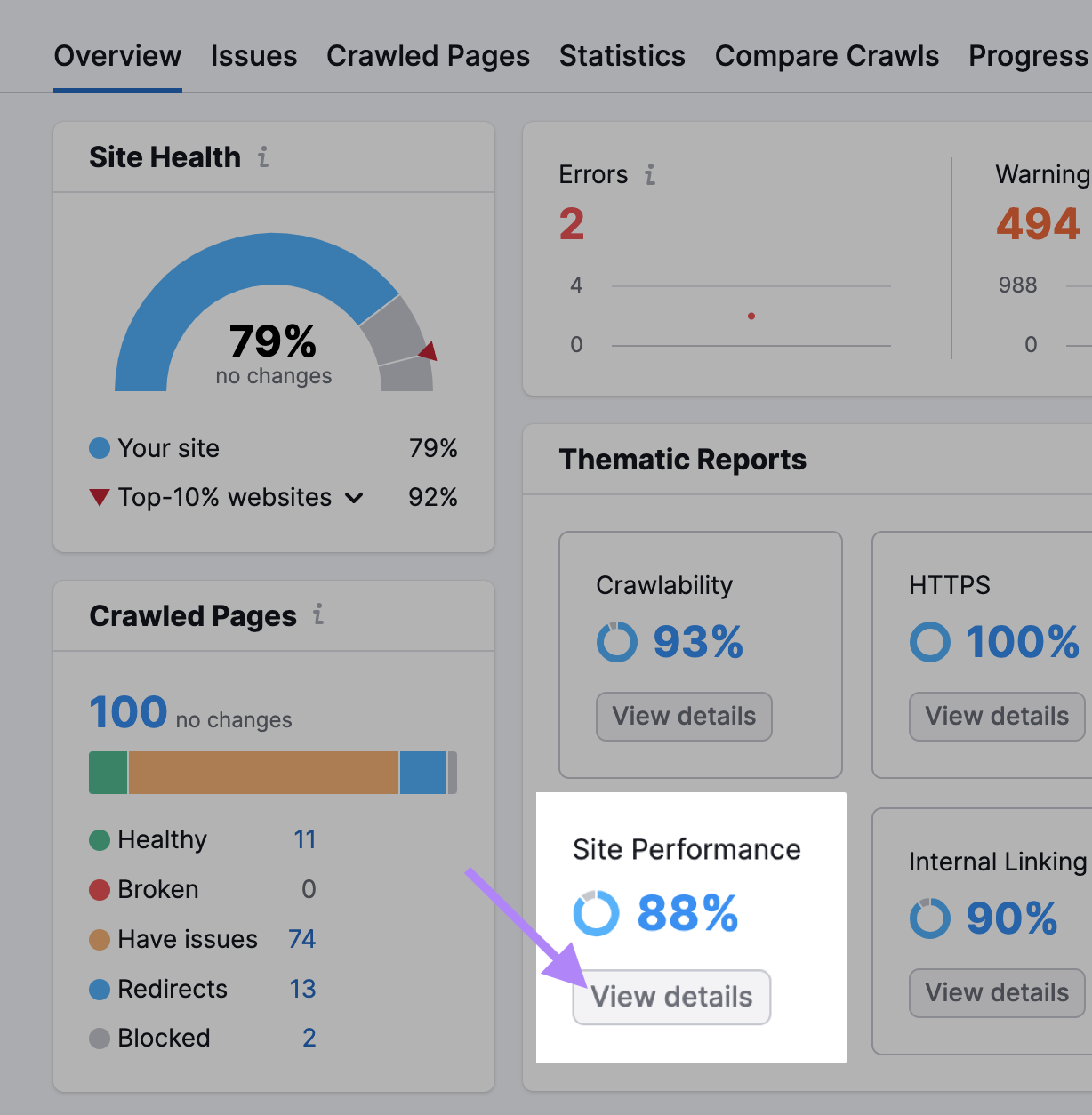

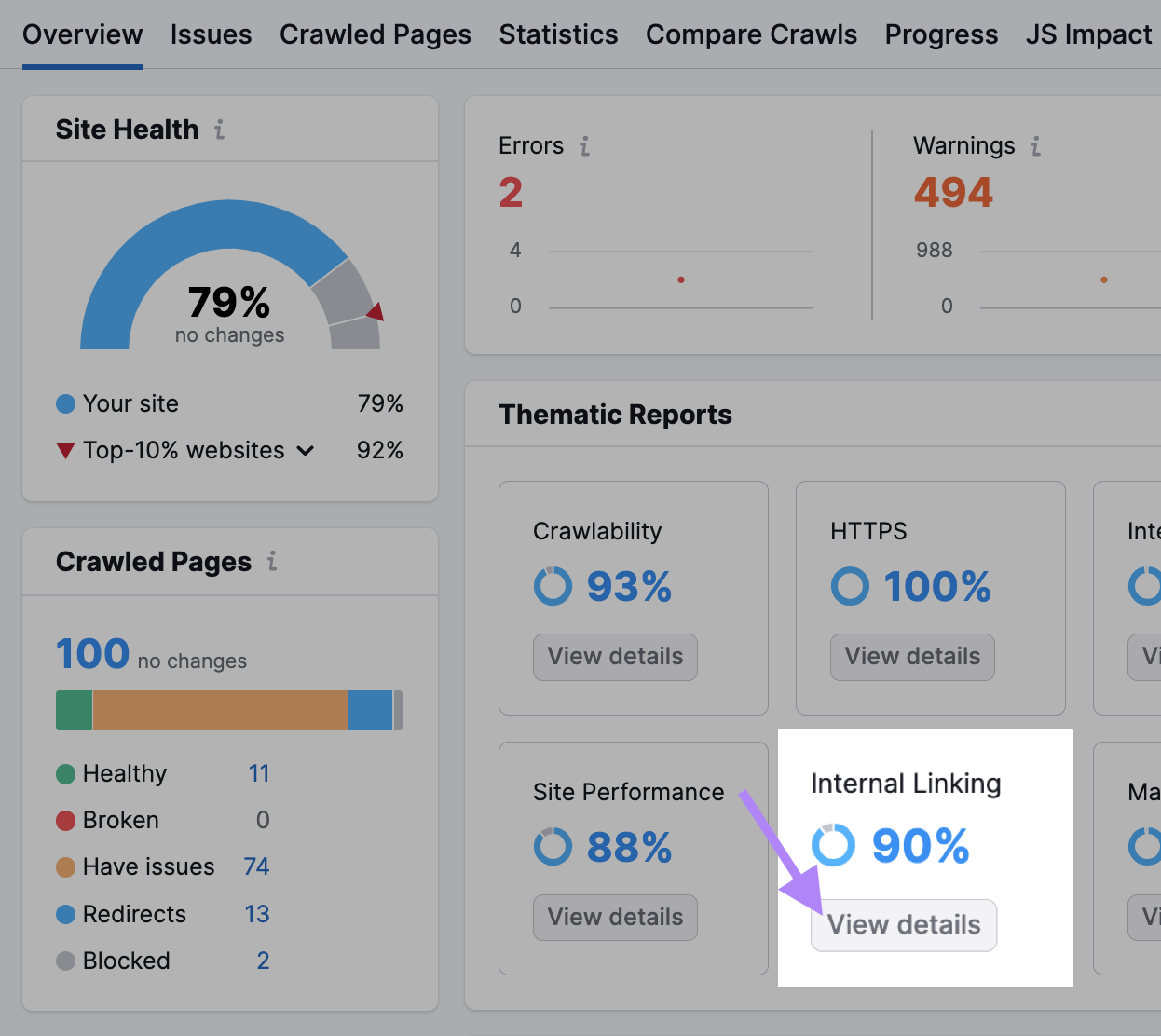

L'aperçu de l'audit du site résume toutes les données que les robots ont collectées pendant l'exploration.

"Pages parcourues" t'indique combien de pages étaient "saines", "cassées" et "ont des problèmes".

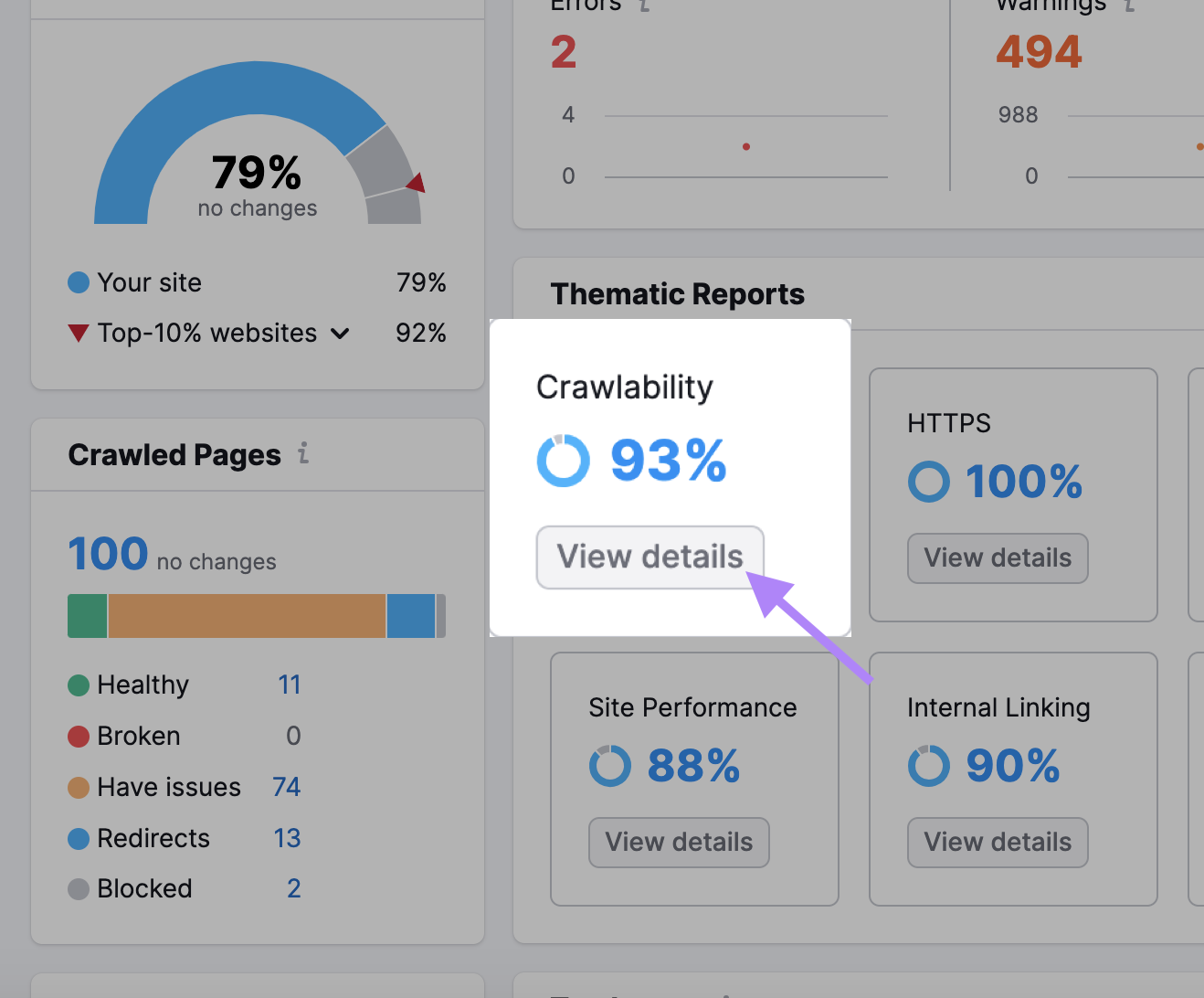

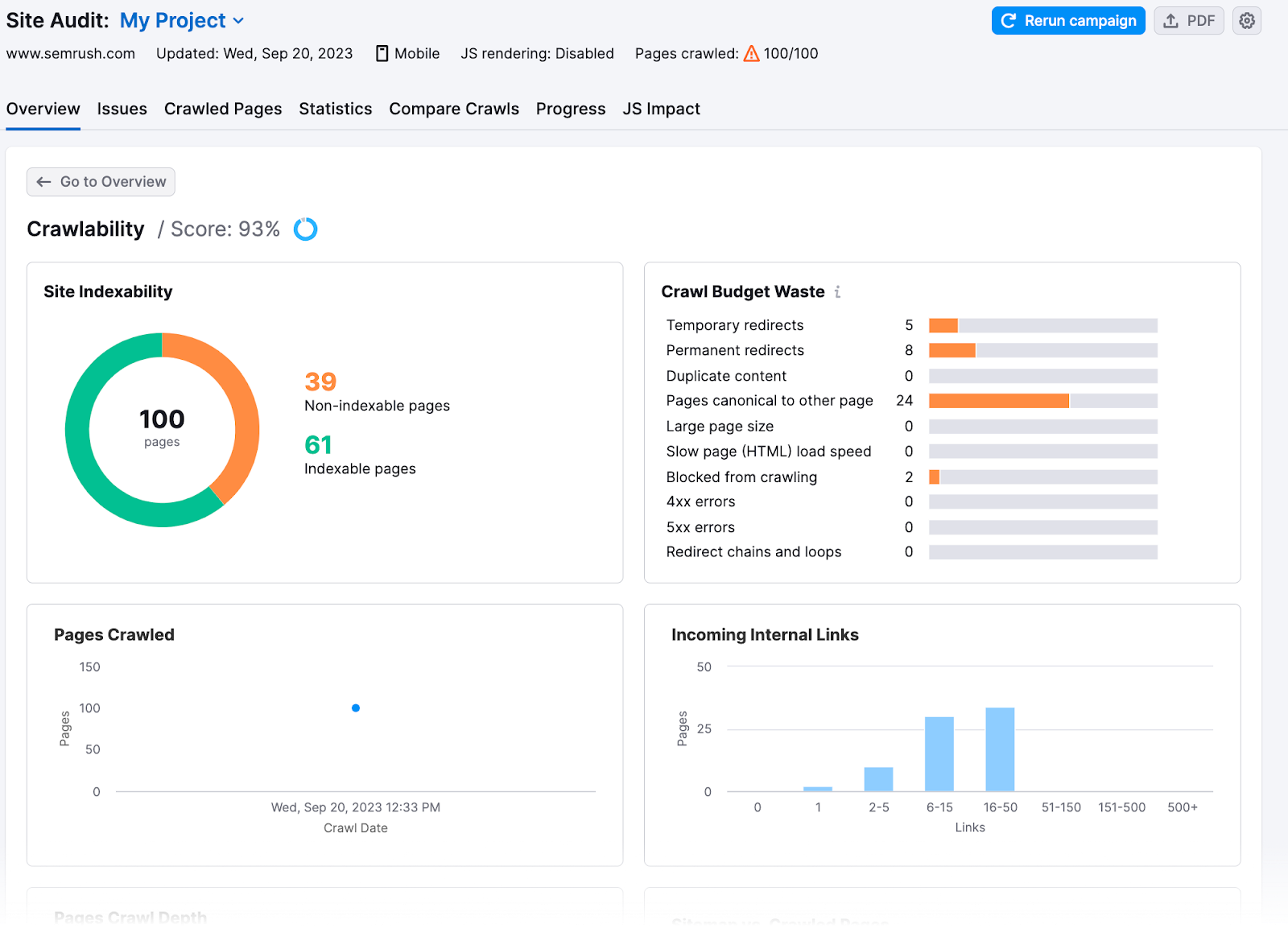

Tu obtiens également des informations plus approfondies dans la section "Crawlability".

Ici, tu trouveras combien du budget de crawl de ton site a été gaspillé ou a eu des problèmes de budget de crawl.

8 conseils pour l'optimisation du budget de crawl

Une fois que tu connais les problèmes de ton site, tu peux les résoudre et maximiser l'efficacité de son crawl. Voici comment optimiser ton budget pour le crawl :

Vérifie la vitesse de ton site

L'exploration de Google est limitée par la bande passante, le temps et la disponibilité des ressources du Googlebot. Si le serveur d'un site Web répond plus rapidement aux demandes, Google peut explorer plus de pages.

Augmente la vitesse de ton site pour améliorer l'expérience utilisateur(UX) et aider Google à explorer ton site plus rapidement.

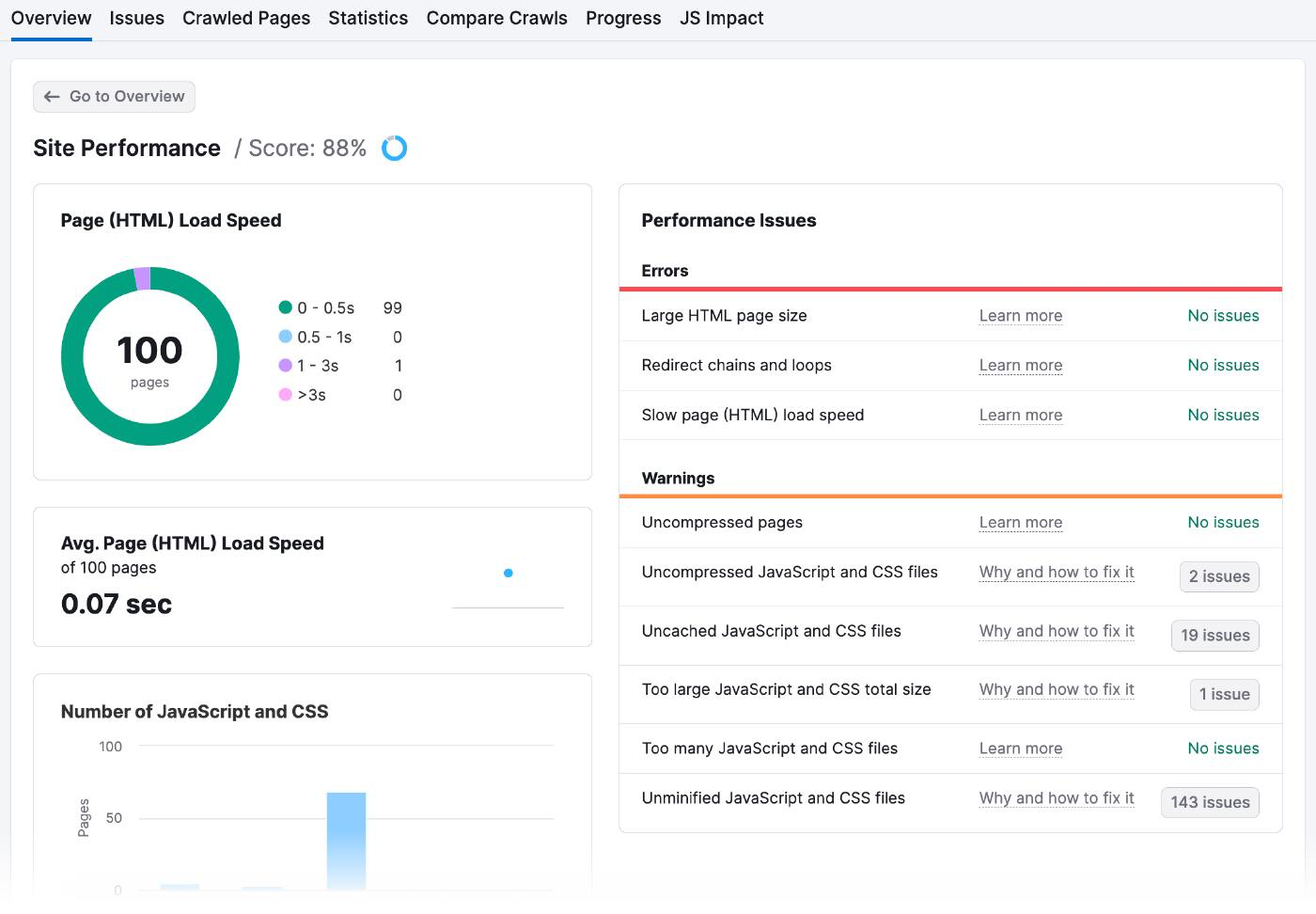

Dirige-toi vers les résultats de l'audit du site pour vérifier les temps de chargement de tes pages et les éventuels problèmes de performance.

Voici à quoi ressemble la page des performances du site:

Il existe de nombreuses façons d'améliorer la vitesse des pages, notamment :

- Optimise tes images: Utilise des outils en ligne comme Optimizilla pour réduire la taille des fichiers sans les pixelliser. Veille à la bonne taille des images et choisis le type de fichier approprié (comme JPEG, PNG ou GIF).

- Minimise ton code et tes scripts : Analyse le code de ton site Internet pour supprimer tout ce qui est inutile ou redondant. Consolide également plusieurs fichiers en un seul et utilise la mise en cache du navigateur pour stocker les données sur l'ordinateur de l'utilisateur afin qu'elles n'aient pas besoin d'être rechargées à chaque fois.

- Utiliser un réseau de diffusion de contenu (CDN) : Un CDN est un réseau de serveurs situés dans différentes parties du monde. Lorsque quelqu'un essaie d'accéder à ton site web, le CDN lui envoie automatiquement le contenu du serveur le plus proche, ce qui signifie que le chargement est plus rapide. Tu devras t'inscrire à un service CDN comme Amazon Cloudfront, télécharger le contenu de ton site web sur leurs serveurs, et configurer ton site web pour qu'il utilise les URL du CDN au lieu des tiennes.

Augmenter les liens internes et les pages sitemaps

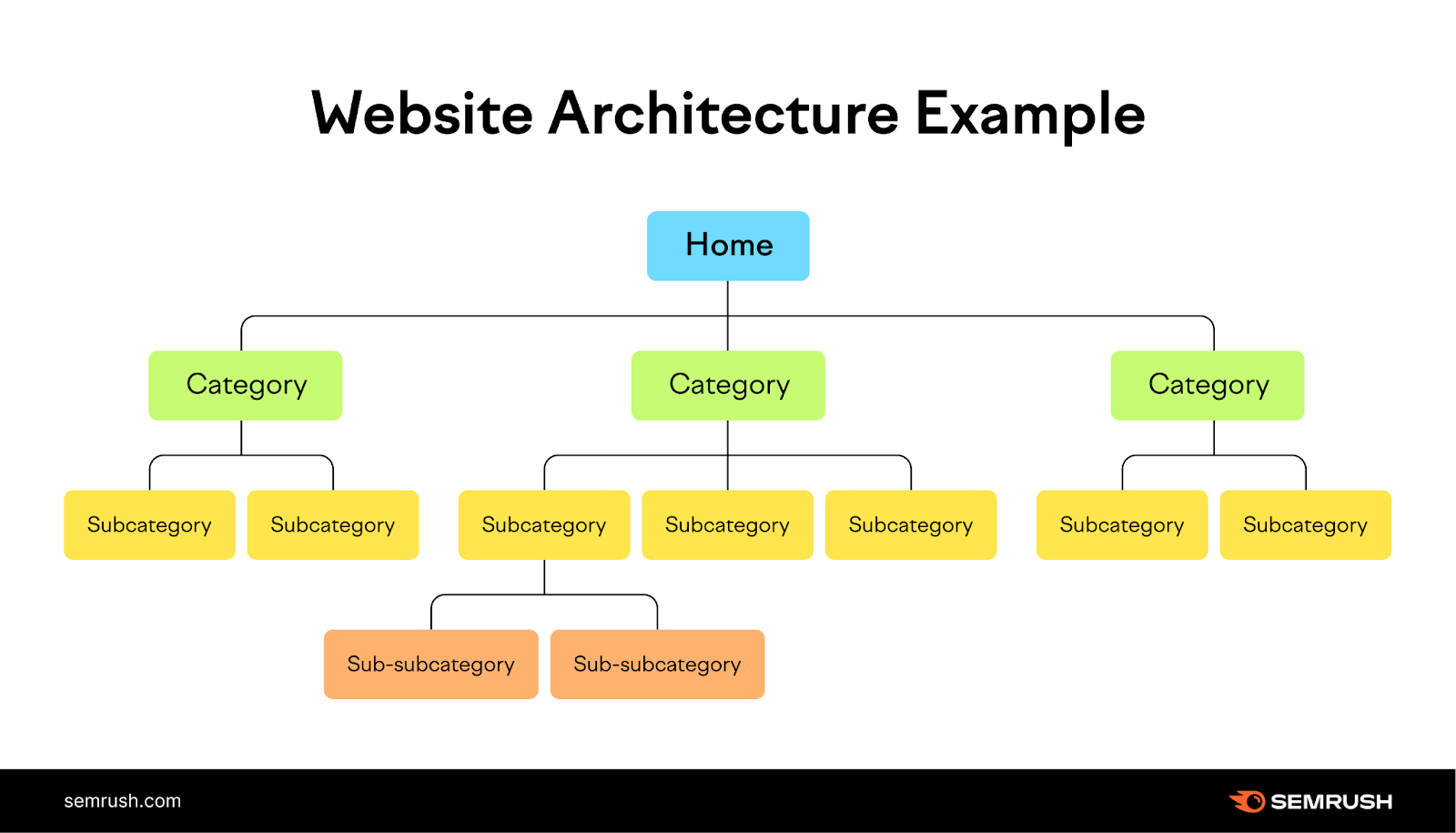

L'ajout d'une structure de liens internes logique et d'un plan du site donne aux robots des indications sur les pages à indexer.

Les liens internes fournissent un chemin naturel aux robots des moteurs de recherche pour découvrir et classer les nouvelles pages, tandis que les sitemaps les aident à comprendre la structure et la hiérarchie de ton contenu.

Imagine ton site Internet comme un arbre, avec la page d'accueil au sommet et les branches représentant les différentes catégories. Chaque branche doit mener à de plus petites feuilles (pages) qui lui sont liées, créant ainsi une structure claire et logique pour ton site Internet, facile à parcourir pour les utilisateurs.

Vérifie la section sur les liens internes de l'audit de ton site pour avoir une idée de la façon dont tu l'as fait.

Lorsque tu disposes de ces données, voici comment tu peux améliorer ta structure de liens internes :

- Les barres de la structure des liens internes t'indiquent lesquelles de tes pages sont fortes, médiocres et doivent être améliorées. Ajoute plus de liens internes aux pages des deux dernières catégories.

- Crée des groupes de sujets en regroupant des pages connexes sous un même sujet et en les reliant les unes aux autres. Imaginons que tu tiennes un blog sur la vie saine. Ta page pilier principale pourrait être "Vie saine" et tes groupes de sujets pourraient être "Nutrition", "Forme physique" et "Santé mentale".

- Google explorera très probablement les pages comportant de nombreux liens internes. Ce sont ceux qui sont nouveaux et qui n'ont pas assez de liens internes pointant vers eux qui risquent de rencontrer des problèmes. Par exemple, si tu as récemment ajouté un article sur les "Prédictions marketing pour 2024", crée un lien vers cet article à partir de tes pages les plus importantes pour attirer l'attention et le trafic de Google.

Cache les URL que tu ne veux pas voir apparaître dans les résultats de recherche

Marque les pages de paiement, les pages d'atterrissage des annonces, les pages de connexion et les pages de remerciement comme "noindex" afin qu'elles n'apparaissent pas dans les résultats des moteurs de recherche. Comme les autres balises méta, la balise "noindex" se trouve dans l'en-tête d'une page web <>.

Cette balise est particulièrement utile pour les pages dupliquées ou d'autres pages que tu veux garder privées.

Même si les robots continueront à explorer ces pages pour voir la balise, ils en prendront note et limiteront l'exploration de ces pages à l'avenir.

Pour indiquer aux moteurs de recherche de ne pas indexer une page spécifique, utilise les balises méta robots avec un attribut "noindex".

Place la balise suivante dans l'en-tête <> de ta page :

<meta name="robots" content="noindex">Réduire les redirections

Les redirections env oient automatiquement les robots d'une page web à une autre. Si le bot visite une page qui a été déplacée ou supprimée, la redirection l'emmène vers le nouvel emplacement de la page ou vers une page qui explique pourquoi la page d'origine n'est plus disponible.

Les redirections demandent plus de ressources au robot puisqu'il visite plus de pages que nécessaire.

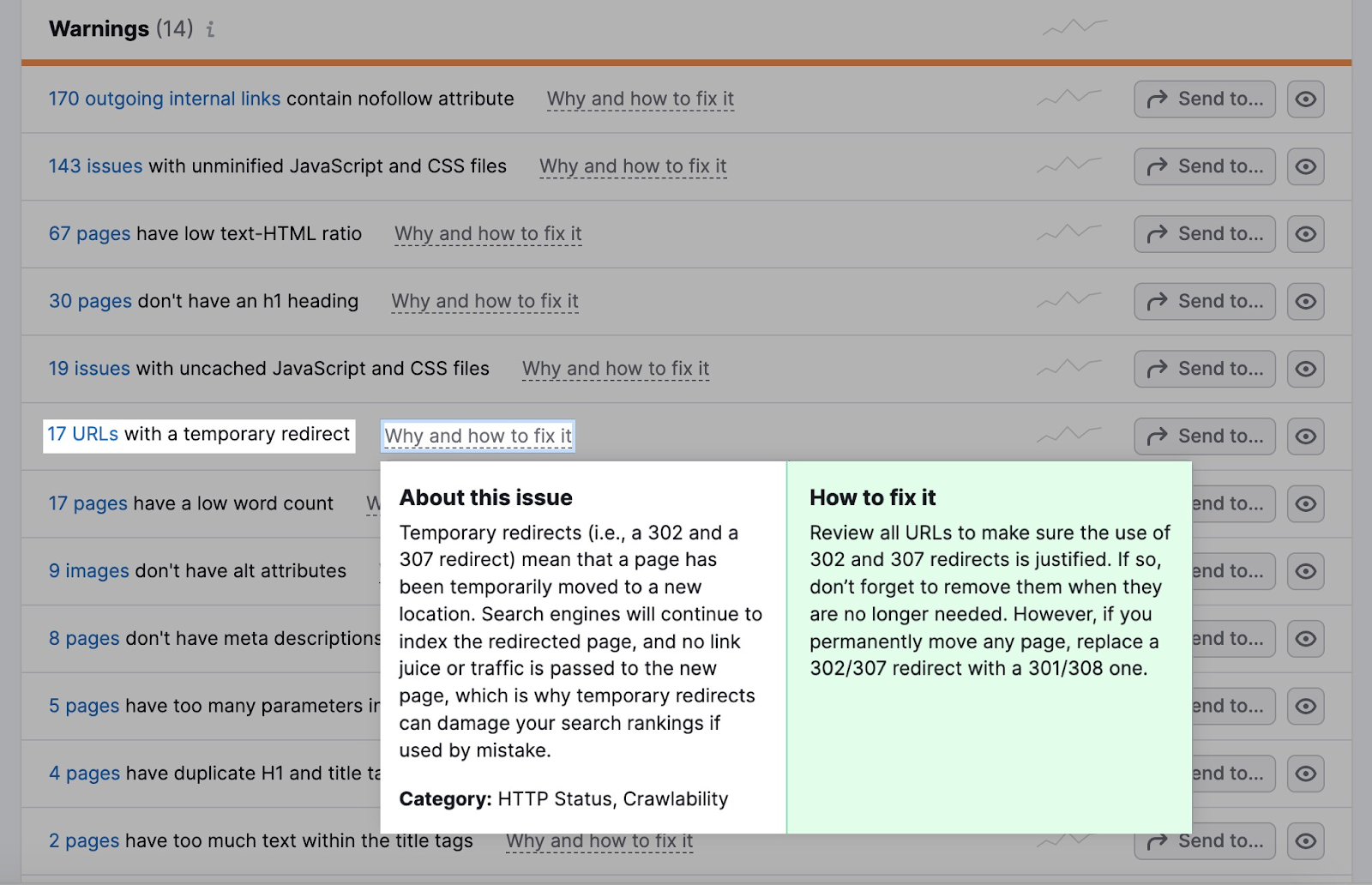

Va dans l'onglet Problèmes de ton audit de site.

La section Avertissements t'indiquera combien d'URL ont une redirection temporaire.

La plupart des navigateurs suivent un maximum de cinq chaînes de redirection au cours d'un crawl.

Si tu utilises des redirections, assure-toi qu'elles sont logiques.

Imaginons qu'un site Internet de sport propose un article sur un match de football de l'année dernière avec l'URL "exemple.com/match-de-football-2022".

Cependant, le jeu de cette année a une URL différente : "exemple.com/jeu-de-football-2023".

Pour éviter toute confusion, le site Web peut mettre en place une redirection de sorte que toute personne essayant d'accéder à "exemple.com/football-match-2022" soit automatiquement redirigée vers "exemple.com/football-match-2023".

Cette réorientation serait logique.

D'un autre côté, le site web peut avoir plusieurs redirections inutiles, comme rediriger de "exemple.com/football-game-2022" vers "exemple.com/football-game-recaps" puis vers "exemple.com/football-game-2023".

Cela créerait une chaîne de redirection qui gaspillerait des ressources et pourrait nuire à l'efficacité du crawl du site Web.

Réparer les liens brisés

Les liens brisés sont des pages auxquelles les robots ne peuvent pas accéder. Ils nuisent à la navigabilité de ton site et à l'expérience des utilisateurs.

Lorsque les robots ne peuvent pas accéder à une page, ils ne peuvent pas l'explorer et l'indexer. Trop de ces erreurs ralentissent le processus de crawl et mangent ton budget de crawl.

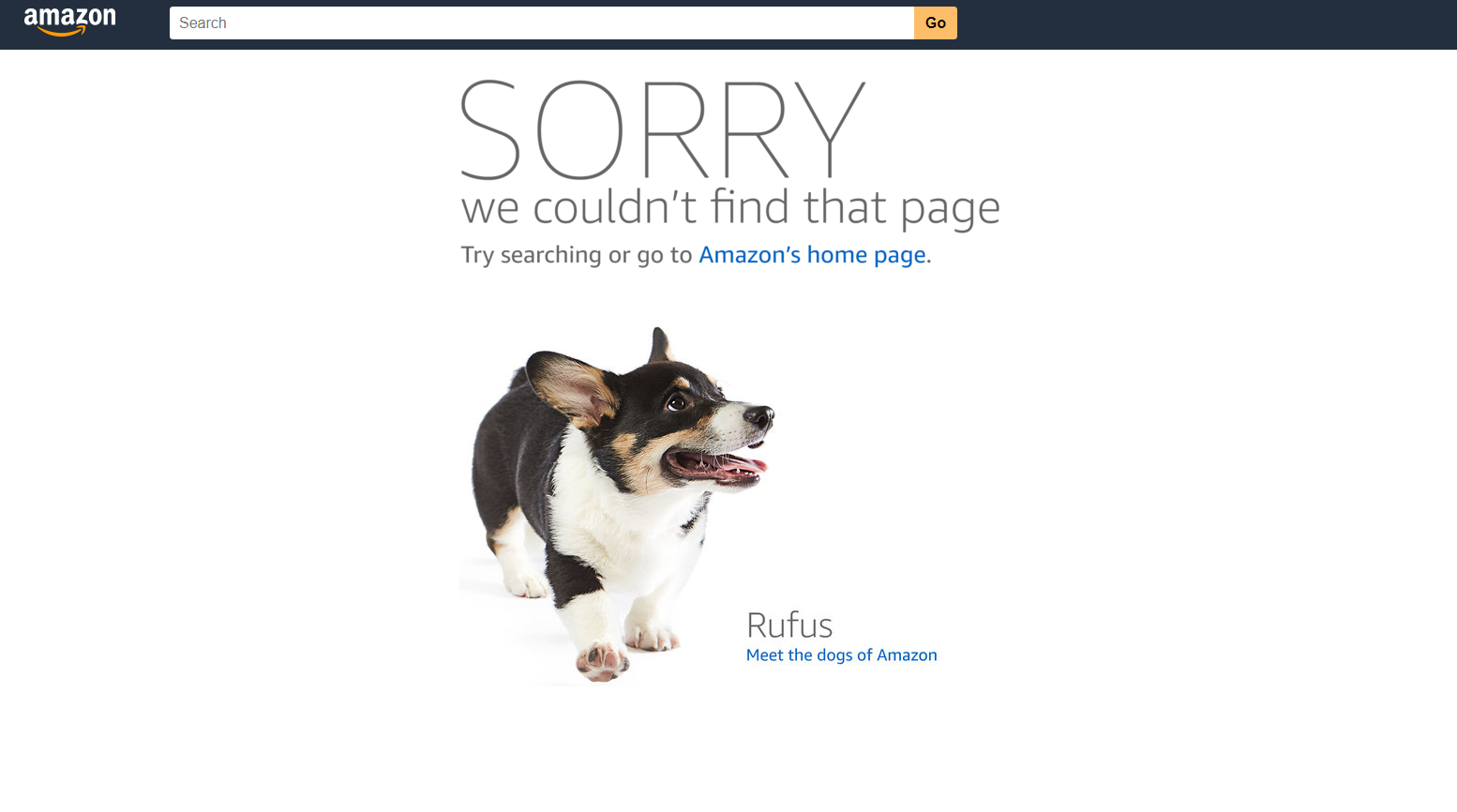

Une erreur 404 sur Amazon, par exemple, ressemble à ceci.

Nous avons traduit cet article de l'anglais. Clique ici pour lire l'article original. Si tu remarques des problèmes dans le contenu, n'hésite pas à nous contacter à report-osteam@semrush.com.

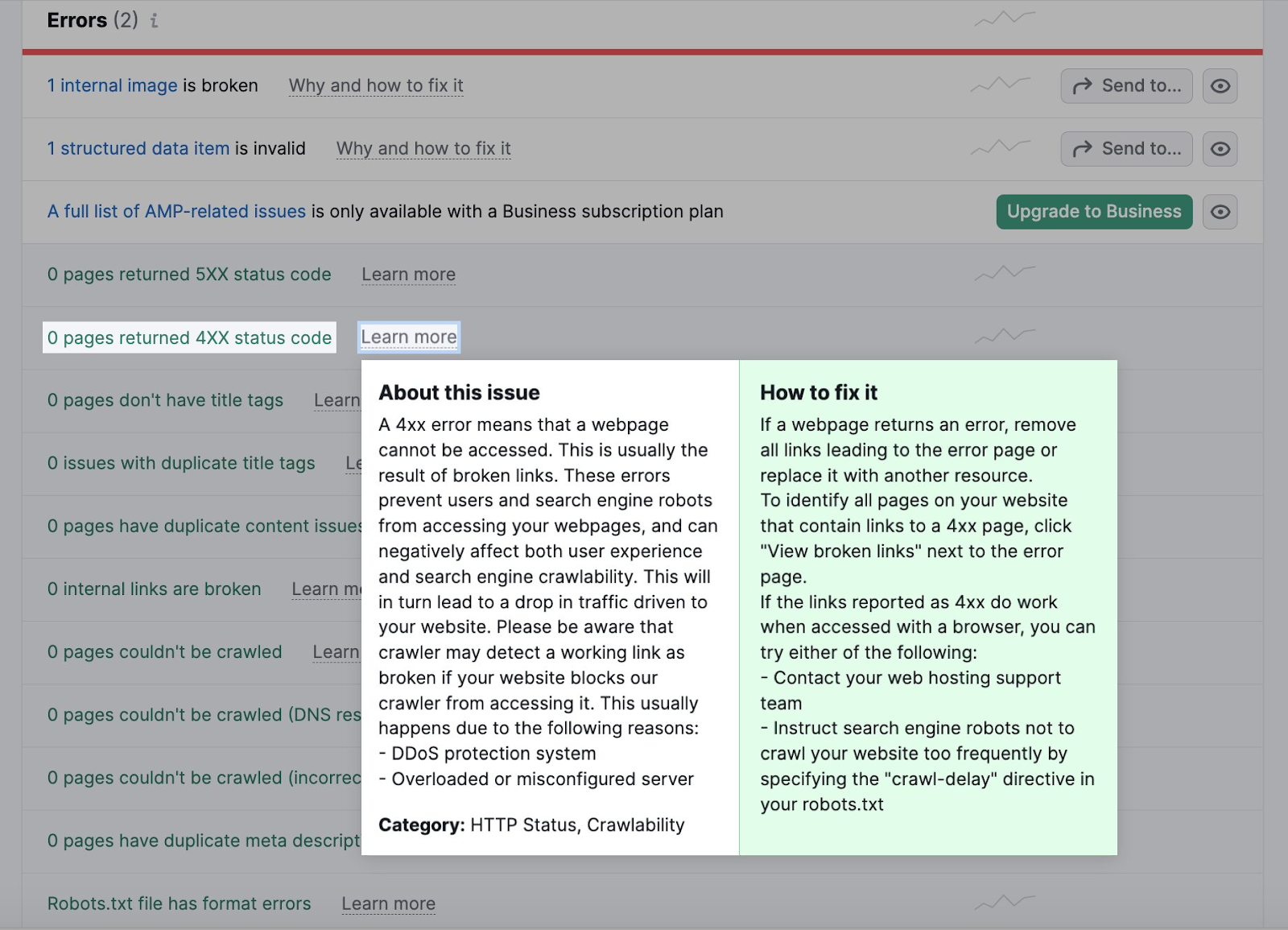

Tu peux identifier les liens brisés comme des erreurs 4xx dans l'onglet Problèmes de ton audit de site.

Clique sur le nombre de pages pour vérifier si elles sont cassées. Remplace ensuite tous les liens menant à la page cassée par une autre page.

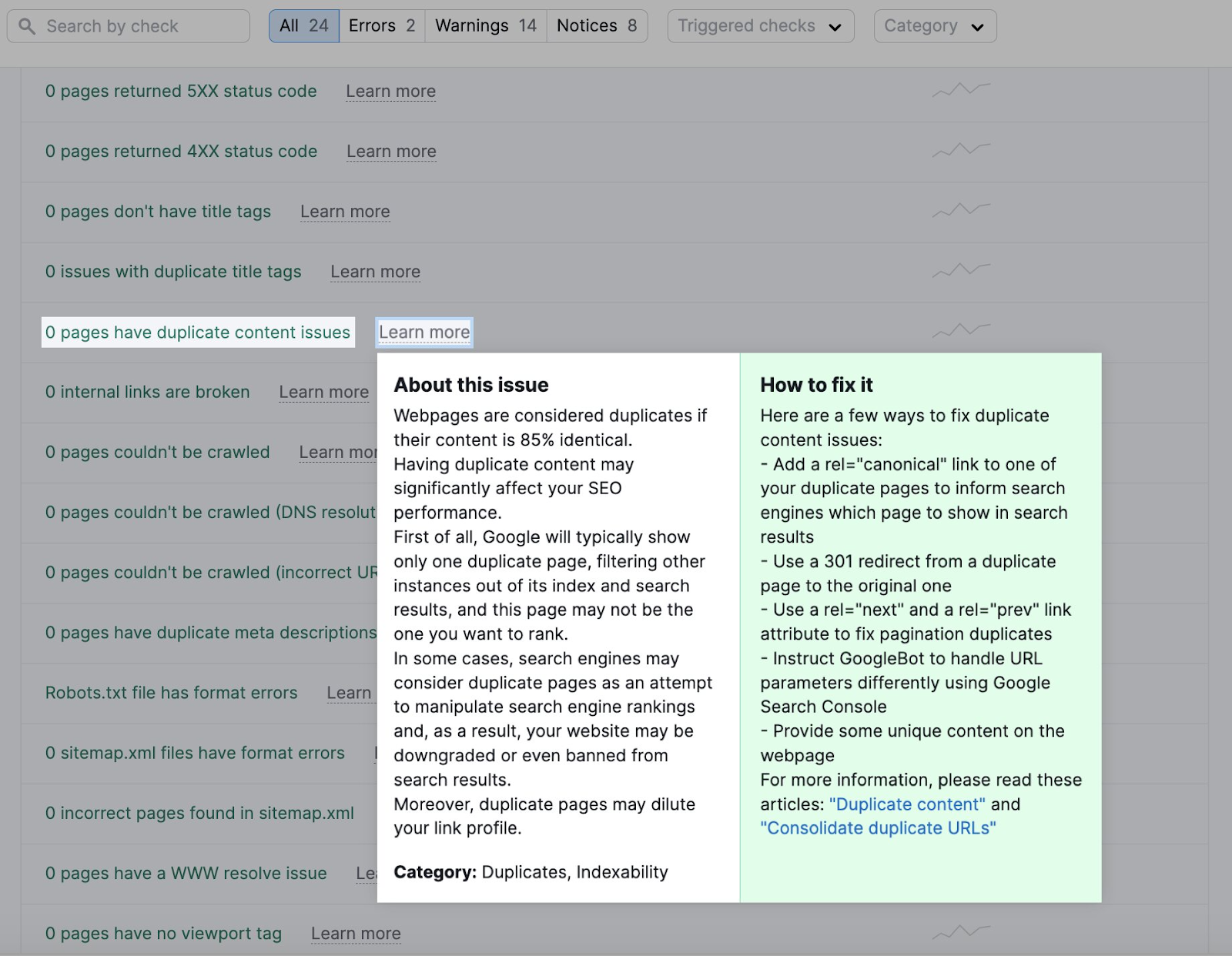

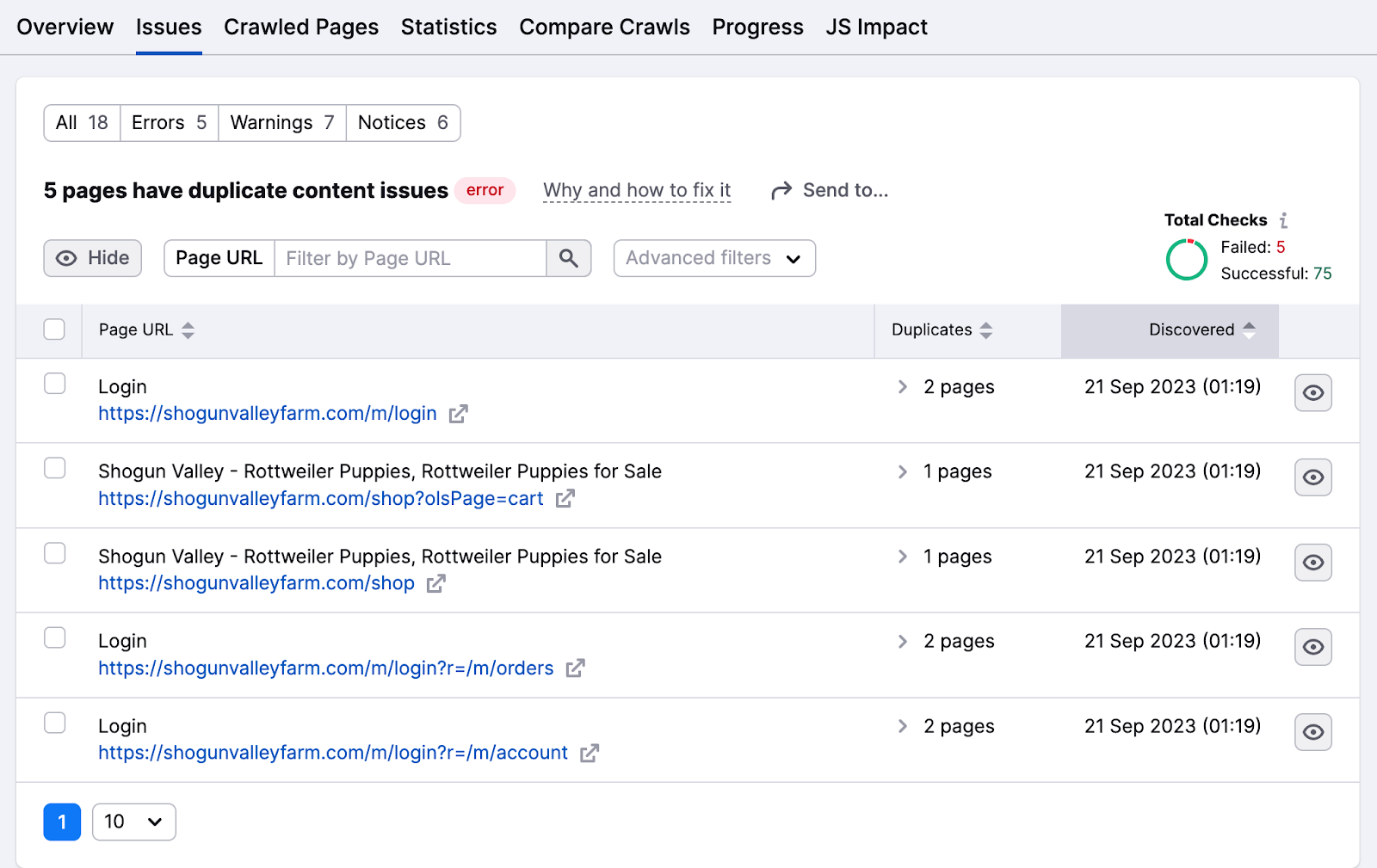

Élimine le contenu en double

Les robots considèrent que les pages web sont dupliquées si le contenu est identique à 85 %. Réduis le contenu en double pour éviter que les robots ne s'embrouillent et n'explorent la même page plusieurs fois, ce qui leur fait perdre du temps et des ressources.

Le contenu dupliqué affecte également l'indexation car les moteurs de recherche peuvent le considérer comme une tactique de manipulation.

L'onglet Problèmes met en évidence tout problème de contenu dupliqué.

Clique sur le numéro de la page pour consulter la liste des pages présentant ces problèmes.

Voici quelques moyens de résoudre les problèmes de contenu dupliqué :

- Rends le contenu unique en l'organisant en groupe de sujets ou en lui attribuant un mot-clé de focalisation.

- Ajoute la balise canonique "rel=canonical" dans le code HTML de l'une de ces pages pour indiquer à Google quelle page tu veux voir apparaître dans les résultats de recherche.

- Ajoute une redirection 301 de la page dupliquée vers la page originale (ce n'est pas la meilleure idée pour réduire les redirections).

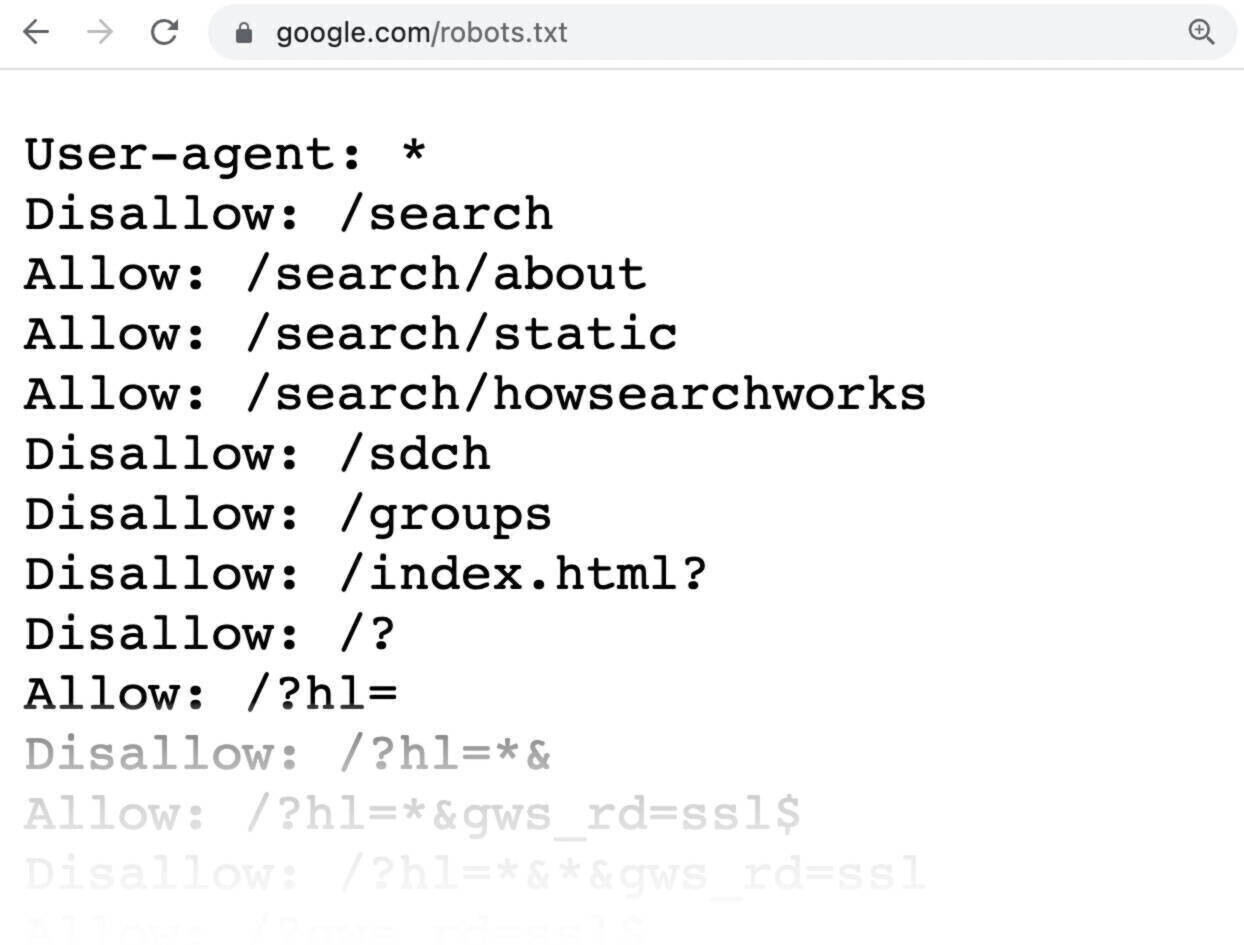

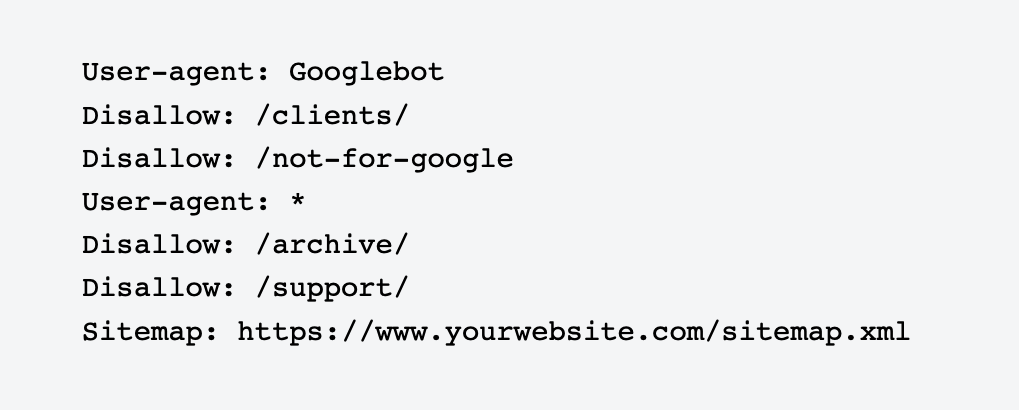

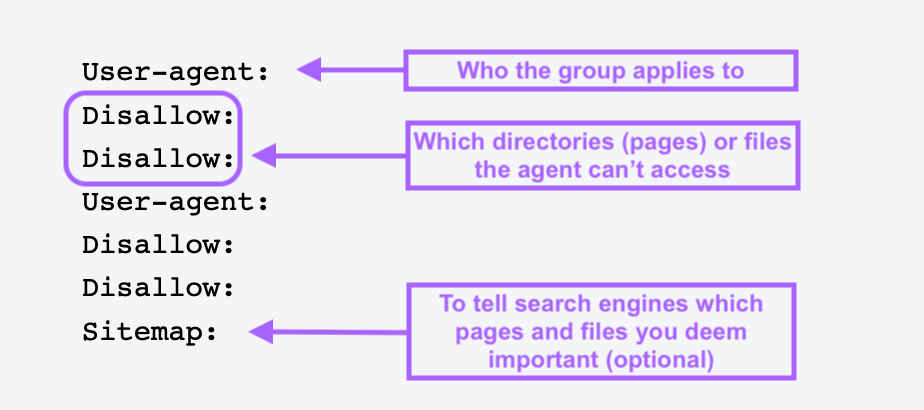

Utilise Robots.txt

Un fichier robots.txt est un fichier texte que tu places dans le répertoire racine de ton site Web pour indiquer aux robots des moteurs de recherche les pages ou les sections du site qu'ils ne doivent pas explorer ou indexer.

Les fichiers Robots.txt t'aident à bloquer les pages sans importance ou privées comme les pages de connexion. Tu ne veux pas que les robots indexent ces pages et gaspillent leurs ressources, il est donc préférable de dire aux robots ce qu'ils doivent faire.

Voici à quoi ressemble un simple fichier robots.txt :

Toutes les pages après Disallow spécifie les pages que tu ne veux pas voir indexées.

Pour créer un fichier robots.txt, utilise un outil de génération de robots.txt. Tu peux aussi en fabriquer un toi-même.

Ouvre d'abord un document .txt avec n'importe quel éditeur de texte ou navigateur web et nomme le document robots.txt.

Ajoute ensuite des directives, qui sont de multiples lignes d'instructions.

Lorsque tu as un fichier robots.txt, enregistre-le et télécharge-le sur ton site. Le processus de téléchargement dépend de ton hébergement et de la structure des fichiers du site.

Rapproche-toi de ton fournisseur d'hébergement ou cherche en ligne de l'aide sur la façon de procéder. Par exemple, recherche "upload robots.txt file to Shopify" pour obtenir des instructions spécifiques.

Éviter les pages orphelines

Les pages orphelines n'ont aucun lien interne ou externe pointant vers elles. Ces pages peuvent être difficiles à trouver pour les robots d'indexation, il est donc important de créer des liens vers elles à partir d'autres parties de ton site Web.

Une fois que tu as trouvé la liste, crée un lien vers ces pages à partir d'autres domaines à forte autorité sur ton site Internet.

Tu peux aussi lier des articles de blog, des pages de produits et des pages d'atterrissage de catégories connexes pour que les robots d'indexation les trouvent plus facilement.

Maximise ton budget Crawl avec Semrush

Alors que Google peut généralement crawler facilement les petits sites, les sites Web plus importants et plus complexes doivent adopter une approche proactive pour gérer leurs performances de recherche.

Cela signifie qu'il faut surveiller et optimiser régulièrement divers aspects techniques d'un site pour s'assurer qu'il reste accessible, bien structuré et très visible.

Quelle que soit la taille de ton entreprise, utilise l'outil d'audit de site de Semrush pour jauger la santé du site Web, optimiser la crawlabilité et corriger les erreurs avant qu'elles ne causent des dommages. De cette façon, ton site restera un acteur fort dans les SERP.