Cet article, paru en anglais sur le Search Engine Journal (ainsi que les conversations complètes sur mon podcast « With Jason Barnard… » et sur la chaîne YouTube de Kalicube.pro) est le quatrième d’une série de cinq articles consacrés au fonctionnement de l‘algorithme de Bing, et basés sur une série d‘entretiens menés tout autour du monde !

Voici un résumé de mon interview avec Meenaz Merchant, premier gestionnaire de programme, Intelligence Artificielle et Recherche, chez Bing. Mais il le formule plus simplement : responsable de l’équipe des algorithmes multimédia.

La première chose que j’ai apprise, c’est que c’est la même équipe qui construit les algorithmes pour les images et pour les vidéos. Il devient donc un peu plus simple de savoir comment aborder chaque algorithme. Ils vont tous deux avoir une approche similaire et vont aborder les signaux qui influencent le classement à peu près de la même manière.

Cette même équipe gère également l’algorithme de la recherche image inversée (ils appelle cela “la recherche caméra”). Malheureusement, nous n’avons pas eu le temps d’en parler !

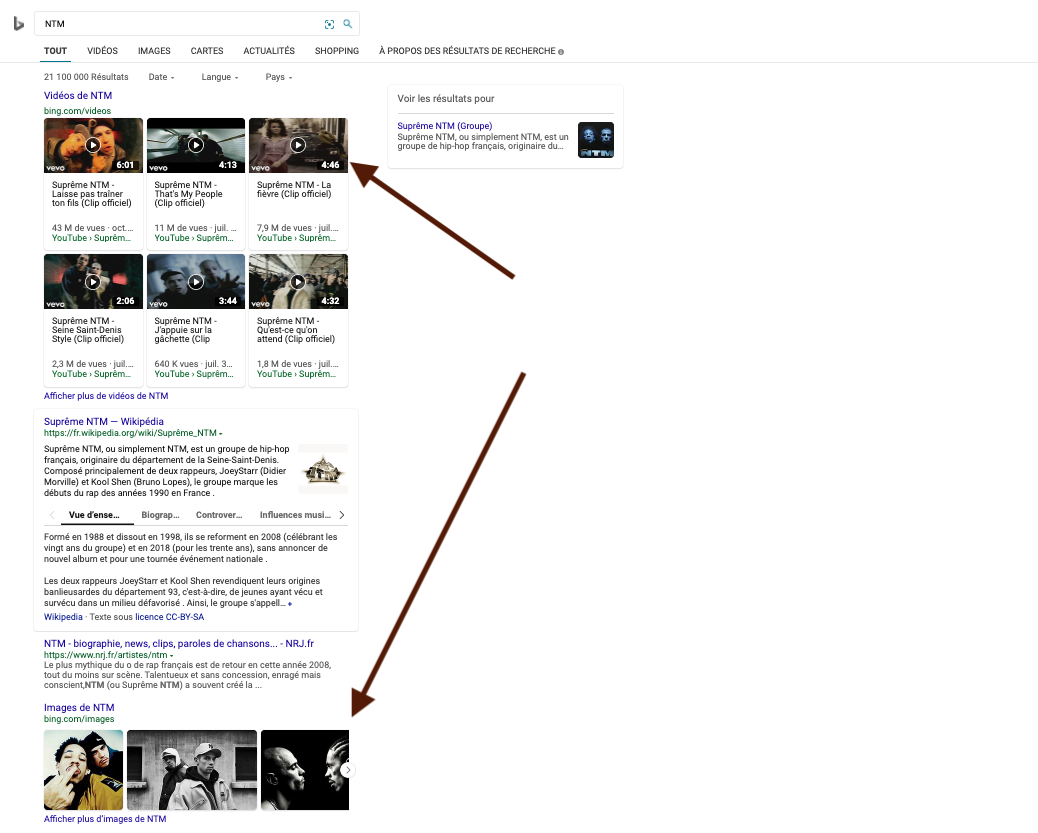

Qu’est-ce qui déclenche les blocs Vidéos & Images ?

L’intention.

Évidemment avec une intention très explicite comme « images de... » ou « vidéos de... », et même une intention explicite un peu plus ambiguë, comme « Montrez-moi un... ».

Mais, moins évidente est une intention implicite, là où l’utilisateur veut et attend probablement des images ou des vidéos sur la SERP : par exemple, pour les stars de cinéma ou de la musique.

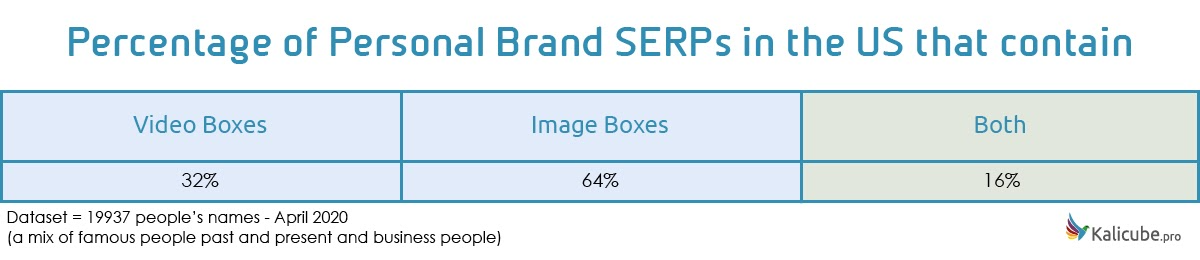

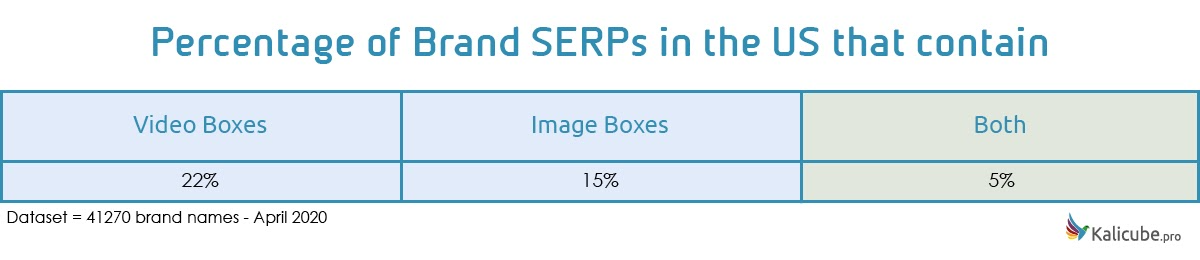

Les deux blocs apparaissent-ils régulièrement côte à côte sur les SERP ?

Meenaz Merchant mentionne environ 10% de chevauchement où les vidéos et les images sont toutes les deux pertinentes et utiles pour satisfaire l’intention de l’utilisateur.

À partir de vérifications ponctuelles sur des SERP de marque que j’ai recueillies sur Kalicube.pro, il m’avait semblait qu’il y avait une tendance forte “soi l’un, soit l’autre”.

Mais, suite à l'insistance de Meenaz Merchant sur ce point, une analyse approfondi m’a démontré que mon supposition n’était pas bien fondé. Un bon tiers des marques qui ont des images sur leur SERP ont aussi des vidéos, et un bon quart ayant des vidéos ont aussi des images. Ce sont des stats des SERP Google pour les USA, pas de Bing et pas pour la France, mais elles illustrent tout de même bien le redoublement dont il parle.

Le taux de clics affecte la position où apparaissent ces éléments riches

Meenaz Merchant est très clair sur ce point : au cours du temps, un taux de clics plus élevé sur l’un des éléments le fera monter sur la SERP. En regardant à nouveau l’exemple de Beyoncé, le fait que les vidéos soient positionnées au-dessus des images prend encore plus de sens.

Dans le cinquième épisode de cette série, Nathan Chalmers, de l’équipe de la page entière (Whole Page Team), affirme aussi que le comportement de l’utilisateur sur les SERP affecte la position des éléments riches. Il indique aussi qu’ils agrègent des données et utilisent l’apprentissage automatique plutôt que d’appliquer les données de clics sur la base d’une requête ou même d’une intention.

C’est une analyse que je dois absolument effectuer sur les données des SERP de marque. Non pas seulement quels éléments riches sont présents pour les marques et les personnes, mais aussi quels sont ceux qui sont en hausse dans les classements, c’est-à-dire plus populaires parmi ceux qui effectuent des recherches.

Quels facteurs aident les images à se classer ?

La pertinence est le facteur principal, selon Meenaz Merchant qui affirme que “la pertinence — être la bonne image pour la requête — éclipse tout le reste.”

Ils cherchent a afficher de la diversité, mais ne sont pas prêts à diluer la qualité des résultats pour s’étendre à de multiples sources. Ainsi, si une source donne plusieures images qui sont jugées pertinentes, elles se classeront toutes.

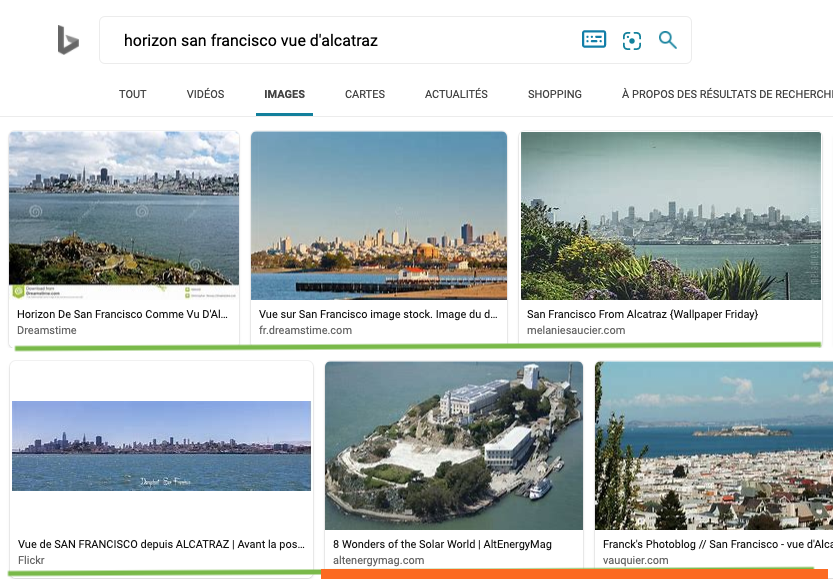

Meenaz Merchant utilise l’exemple d’une requête pour « San Francisco city from Alcatraz Island » [la ville de San Francisco vue de l’île d’Alcatraz], qui est très spécifique. S’ils ont une image qui montre cette vue, ce sera la plus pertinente.

Tous les efforts d'optimisation du monde sur une image ne la feront remonter si l’algorithme ne la considère pertinente à la demande. Dans notre exemple, une photo qui a l’air d’être la même, mais qui est en réalité prise d’un autre point de vue — une image de la ville prise du Golden Gate, par exemple — n’est pas pertinente : l’algorithme tentera de le comprendre et d’exclure ce résultat.

L’évaluation de la pertinence dépend de la compréhension de ce qu’il y a dans l’image. Ils utilisent les signaux « traditionnels » :

-

Balise alt

-

Balise title

-

Nom de fichier

-

Légende

-

Le contenu texte autour de l’image

Mais il se trouve que le signal le plus fort pour la pertinence est la compréhension de ce que montre vraiment l’image grâce à une analyse faisant appel à l’apprentissage automatique.

Des progrès dans l’apprentissage automatique

Comme Fabrice Canel le signale dans l’épisode 2 de cette série, les progrès que fait Microsoft (et Google) dans l’usage du deep learning sont exponentiels, et leurs algorithmes s’améliorent à un rythme incroyable.

Selon Merchant, pour les images en particulier, les trois dernières années représentent un véritable décollage. La capacité de Bing à comprendre le contenu autour d’une image pour saisir le contexte s’est améliorée, mais aussi sa capacité à analyser l’image en elle-même et à comprendre son contenu.

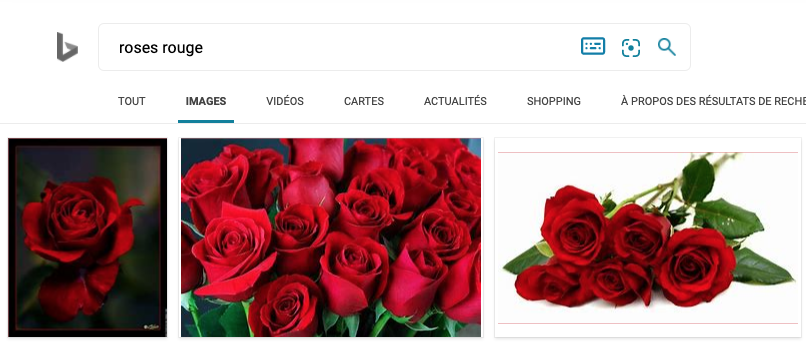

Pour mettre en place un système d'apprentissage automatique pour analyser et comprendre le contenu d’une image, ils ont commencé avec un ensemble de choses facilement identifiables pour lesquelles ils avaient une grande quantité de données fiables (des images correctement étiquetées). Les visages connus, les sites, les animaux, les fleurs… Tom Hanks, la tour Eiffel, les bergers allemands, les roses ont dû faire partie il y a trois ans de cet ensemble conçu pour l’apprentissage.

Ils ont progressivement étendu cela à des ensembles d’images moins bien étiquetées et ils ont incorporé l’identification d’éléments spécifiques dans les images... À tel point qu’ils peuvent être aujourd’hui très subtils.

Reprenons ainsi notre exemple utilisé par Meenaz Merchant : la machine peut maintenant comprendre que l’image d’une ligne d’horizon est une ville. Mais elle peut aller plus loin : quelle ville en particulier ? (ici : San Francisco). Et encore plus loin : que l’image est prise d’un certain point de vue (ex. : la ligne d’horizon de San Francisco prise de l’île d’Alcatraz).

Ce résultat montre à quel point cette analyse est fiable. Pas a 100%... mais bien mieux qu’il y a 3 ans !

En tant qu’utilisateurs, nous utilisons ces capacités, et nous commençons à les considérer comme acquises, “normales”, et pourtant, en tant que spécialistes marketing, nous avons tendance à tenter de tricher en oubliant à quel point ces machines deviennent intelligentes.

Et maintenant, poussons ce point un cran plus loin : cette capacité d’analyser avec exactitude le contenu d’une image augmente exponentiellement. Ce qui veut dire qu’ils s’appuient progressivement de moins en moins sur les signaux traditionnels. Par exemple, les balises alt ne sont plus l’indicateur qu’elles étaient, et même le contenu textuel autour de l’image peut devenir relativement superflu si la machine est sûre d’avoir correctement identifié ce que l’image montre.

Ils analysent absolument chaque image

J’avais toujours supposé que le traitement des images par leurs algorithmes avait un coût financier, et donc que pour une question d’argent, ils ne pouvaient pas analyser chaque image récoltée.

Faux !

Merchant dit qu’ils analysent absolument chaque image et identifient ce qu’elle montre. Ce qui veut dire que les indices qu’ils voient dans le nom de fichier, les balises alt, les titres, les légendes, et même le contenu autour de l’image ne servent qu’à corroborer ou clarifier ce que la machine a compris.

Il n’y a donc plus aucun sens à tricher sur ces aspects. Bing va repérer la tricherie et l'ignorer. Mais il y a pire : la confiance. En prenant les balises alt comme exemple, Merchant assure que l’algorithme identifiera rapidement quels sites sont fiables et appliquera un paramètre de confiance historique sur le classement des images provenant de ces site.

Cela semble confirmer les expériences que j’ai eues en soumettant des pages de mes sites à Bing et Google. Pour certaines sites que j’ai testé, les images ont été indexées très très rapidement (quelques secondes). Pour d’autres sites, cela a pris des minutes, des heures, et même des jours.

La confiance construite historiquement serait, donc, un facteur essentiel pour la rapidité de l’indexation. Et Merchant suggère que construire une bonne (ou mauvaise) réputation sur la durée s’applique également à l’autorité. Ils examinent beaucoup de signaux pour évaluer l’autorité.

Dans ses propos, pour différencier des images avec une pertinence semblable, Merchant focalise sur la qualité de l’image, les liens entrants, et les clics à partir des SERP.

Ce qui illustre bien à quel point le E-A-T est important. Ils regardent en effet ces trois points :

-

l’Expertise (un contenu de qualité)

-

l’Autorité (soutien des pairs via des liens et “honnêté”)

-

Le Trust / la Confiance (l’appréciation de l’audience via l’interaction sur les SERP)

C’est logique.

L’autorité, comme la confiance, sont réévaluées pour chaque recherche. L’algorithme modifie constamment, à un niveau microscopique, sa perception des sites web les plus fiables / ayant le plus d’autorité. Rester honnête dans le temps est donc crucial pour votre succès futur !

Les blocs Images sur la page de résultats (SERP) principale sont simplement les meilleurs résultats de la verticale des images.

Merchant parle de la verticale des images et précise qu’ils peuvent générer autant de résultats que les liens bleus de base. Il y’a, donc beaucoup de concurrence.

Arriver en haut des résultats des images vous donne non seulement de la visibilité dans les résultats dédiés images :

Mais également sur les SERP principales. Pour être vu sur les SERP de liens bleus, vous devez tout simplement vous classer parmi les premiers dans le classement images pour une requête qui montre des blocs Images sur la SERP principale.

Si la requête est très centrée sur les images, se classer dans le top 12 sera suffisant, car le bloc Images est plus grand.

Quels facteurs aident les vidéos à se classer ?

Les signaux sont similaires à ceux des images. Avant tout, la pertinence... mais ensuite aussi la popularité, l’autorité, la confiance, qualité. Et selon les dires de Merchant, je comprends que c’est dans cet ordre.

Qu’est-ce qui déclenche un bloc Vidéos sur une SERP principale ?

Comme avec les images, l’apparition de blocs Vidéos sur la SERP principale dépend de leur pertinence par rapport à l’intention explicite ou implicite de la requête. Merchant cite deux exemples d’intention implicite qui déclenchent la vidéo : les news et le divertissement.

Y a-t-il un biais de site web / plateforme ?

La plateforme en soit ne donne pas d’avantage en termes de classement. Ce qui joue le plus reste que la vidéo soit pertinente (encore cet adjectif !), de qualité … et qu'elle reçoive l’approbation de l'audience via leurs interactions avec la vidéo.

Il est, donc, possible d'être bien classé que la plateforme soit YouTube, Twitter, Facebook, Vimeo…

Mais pensez également au type de requête et à votre verticale : différentes plateformes dominent différentes verticales. Ainsi, YouTube domine les vidéos instructives “How-To”, mais les news tendent à favoriser la BBC, TF1 ou d’autres sites de news.

Et ni les sites news, ni YouTube ne possède un avantage particulier dans les domaines de niches. Pour une requête sur une verticale ou un secteur de niche, les grandes plateformes comme YouTube ou la BBC sont peu avantagées.

L’autorité dans un marché ou sur un sujet niche peut jouer un grand rôle. Un petit site spécialisé sera vu par Bing comme une source parfaite pour une vidéo répondant à une requête de recherche très spécifique.

Le trio gagnant:

-

l’Expertise (un contenu de qualité)

-

l’Autorité (le soutien des pairs via des liens et “honnêteté”)

-

Le Trust / la Confiance (l’appréciation de l’audience via l’interaction sur les SERP)

Plus j’avance dans l’écriture de ces interviews de la série de Bing, plus le E-A-T ressort, et plus je suis convaincu que le E-A-T est une bonne façon d’envisager la création et la présentation de contenus pour qu’ils soient bien classés !

Regardez la vidéo de l’interview sur laquelle cet article est basé.

Voilà pour le quatrième de ces cinq articles consacrés au fonctionnement de l'algorithme de Bing (et par extension, de tout moteur de recherche, y inclus Google).

La série est basée sur des entretiens menés par Jason Barnard tout autour du monde !

Restez attentifs, nous publierons régulièrement un nouvel épisode des BING Séries, les aventures de notre globe-trotter du SEO !

Avec Frédéric Dubut, Senior Program Manager Lead / Bing

Avec Fabrice Canel, Principal Program Manager / Bing

Avec Ali Alvi, Principal Program Manager - Intelligence Artificielle / Bing

Avec Meenaz Merchant, Principal Program Manager Lead - Intelligence artificielle et recherche / Bing

-

Épisode 5 : Comment fonctionne l’algorithme pleine page de Bing ?

Avec Nathan Chalmers, Program Manager - Search Relevance Team / Bing