Se battre pour suivre les mises à jour permanentes et éviter les problèmes techniques sur son site fait partie de la vie quotidienne des webmasters.

Même si vous êtes déjà conscient d'un certain nombre de problèmes liés à votre site web, il peut être difficile de le maintenir en bonne santé dans le monde en constante évolution du SEO.

Toutefois, en maîtrisant les erreurs SEO les plus courantes (et potentiellement nuisibles), vous vous donnez toutes les chances de réduire au minimum les problèmes techniques et de maximiser les performances de votre site web. Connaître certaines des bonnes pratiques SEO peut également s'avérer très utile.

Ce guide vous propose une checklist complète d'audit de site qui vous aidera à réaliser cette tâche en tant que webmaster, quelle que soit la taille de votre site.

Comment Nous Avons Recueilli les Données

Nous avons analysé 250 000 sites web de diverses niches, dont la santé, les voyages, les sports et les sciences, à l'aide de l'outil Audit de site de Semrush afin de trouver les erreurs SEO les plus courantes qui les empêchent d'atteindre leurs objectifs.

Au total, nous avons analysé :

-

310 161 067 pages web

-

28 561 137 301 liens

-

6 910 489 415 images

Cette analyse approfondie nous a permis de créer un modèle d'audit de site complet que les webmasters peuvent utiliser pour éviter les erreurs.

La Création d'un Modèle d'Audit de Site Fondé sur la Recherche

Il est indéniable qu'un audit de site bien mené est une tâche qui prend du temps.

Notre étude a révélé 27 erreurs SEO courantes qui ne peuvent évidemment pas être traitées en une seule fois, c'est pourquoi nous avons divisé la liste en morceaux digestes à utiliser comme modèle d'action.

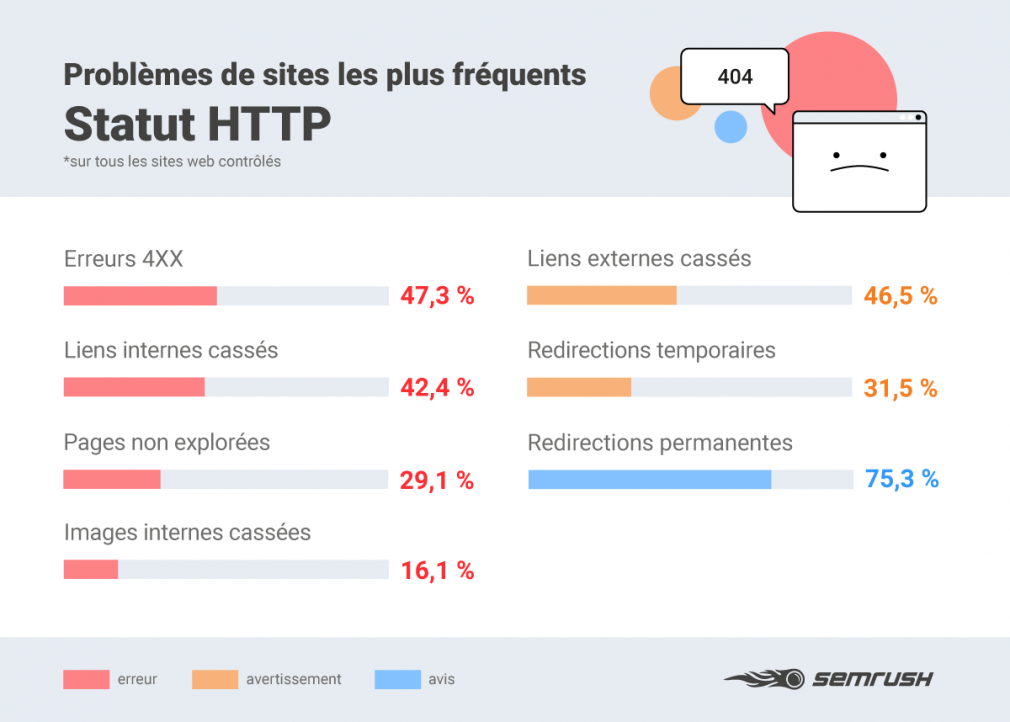

Ignorer le Statut HTTP et les Problèmes de Serveur

Les problèmes techniques les plus graves d'un site web sont souvent liés à son statut HTTP.

Il s'agit notamment de codes d'état tels que Error 404 (Page non trouvée), qui indiquent la réponse du serveur à une requête d'un client, comme un navigateur ou un moteur de recherche.

Lorsque le dialogue entre un client et un serveur - ou, en termes plus simples, entre un utilisateur et votre site web - s'interrompt et se brise, la confiance que l'utilisateur a dans le site s'en ressent.

De graves problèmes de serveur peuvent non seulement entraîner une perte de trafic en raison de l'inaccessibilité du contenu, mais aussi nuire à vos classements à long terme si Google n'est pas en mesure de trouver sur votre site des résultats convenant à l'internaute qui effectue une recherche.

Erreurs Affectant votre Statut HTTP :

1. Erreurs 4xx

Les codes 4xx signifient qu'une page est cassée et ne peut être atteinte. Ils peuvent également s'appliquer à des pages fonctionnelles lorsque quelque chose les empêche d'être explorées.

2. Pages non explorées

Cela se produit lorsqu'une page ne peut être atteinte pour l'une des deux raisons suivantes :

1) le temps de réponse de votre site web est supérieur à cinq secondes ; ou

2) votre serveur a refusé l'accès à la page.

3. Liens internes rompus

Il s'agit de liens qui conduisent les utilisateurs vers des pages qui ne fonctionnent pas, ce qui peut nuire à l'expérience utilisateur et au SEO.

4. Liens externes rompus

Ces liens conduisent les utilisateurs vers des pages qui n'existent pas sur un autre site, ce qui envoie des signaux négatifs aux moteurs de recherche.

5. Images internes rompues

Cette erreur est signalée lorsqu'un fichier image n'existe plus ou que son URL est mal écrite.

Les Autres Erreurs de Statut HTTP les plus Courantes :

- Redirections permanentes

- Redirections temporaires

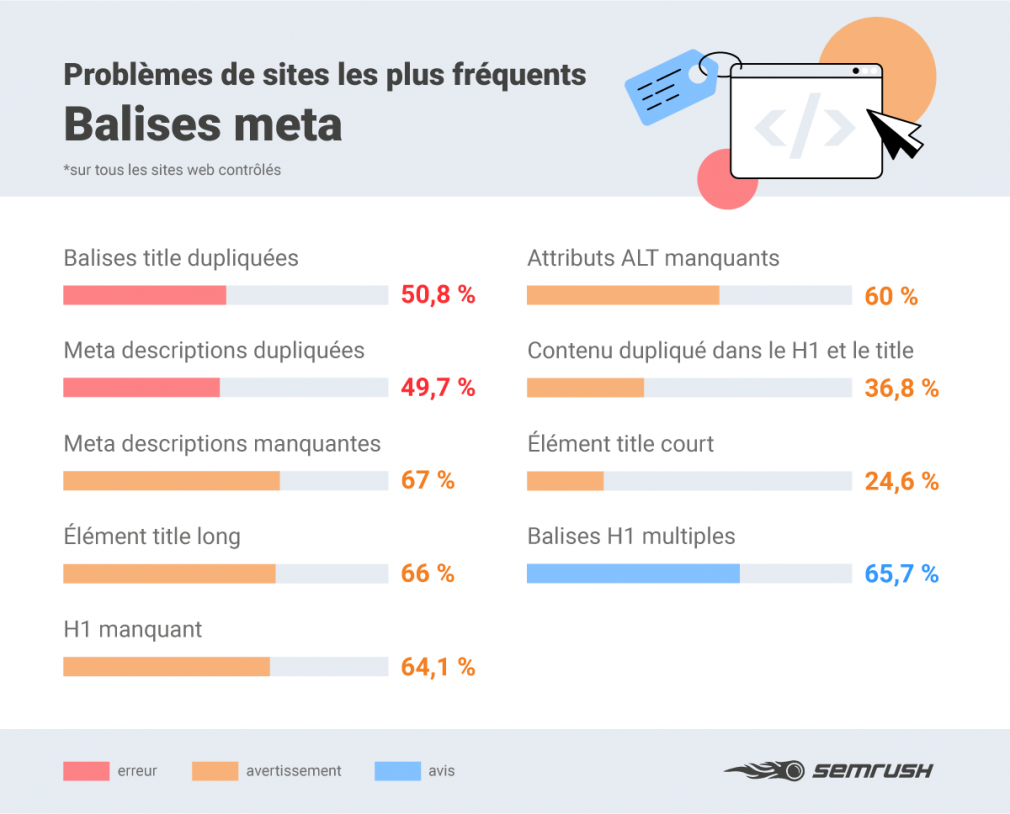

Balises Meta Sous-Optimisées

Vos balises meta aident les moteurs de recherche à identifier le sujet de vos pages afin de les relier aux mots clés et expressions utilisés par les internautes.

Créer les bonnes balises title signifie choisir les mots clés pertinents pour former un lien unique sur lequel les utilisateurs auront envie de cliquer dans les pages de résultats des moteurs de recherche (SERP).

Les meta descriptions vous offrent d'autres possibilités d'inclure des mots clés et des expressions associées.

Elles doivent être aussi uniques et adaptées que possible : si vous ne créez pas les vôtres, Google les générera automatiquement sur la base des mots clés contenus dans les requêtes des utilisateurs, ce qui peut parfois entraîner une inadéquation entre les termes de recherche et les résultats qui y sont associés.

Les balises title et les meta descriptions optimisées doivent inclure les mots clés les plus appropriés, être de la bonne longueur et éviter autant que possible les doublons.

Certains secteurs, comme l'e-commerce de mode, ne sont pas en mesure de créer des descriptions uniques pour chaque produit, et doivent donc offrir une valeur unique dans d'autres parties du corps du texte de leurs pages de destination.

Si vous pouvez créer des métadonnées uniques, vous devriez vous engager dans cette voie pour donner à votre site les meilleures chances de maximiser son impact dans les SERP.

Les Erreurs de Balises Meta les Plus Communes qui Peuvent Nuire à vos Classements :

6. Balises title et meta descriptions dupliquées

Si deux pages ou plus ont les mêmes titles et meta descriptions, il est difficile pour les moteurs de recherche de bien déterminer la pertinence et, par conséquent, le classement des pages.

7. Balises H1 manquantes

Les balises H1 aident les moteurs de recherche à déterminer le sujet de votre contenu. Si elles sont manquantes, Google aura du mal à comprendre votre site web.

8. Meta descriptions manquantes

Des meta descriptions bien rédigées aident Google à comprendre la pertinence de votre site et encouragent les utilisateurs à cliquer sur votre résultat. Si elles sont absentes, le taux de clics risque de chuter.

9. Attributs ALT manquants

Les attributs ALT fournissent aux moteurs de recherche et aux personnes malvoyantes des descriptions des images figurant dans votre contenu. Sans eux, la pertinence se perd et l'engagement peut s'en ressentir.

10. Balises H1 et balises title manquantes

Lorsqu'une page présente une balise H1 et une balise title identiques, elle peut sembler sur-optimisée et risque de rater des opportunités de classement pour d'autres mots clés pertinents.

Autres Erreurs Communes de Balises Meta :

- Éléments du title courts / longs

- Balises H1 multiples

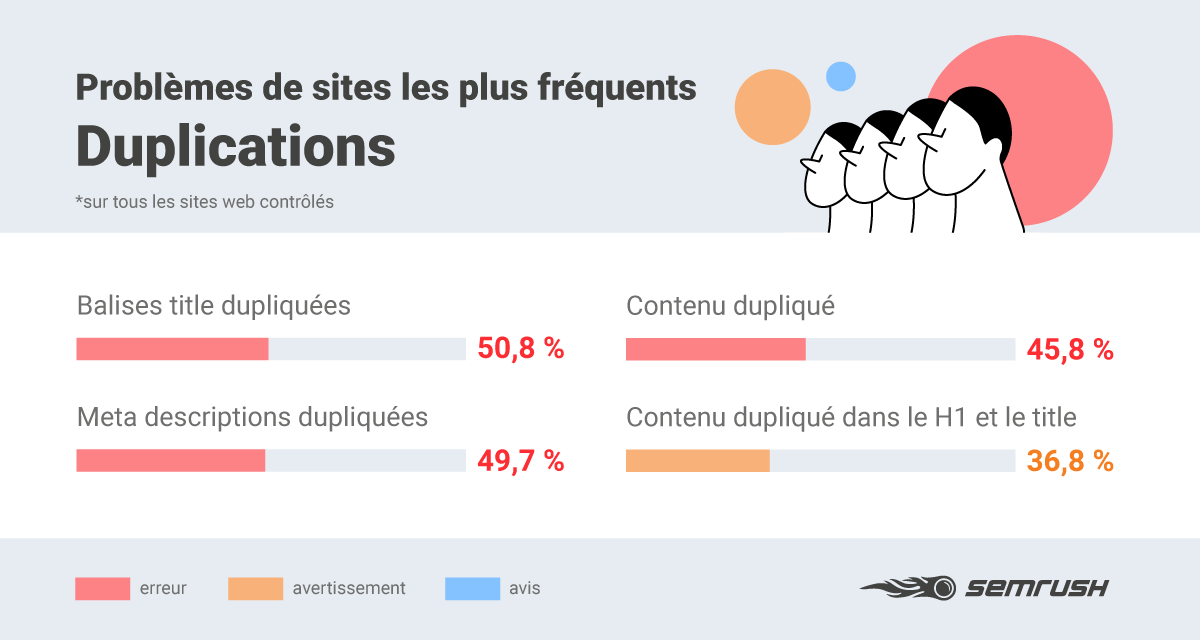

Créer du Contenu Dupliqué

Le contenu dupliqué est susceptible de nuire à vos classements, et pendant longtemps.

Vous devez éviter de dupliquer du contenu, quel qu'il soit, quel que soit le site d'où il provient, qu'il s'agisse d'un concurrent direct ou non.

Faites attention aux descriptions, paragraphes et sections entières dupliqués, aux balises H1 dupliquées sur plusieurs pages et aux problèmes d'URL, tels que les versions www et non www d'une même page.

Veillez à ce que chaque détail soit unique afin de vous assurer qu'une page puisse non seulement être classée par Google, mais aussi attirer les clics des utilisateurs.

Les Problèmes de Duplication les plus Courants qui Pénalisent les Sites :

11. Contenu dupliqué

L'outil Audit de site signale la présence de contenu dupliqué lorsque des pages de votre site web ont la même URL ou le même texte, par exemple. Ce problème peut être résolu en ajoutant un lien rel="canonical" à l'une des pages dupliquées ou en utilisant une redirection 301.

Autres Erreurs Courantes de Duplication :

- Balises H1 et balises title dupliquées

- Meta descriptions dupliquées

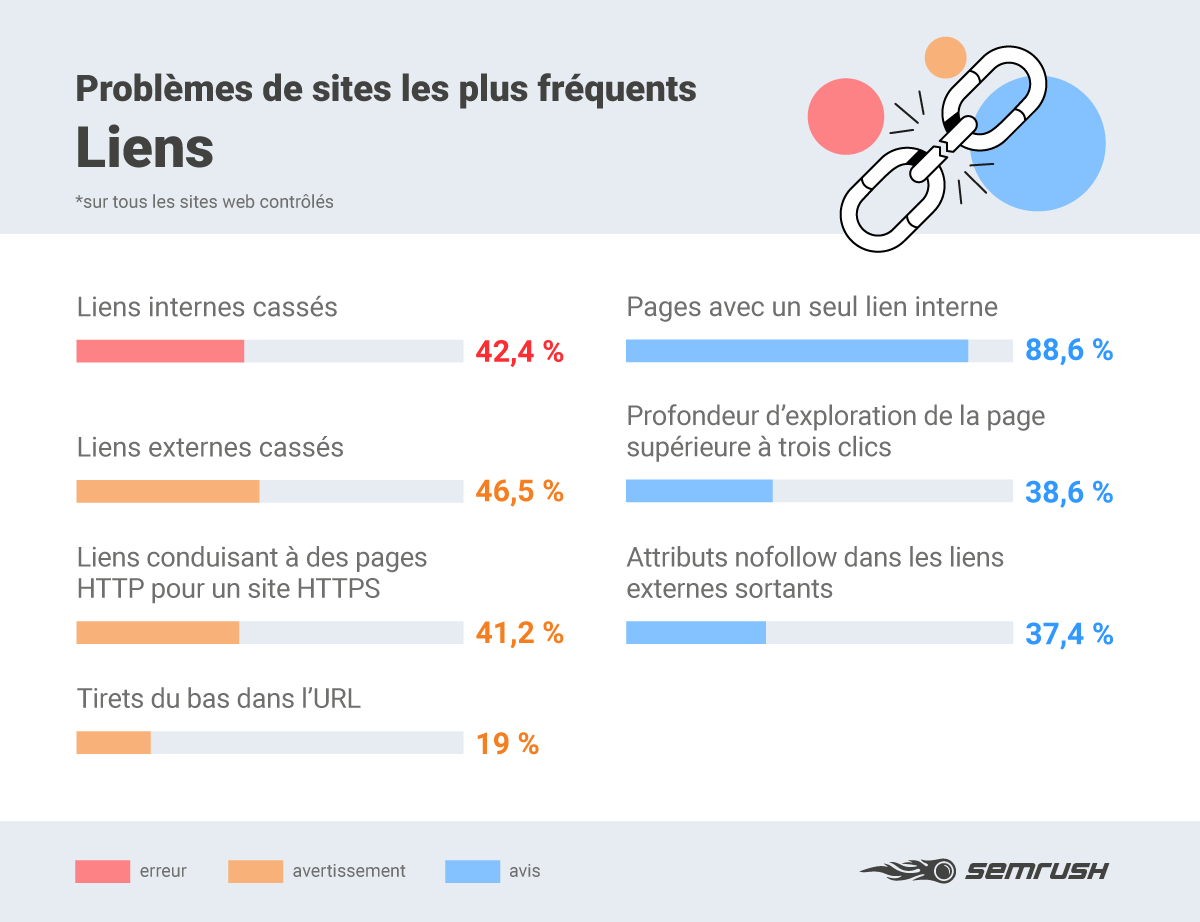

Négliger l'Optimisation des Liens Internes et Externes

Les liens qui font entrer et sortir vos visiteurs de votre parcours client peuvent nuire à l'expérience globale de l'utilisateur et, par conséquent, à vos performances dans les moteurs de recherche. Google ne classe tout simplement pas les sites qui offrent une mauvaise expérience utilisateur.

Cette étude a révélé que près de la moitié des sites que nous avons analysés à l'aide de l'outil Audit de site présentaient des problèmes au niveau des liens internes et externes, ce qui laisse supposer que leurs architectures de liens ne sont pas optimisées.

Certains des liens contiennent des tirets bas dans l'URL, des attributs nofollow et sont HTTP au lieu de HTTPS, ce qui peut avoir une incidence sur les classements.

Vous trouverez les liens brisés sur votre site à l'aide de l'outil Audit de site ; l'étape suivante consiste à identifier ceux qui ont le plus d'impact sur le niveau d'engagement des utilisateurs et à les corriger par ordre de priorité.

Les Problèmes de Liens les plus Courants qui Peuvent Avoir un Impact sur vos Classements :

12. Liens menant à des pages HTTP sur un site HTTPS

Les liens vers d'anciennes pages HTTP peuvent provoquer un dialogue dangereux entre les utilisateurs et un serveur. Vérifiez donc que tous vos liens sont à jour.

13. URL contenant des tirets bas (underscores)

Les moteurs de recherche peuvent mal interpréter les tirets bas et documenter incorrectement l'index de votre site. Utilisez plutôt des traits d'union.

Autres Erreurs Courantes de Liens :

- Liens internes rompus

- Liens externes rompus

- Attributs nofollow dans les liens externes

- Pages avec un seul lien interne

- Profondeur du crawl des pages de plus de 3 clics

Compliquer la Tâche des Robots d'Exploration

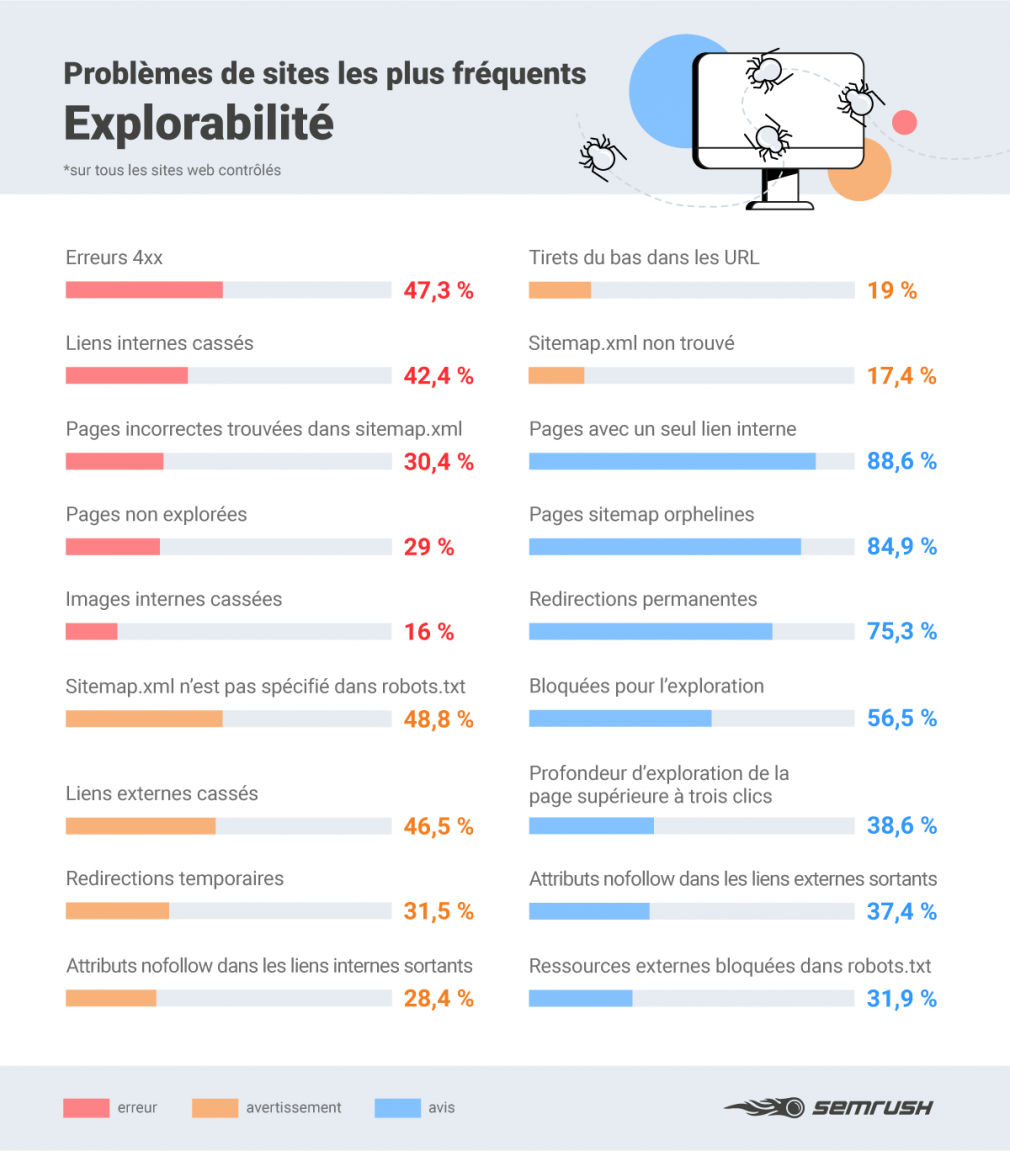

L'explorabilité est, avec les problèmes d'indexation, l'un des indicateurs essentiels de l'état de santé d'un site web.

Il y a du terrain à perdre et à gagner dans les SERP lorsqu'il s'agit de l'explorabilité de votre site.

Si vous ignorez les problèmes de crawl d'un point de vue technique, certaines pages de votre site risquent de ne pas être aussi visibles qu'elles pourraient l'être pour Google.

En revanche, si vous résolvez les problèmes de crawl, Google sera plus à même d'identifier les bons liens pour les bons utilisateurs dans les SERP.

Vous pouvez éviter les problèmes techniques en vérifiant que votre site ne comporte pas d'éléments cassés ou bloqués qui en limitent l'exploration.

Kevin Indig, responsable du SEO et du contenu chez G2dotcom, souligne ici l'importance de la synergie entre les sitemaps et les robots :

Ce qui m'a surpris, c'est que de nombreux sitemaps XML ne sont pas référencés dans robots.txt. Cela me paraît pourtant être la norme. Ce qui n'est pas surprenant, c'est le nombre élevé de sites qui n'ont qu'un seul lien interne vers leurs pages ou même des pages orphelines. Il s'agit là d'un problème classique de structure de site que seuls les spécialistes SEO connaissent.

L'absence d'un fichier sitemap.xml dans votre fichier robots.txt, par exemple, peut entraîner une mauvaise interprétation de l'architecture de votre site par les robots d'exploration des moteurs de recherche, comme l'explique Matt Jones, responsable du SEO et de l'optimisation des taux de conversion chez Rise at Seven :

Comme les fichiers sitemap.xml peuvent aider les robots d'exploration des moteurs de recherche à identifier et à trouver les URL qui existent sur votre site web, leur permettre de les explorer est sans aucun doute un moyen fantastique d'aider les moteurs de recherche à acquérir une compréhension approfondie de votre site web et, en retour, d'obtenir de meilleurs classements pour des termes plus pertinents.

Les Problèmes les plus Courants Rencontrés par les Robots d'Exploration de Sites Web :

14. Attributs Nofollow dans les liens internes sortants

Les liens internes qui contiennent l'attribut nofollow empêchent toute équité de lien potentielle de circuler sur votre site.

15. Pages incorrectes trouvées dans sitemap.xml

Votre sitemap.xml ne doit pas contenir de pages cassées. Vérifiez qu'il n'y a pas de chaînes de redirection ou de pages non canoniques et qu'elles renvoient un code d'état 200.

16. Sitemap.xml introuvable

Les sitemaps manquants compliquent la tâche des moteurs de recherche qui explorent, parcourent et indexent les pages de votre site.

17. Sitemap.xml non spécifié dans robots.txt

Sans un lien vers votre sitemap.xml dans votre fichier robots.txt, les moteurs de recherche ne seront pas en mesure de comprendre intégralement la structure de votre site.

Autres Erreurs Courantes d'Explorabilité :

- Pages non explorées

- Images internes rompues

- Liens internes rompus

- URL contenant des tirets bas

- Erreurs 4xx

- Ressources formatées comme des liens de page

- Ressources externes bloquées dans le fichier robots.txt

- Attributs Nofollow dans les liens externes sortants

- Blocage de l'exploration

- Pages avec un seul lien interne

- Pages sitemap orphelines

- Profondeur d'exploration des pages supérieure à 3 clics

- Redirections temporaires

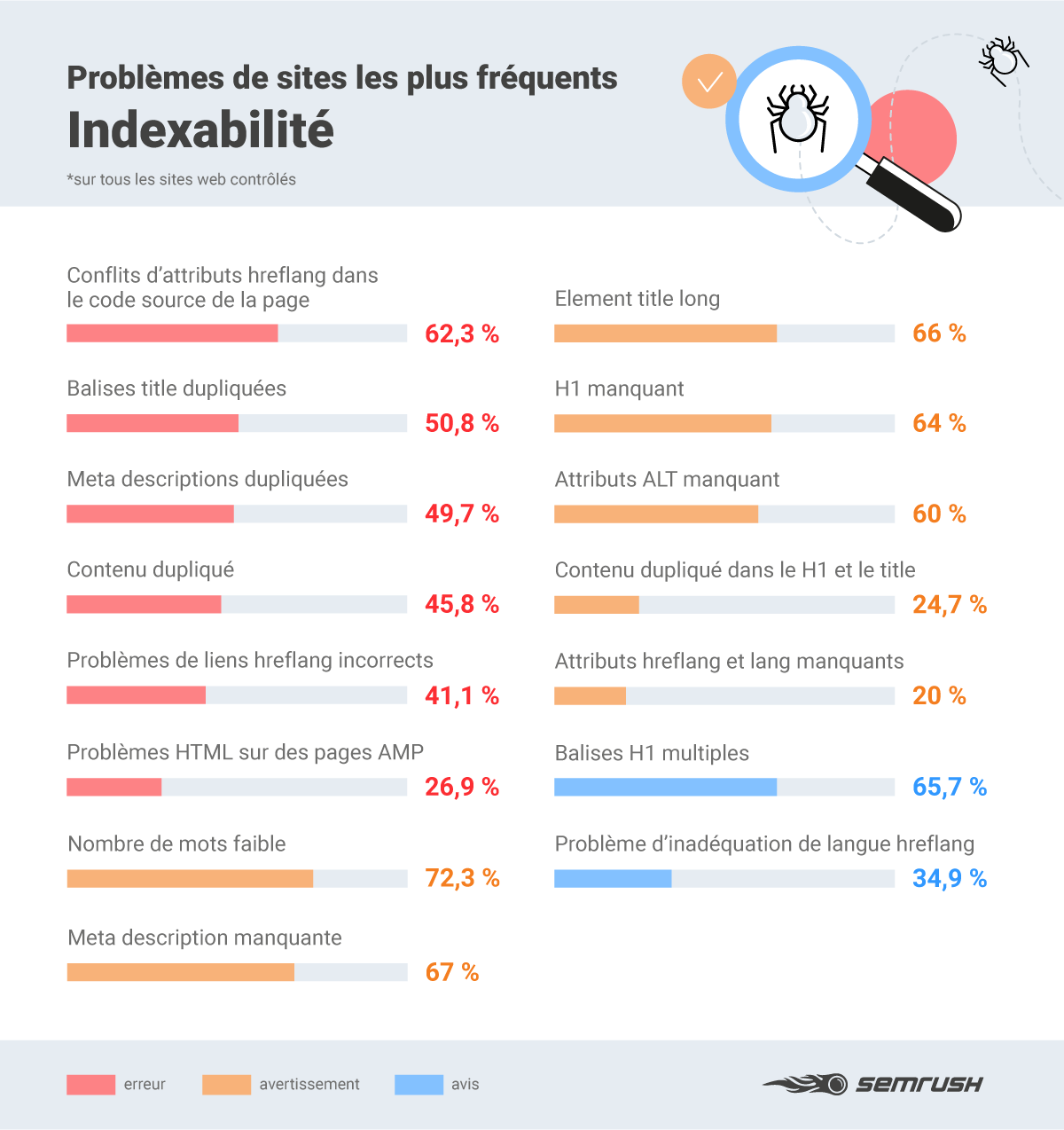

Ignorer l'Indexabilité

De bons indicateurs d'indexabilité sont essentiels pour le SEO. En clair, si une page n'est pas indexée, elle ne sera pas vue par un moteur de recherche, et donc pas non plus par les utilisateurs.

De nombreux facteurs peuvent empêcher l'indexation de votre site web, même si vous semblez n'avoir aucun problème d'explorabilité.

La duplication des métadonnées et du contenu, par exemple, peut empêcher les moteurs de recherche d'identifier les pages à classer pour certains termes de recherche similaires.

Notre étude montre que près de la moitié des sites que nous avons contrôlés souffrent de problèmes d'indexation dus à des balises title, des meta descriptions et du contenu dupliqués.

Cela peut signifier que Google est contraint de prendre des décisions sur les pages à classer, même si les webmasters peuvent anticiper des problèmes de ce type et dire à Google ce qu'il doit faire.

Différents problèmes peuvent affecter l'indexabilité de votre site, qu'il s'agisse d'un faible nombre de mots, de lacunes ou de conflits hreflang pour les sites web multilingues.

Les Problèmes les plus Courants des Sites Web Non Indexables :

18. Balises title courtes / longues

Les balises title de plus de 60 caractères sont coupées dans les SERP, tandis que celles de moins de 60 caractères peuvent être considérées comme des opportunités manquées pour une optimisation plus poussée.

19. Conflits hreflang dans le code source d'une page

Les sites web multilingues peuvent perturber les moteurs de recherche si l'attribut hreflang est en conflit avec le code source d'une page donnée.

20. Problèmes avec des liens hreflang incorrects

Les liens hreflang brisés peuvent créer des problèmes d'indexation si, par exemple, des URL relatives sont utilisées au lieu d'URL absolues : https://votresiteweb/blog/votre-article au lieu de /blog/votre-article.

21. Faible nombre de mots

L'outil Audit de site peut signaler les pages qui semblent manquer de contenu. Il est donc utile de les passer en revue pour s'assurer qu'elles sont aussi complètes et informatives que possible.

22. Attributs hreflang et lang manquants

Ce problème survient lorsqu'une page d'un site multilingue ne comporte pas les liens ou les balises nécessaires pour indiquer aux moteurs de recherche ce qu'il faut servir aux utilisateurs de chaque région. Vous en apprendrez plus sur les erreurs de hreflang ici.

23. Problèmes AMP HTML

Ce problème concerne les utilisateurs mobiles de votre site web et est signalé lorsque le code HTML n'est pas conforme aux normes AMP.

Autres Erreurs Courantes d'Indexabilité :

- Balises H1 dupliquées

- Contenu dupliqué

- Balises title dupliquées

- Meta descriptions dupliquées

- Balises H1 manquantes

- Balises H1 multiples

- Problèmes de non-concordance des langues Hreflang

Oublier les AMP (Accelerated Mobile Pages)

Il est essentiel d'orienter votre SEO on-page de manière à ce que votre site soit adapté au mobile.

En septembre 2020, l'ergonomie mobile est devenue pour Google un critère de classement par défaut aussi bien pour mobile que pour ordinateur.

Cela signifie qu'en tant que webmasters, vous devez vous assurer que le code HTML de votre site est conforme aux Consignes de Google relatives aux pages AMP afin d'éviter des dommages potentiels à vos performances dans les moteurs de recherche.

Vérifiez la présence de pages AMP invalides sur votre site à l'aide de l'outil Audit de site afin de déterminer ce qui doit être corrigé ; il peut s'agir de votre code HTML, de votre style et de votre mise en page ou de vos modèles de page.

Le Problème le plus Courant Lié à la Convivialité Mobile :

Les problèmes AMP HTML peuvent être liés au style ou à la mise en page et, comme mentionné ci-dessus, ils peuvent affecter l'indexabilité d'un site.

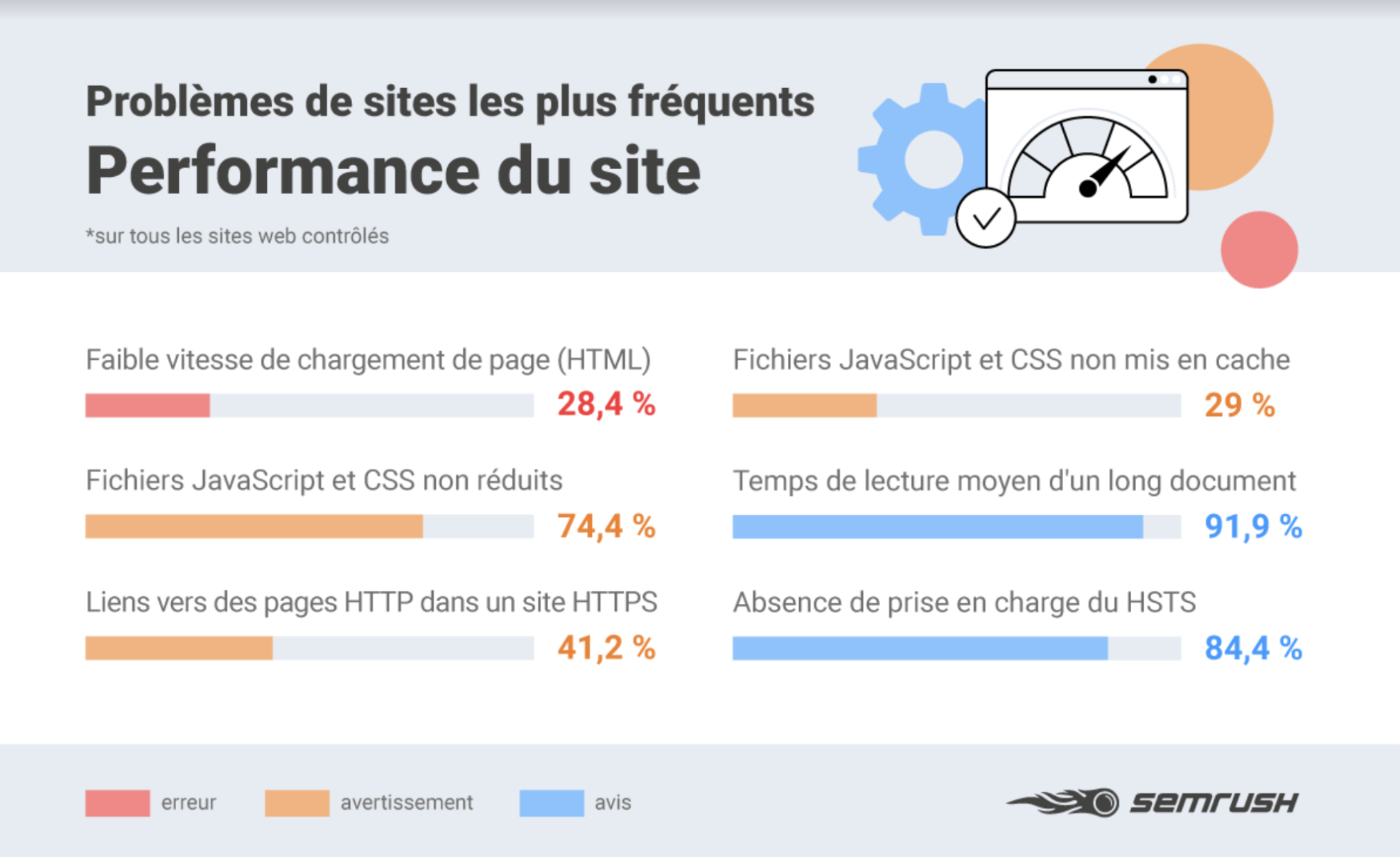

Ne pas Tenir Compte des Performances du Site

Le temps de chargement des pages devient de plus en plus important pour le SEO. Plus votre site est lent, moins il a de chance d'intéresser les utilisateurs qui ont la patience d'attendre son chargement.

Vous pouvez obtenir des suggestions sur la vitesse de chargement des pages pour les mobiles et les ordinateurs directement auprès de Google. Mesurez la vitesse des pages avec PageSpeed Insights et identifiez les améliorations à apporter à votre site pour qu'il soit plus rapide.

Le test de vitesse de Google utilisé conjointement avec l'outil Audit de site de Semrush peut révéler, par exemple, les fichiers JavaScript ou CSS trop compliqués (comme cela a été le cas pour de nombreux sites de notre étude).

Gerry White, responsable du SEO chez Rise at Seven, suggère que la minification du code est un gain rapide en ce qui concerne les performances du site et l'expérience utilisateur :

L'une des choses qui ressortent des données est la quantité de gains rapides qu'il est possible d'obtenir en améliorant la vitesse des pages. Il ne s'agit pas seulement de classement, mais aussi de l'utilisateur et de la conversion - les gains rapides simples qui peuvent généralement être obtenus sans trop d'efforts de développement sont ceux sur lesquels je concentrerais mes efforts sur ce front. Des tâches telles que la compression de JavaScript et de CSS ne prennent que quelques minutes, mais peuvent apporter des améliorations considérables à de nombreux sites web. Il convient également de s'assurer que le protocole HTTPS est activé avec HTTP2.

Les Problèmes les Plus Courants Liés à la Performance des Sites Web :

25. Vitesse de chargement des pages (HTML) lente

Le temps nécessaire pour qu'une page soit entièrement restituée par un navigateur doit être aussi court que possible, car la vitesse a une incidence directe sur vos classements.

26. Fichiers JavaScript et CSS non mis en cache

Ce problème peut être lié à la vitesse de chargement de votre page et se produit si la mise en cache du navigateur n'est pas spécifiée dans l'en-tête de réponse.

27. Fichiers JavaScript et CSS non minifiés

Cette question porte sur la réduction du JavaScript et du CSS. Supprimez les lignes, les commentaires et les espaces blancs inutiles afin d'améliorer la vitesse de chargement des pages.

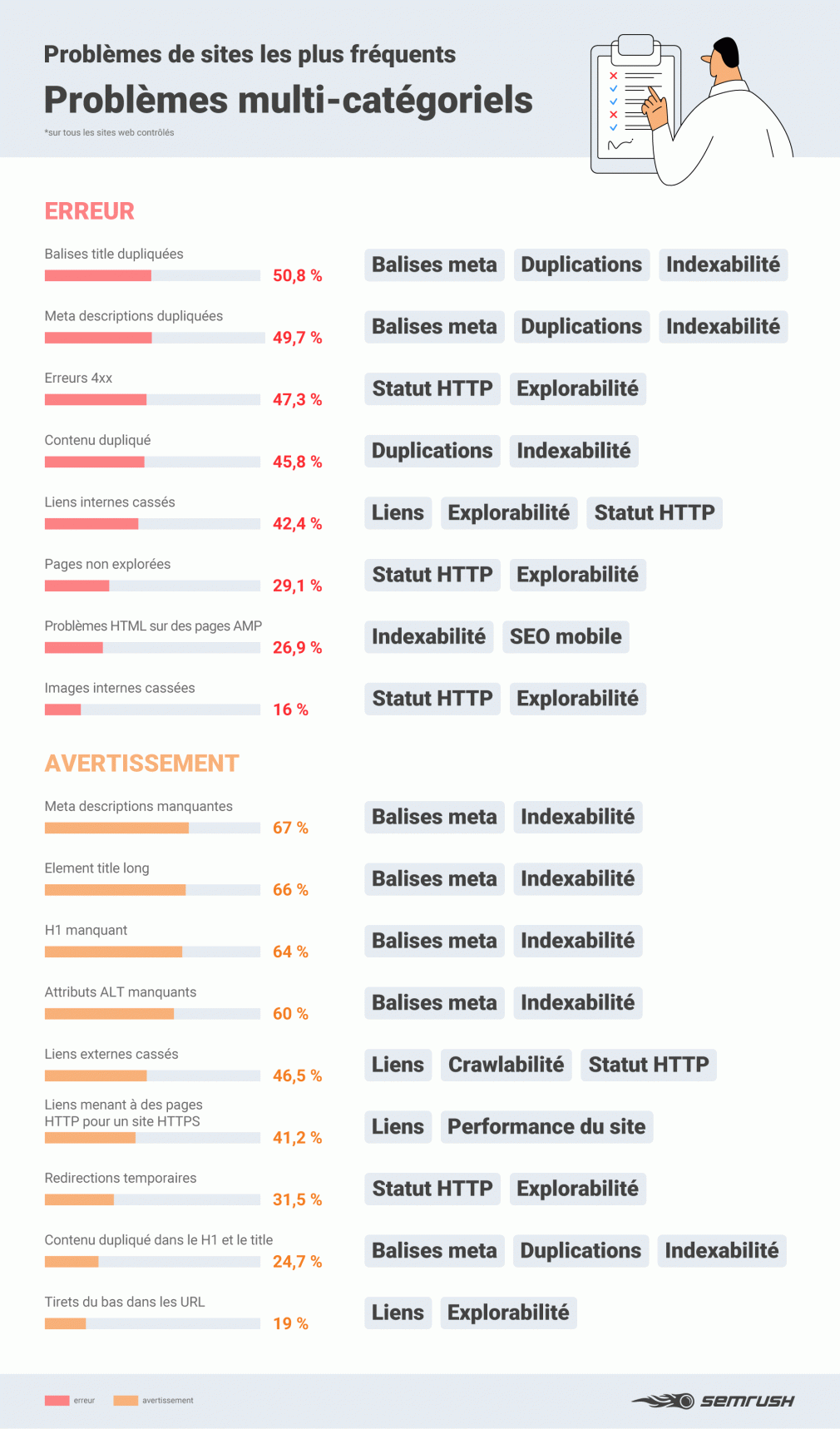

Problèmes Multi-Catégoriels

Dans certains cas, les erreurs, les avertissements et les avis relevés par l'outil Audit de site relèvent de plusieurs catégories.

Cela signifie qu'ils peuvent être à l'origine d'une série de problèmes pour votre site web, comme illustré ci-dessous, et il est donc recommandé de les traiter en priorité.

L'importance des Outils d'Audit de Site, des Conseils et des Astuces

Si vous commettez l'une de ces erreurs SEO, votre site web risque de ne pas atteindre son plein potentiel. Il est donc essentiel que vous les contrôliez en tant que webmaster en procédant à des audits réguliers de votre site.

Que vous souffriez de problèmes d'explorabilité empêchant les pages d'être indexées, ou de problèmes de duplication risquant d'entraîner des pénalités, vous pouvez utiliser cette checklist pour éviter que les taupinières ne deviennent des montagnes.

Prenez l'habitude de veiller à la santé de votre SEO et de votre UX à l'aide d'outils comme Audit de site et vous serez récompensé par le type de visibilité sur les moteurs de recherche et d'engagement des utilisateurs qui aura un impact positif sur votre chiffre d'affaires.